涉及的路径配置根据自己的实际情况配置

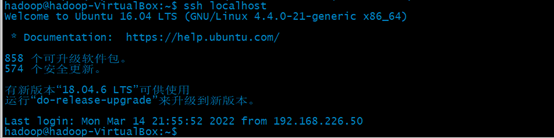

一、配置免密登录

1.安装openssh-server

sudo apt-get install openssh-server

2.生成密钥

ssh-keygen -t rsa

3.进行公钥复制

cat ./id_rsa.pub >> ./authorized_keys

4.登录localhost:

ssh localhost(不需要密码直接登录)

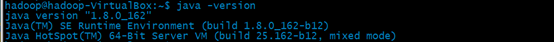

二、Java环境配置

2.在opt目录下创建一个hadoop的文件夹存放hadoop和jdk

sudo mkdir /opt/hadoop

3.将jdk-8u162-linux-x64.tar.gz解压至/opt/Hadoop

sudo tar -zxvf jdk-8u162-linux-x64.tar.gz -C /opt/hadoop/

4.在/etc/profile中配置Java环境变量

export JAVA_HOME=/opt/hadoop/jdk1.8.0_162

export PATH=$JAVA_HOME/bin:$PATH

5.验证java环境

java -version

.

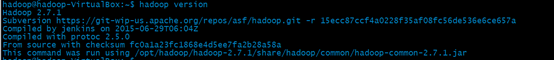

三、hadoop的配置

sudo tar -zxvf hadoop-2.7.1.tar.gz -C /opt/hadoop/

2.在/etc/profile中配置hadoop环境变量

export HADOOP_HOME=/opt/hadoop/hadoop-2.7.1

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

3.验证hadoop

3.验证hadoop

4. Hadoop伪分布式下配置文件的设置

cd /opt/hadoop/hadoop-2.7.1/etc/hadoop/

修改core-site.xml

添加:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/opt/hadoop/hadoop-2.7.1/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

修改hdfs-site.xml

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/opt/hadoop/hadoop-2.7.1/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/opt/hadoop/hadoop-2.7.1/tmp/dfs/data</value>

</property>

</configuration>

修改 hadoop-env.sh

将内部 export JAVA_HOME=${JAVA_HOME} 修改为

export JAVA_HOME=/opt/hadoop/jdk1.8.0_162

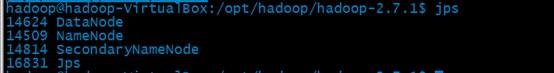

5.格式化namenode

cd /opt/hadoop/hadoop-2.7.1

./bin/hdfs namenode -format

- ./sbin/start-dfs.sh 开启 NameNode 和 DataNode 守护进程

验证

访问 Web 界面 http://localhost:50070 (hadoop版本不一样端口也会不一样)查看 NameNode 和 Datanode 信息

仅供溪溪访问 !!!