文章目录

整体流程概览

系统:windows10

Jre8 => hadoop安装与配置 => HDFS格式化 => 开启服务

前排提示,HIVE整体配置篇幅较长,可收藏后慢慢操作。

大佬们有相关编写建议也可以多多指导!

jre环境

jre安装

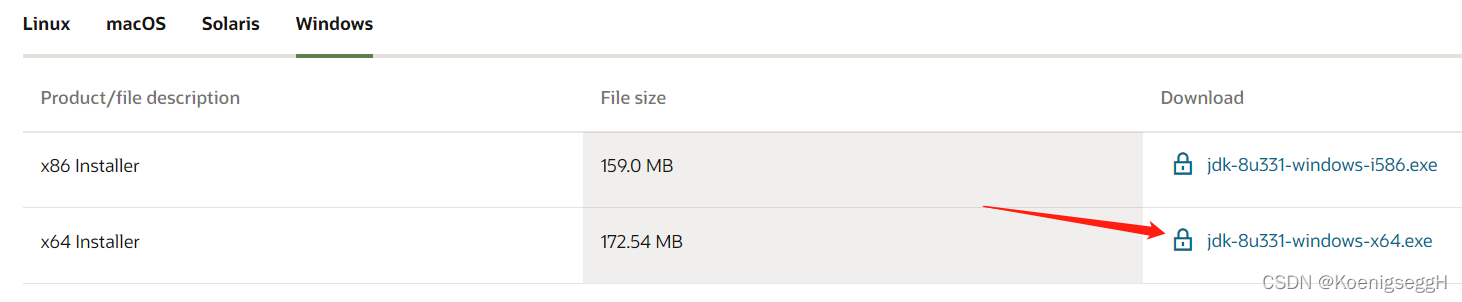

- 打开官网,选择windows64位的安装包即可

Orcal官网的下载需要账号登陆,邮箱注册即可,全程无收费点。

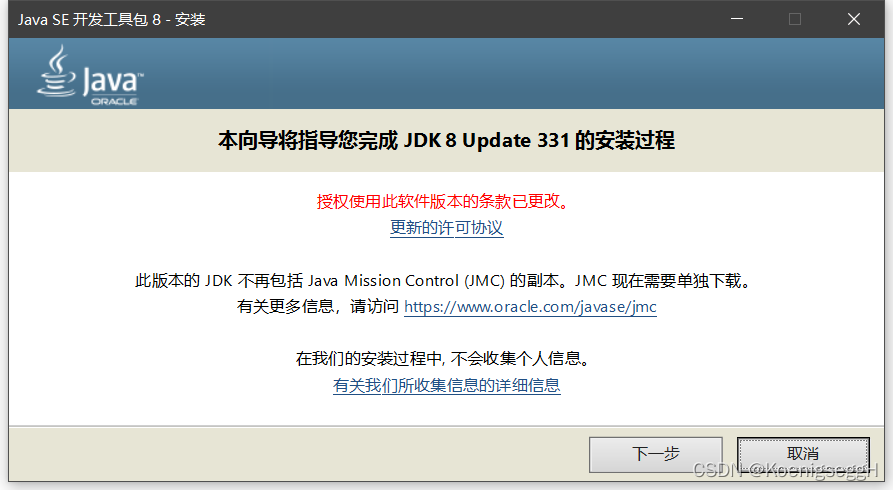

- 按照提示直接安装

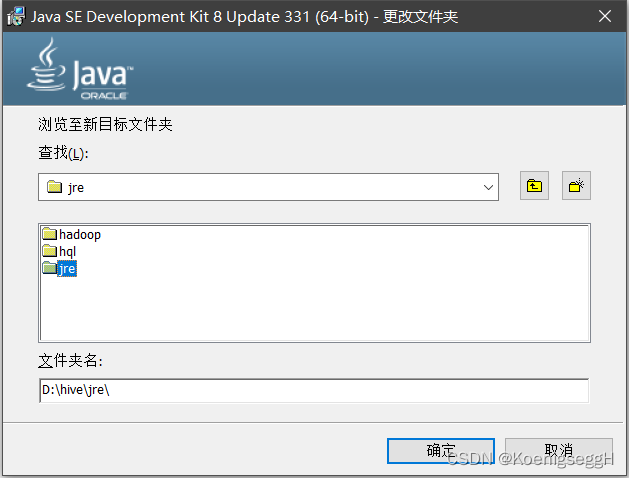

这里位置可以自定义一下,安装位置要牢记

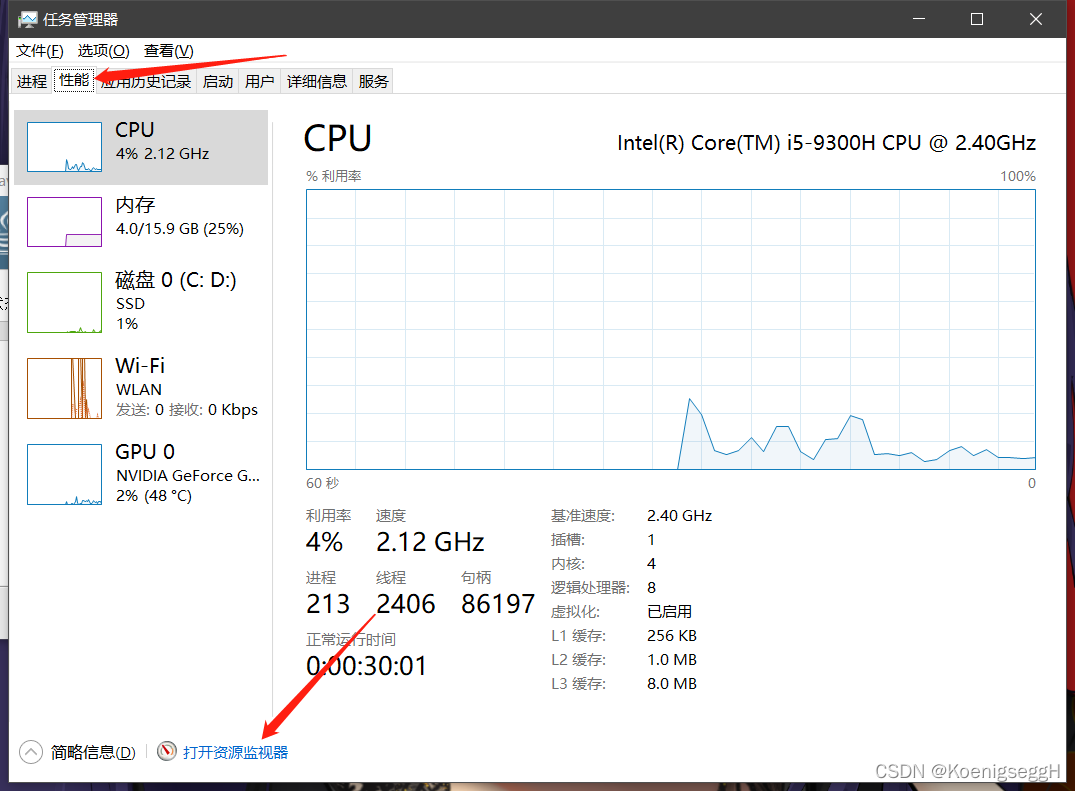

- 安装过程中可能会提示程序占用,并给出

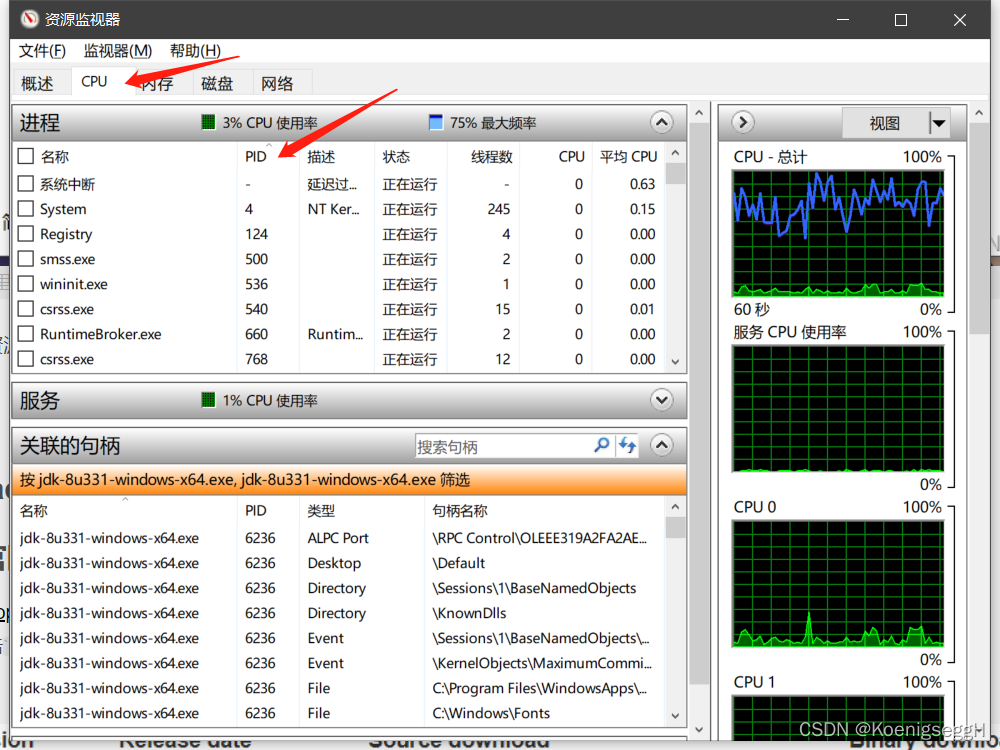

PID,Ctrl+Alt+Delete调出任务管理器,先后选择性能、资源监视器

- 在资源监视器中搜索PID,找到相应进程后右击,选择

结束进程即可(点击PID排序后更好找一些,CPU中找不到时切换至内存、磁盘即可)

- 处理掉占用的进程后会再选一次安装位置,这里

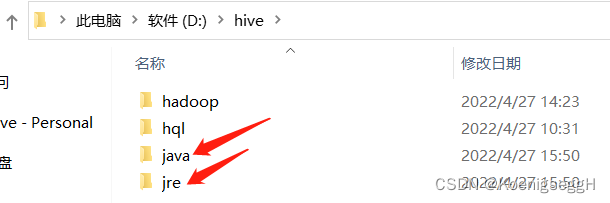

个人原因,选择安装在了指定目录下

文件夹jre为步骤2中选择的位置,文件夹java为第二次选择的位置

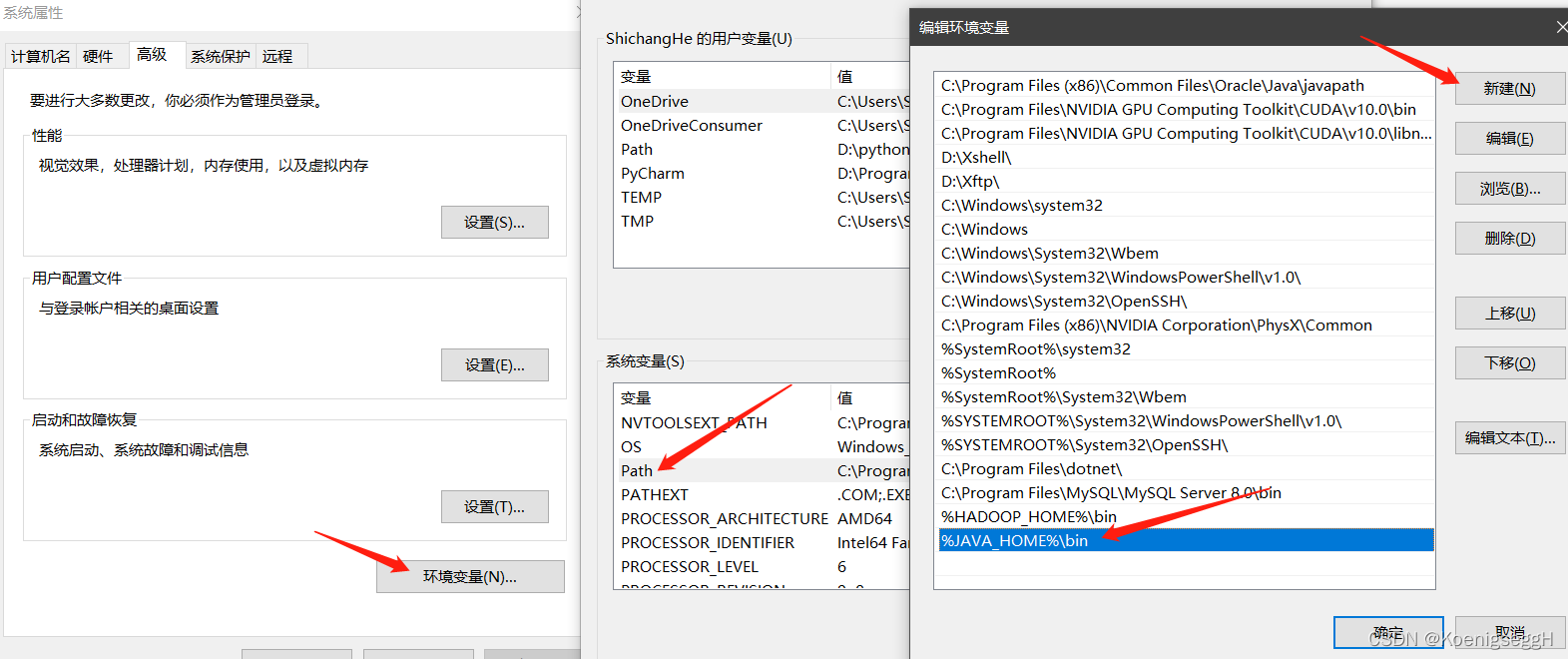

jre环境变量配置

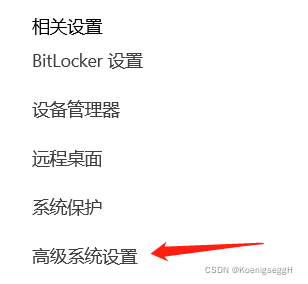

- 右击

此电脑选择属性,在右边找到高级系统设置

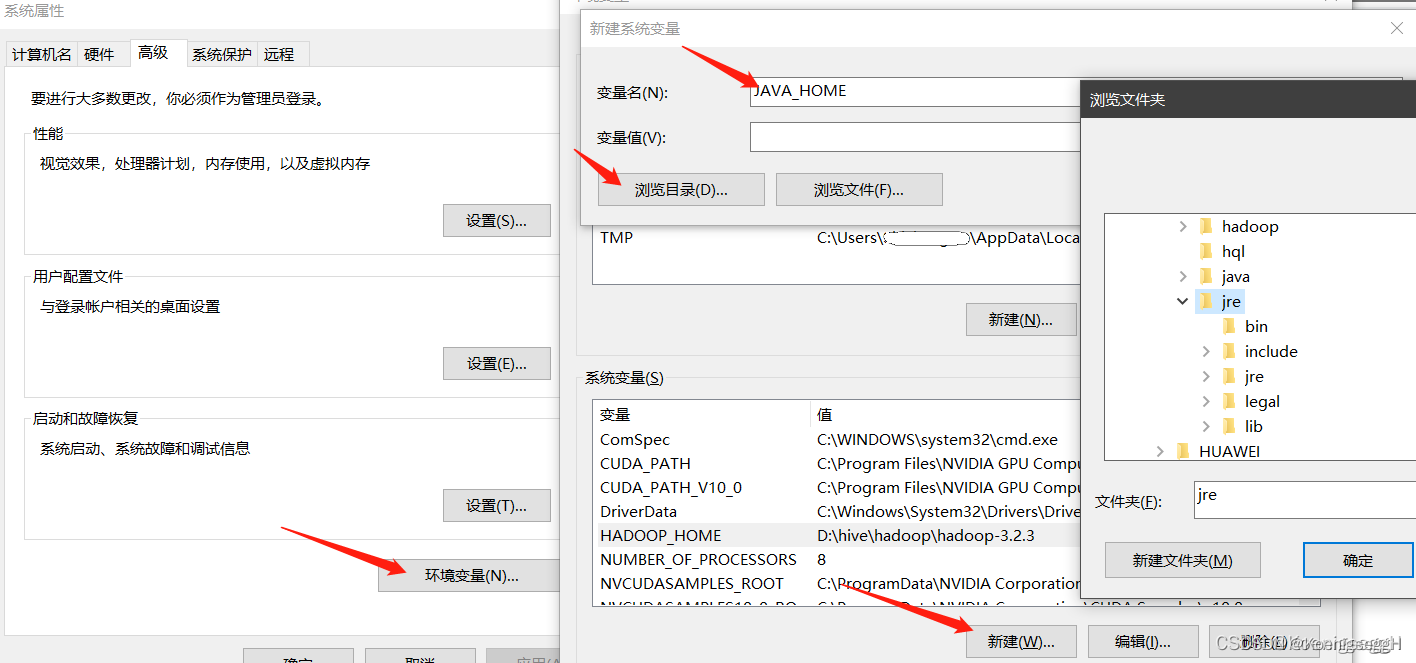

- 依次点击

环境变量、新建,输入变量名JAVA_HOME,点击浏览目录,选择jre安装的位置

- 点击

环境变量,在系统变量中找到Path并双击,点击新建,输入%JAVA_HOME%\bin

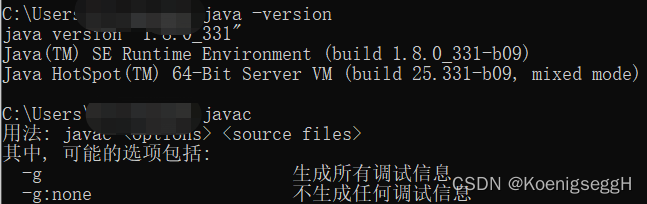

- 测试

jre,在cmd中输入java -version与javac进行测试

Hadoop安装与配置

官网下载步骤

- 点击

Download,进入下载界面

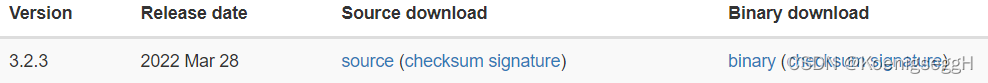

- 选择

Binary download下的最新版本即可

Source Download表示源代码版,需要编译后使用

Binary Download表示可执行版,直接解压使用

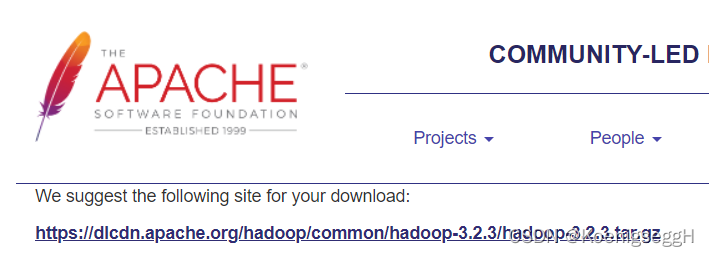

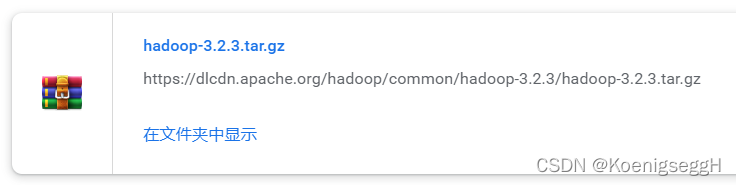

- 点击该条链接进行压缩包下载,结果如图所示:

- 下载完成后解压到指定目录即可,解压位置要牢记

这里需要以管理员方式运行

windows中管理员方式解压文件

清华镜像下载步骤

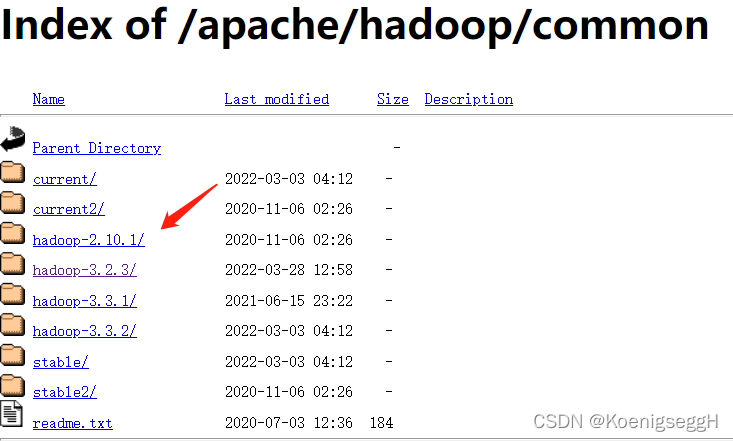

- 选择需要的版本

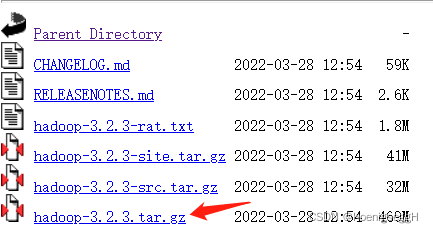

- 选择tar.gz文件

- 下载完成后解压即可,同样需要以管理员身份运行

windows中管理员方式解压文件

Hadooponwindows下载

Hadooponwindows

提取码:q1p2

原始Hadooponwindows版本可在github中搜索Hadooponwindows得到

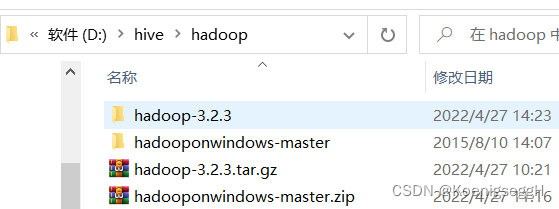

- 下载后与hadoop压缩包放置于同一目录下

- 解压

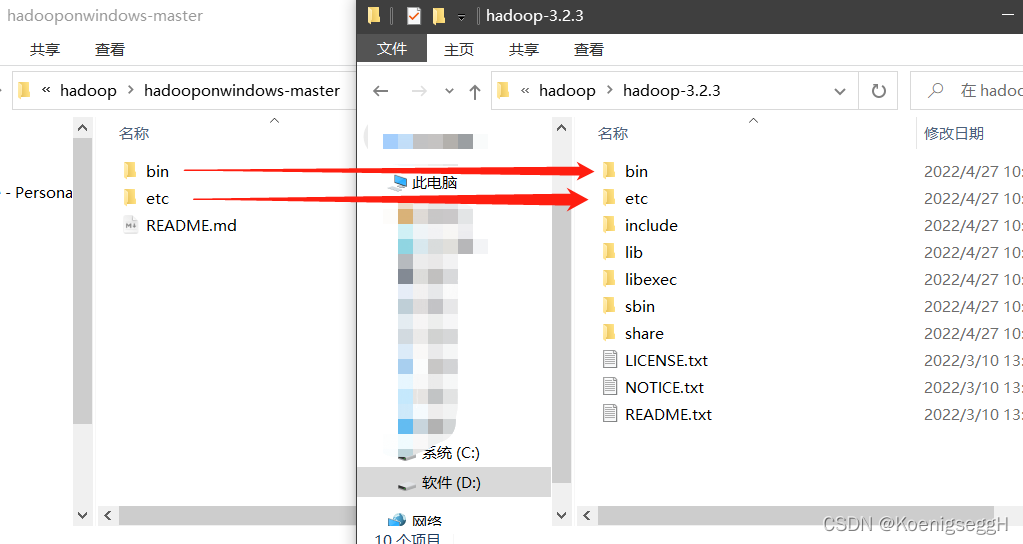

hadooponwindows - 将hadooponwindows中的bin与etc复制到hadoop目录下(建议提前备份hadoop中的bin与etc文件夹)

配置系统变量

- 右击

此电脑选择属性,在右边找到高级系统设置

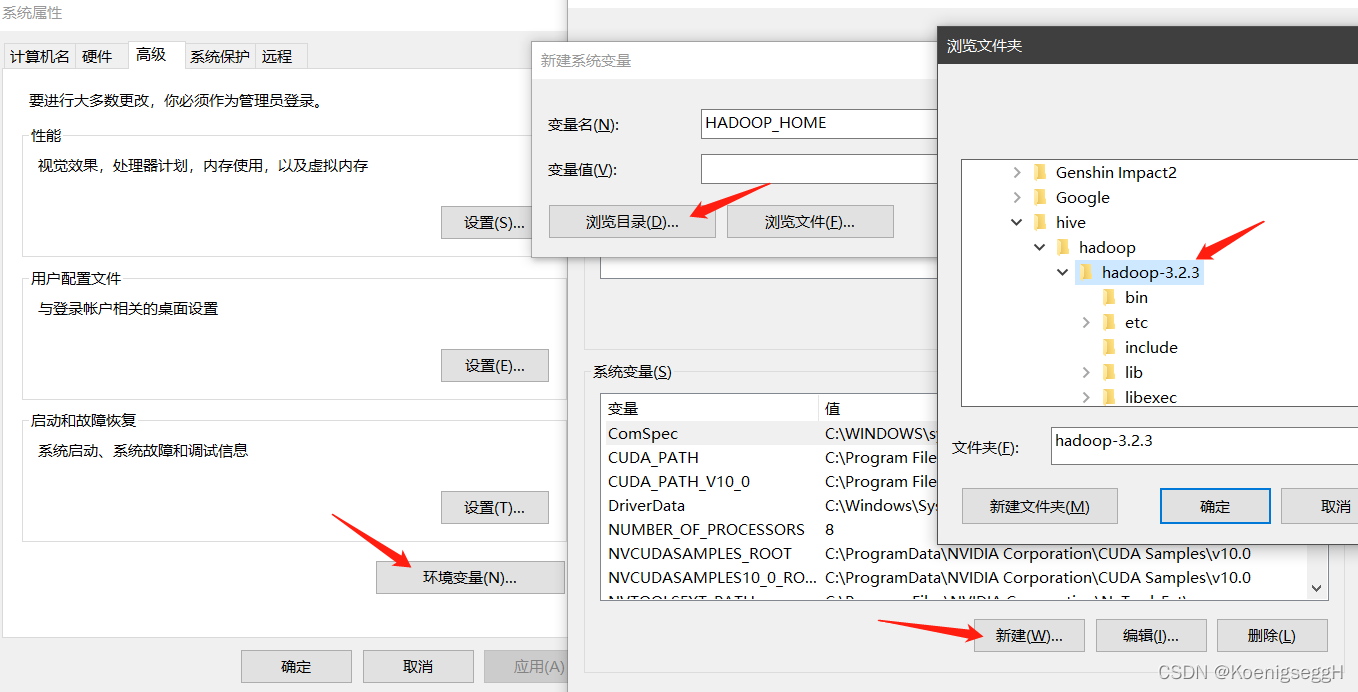

- 依次点击

环境变量``新建,输入变量名HADOOP_HOME点击浏览目录,选择hadoop安装的位置

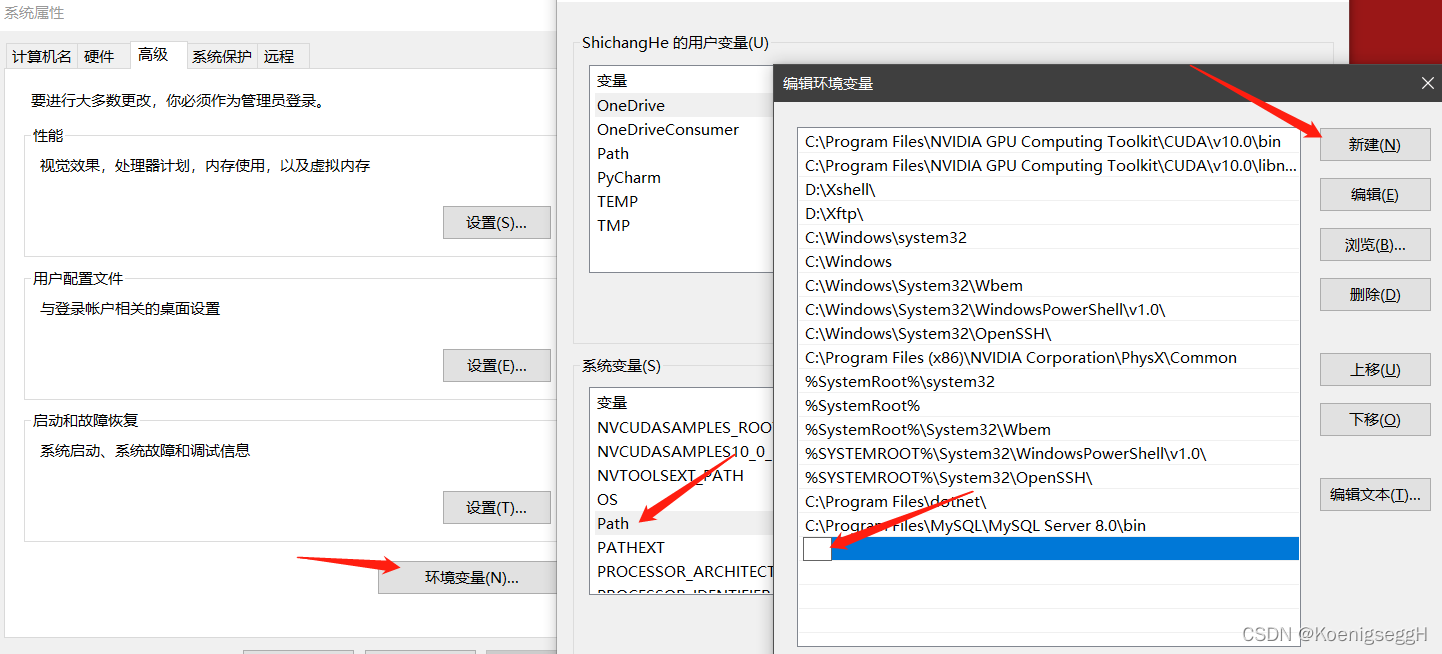

- 点击

环境变量,在系统变量中找到Path并双击,点击新建,输入%HADOOP_HOME%\bin

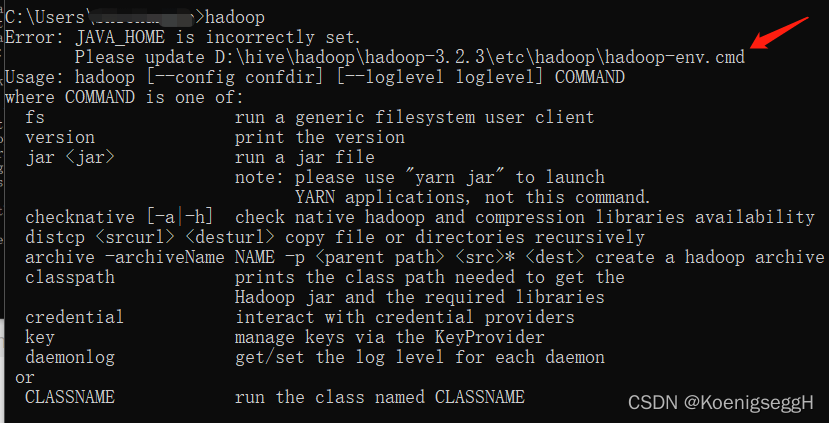

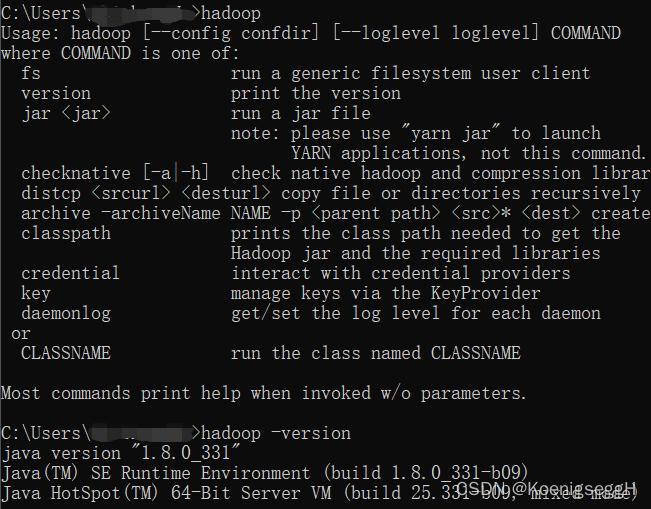

- 测试

hadoop,在cmd中输入hadoop进行测试,发现报错

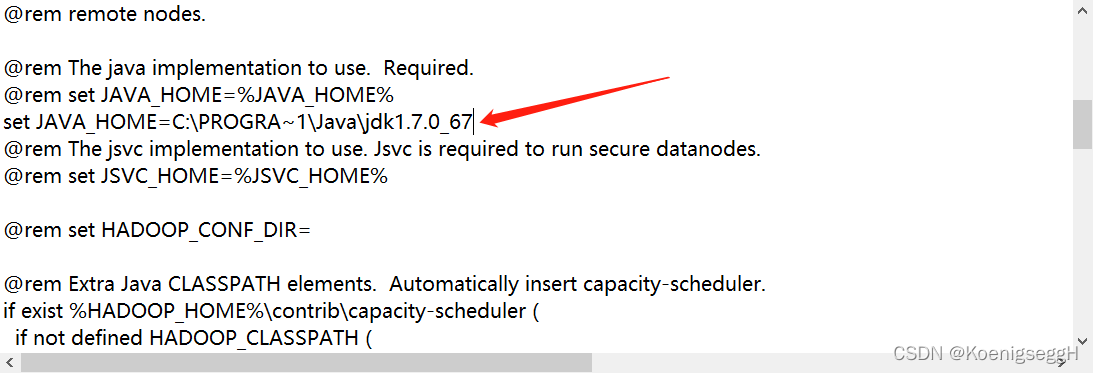

以文本形式打开对应位置的cmd文件,发现JAVA_HOME配置错误

修正后重新测试

问题解决

hadoop初始文件配置

为方便查看,这里先贴上自己hadoop的路径,也就是之前的解压路径

D:\hive\hadoop\hadoop-3.2.3\

该目录下的内容:

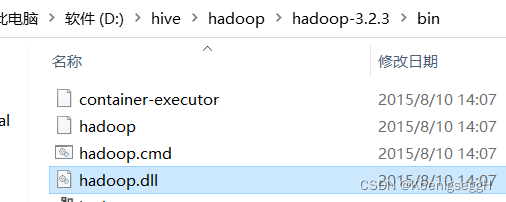

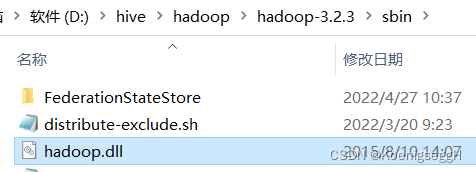

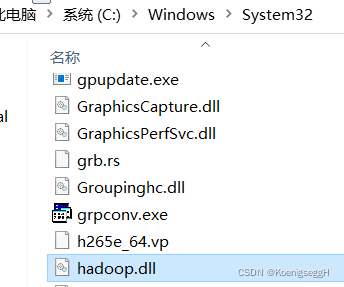

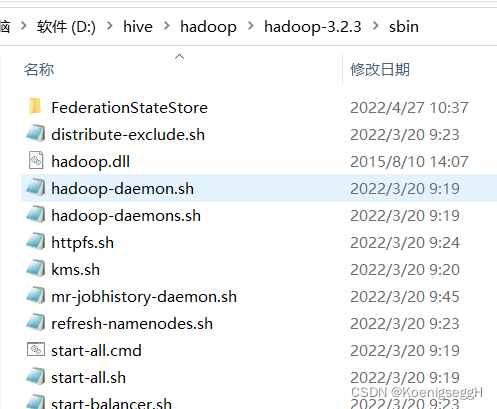

hadoop.dll文件复制

文件路径:D:\hive\hadoop\hadoop-3.2.3\bin\hadoop.dll

目标路径1:D:\hive\hadoop\hadoop-3.2.3\sbin

目标路径2:C:\Windows\System32

配置文件修改

- 来到hadoop路径

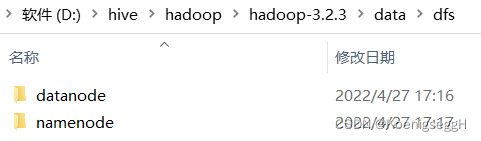

D:\hive\hadoop\hadoop-3.2.3\下,创建若干文件夹以及文件:

文件夹1:D:\hive\hadoop\hadoop-3.2.3\data

文件夹2:D:\hive\hadoop\hadoop-3.2.3\data\dfs

文件夹3:D:\hive\hadoop\hadoop-3.2.3\data\dfs\datanode

文件夹4:D:\hive\hadoop\hadoop-3.2.3\data\dfs\namenode

- 文件修改

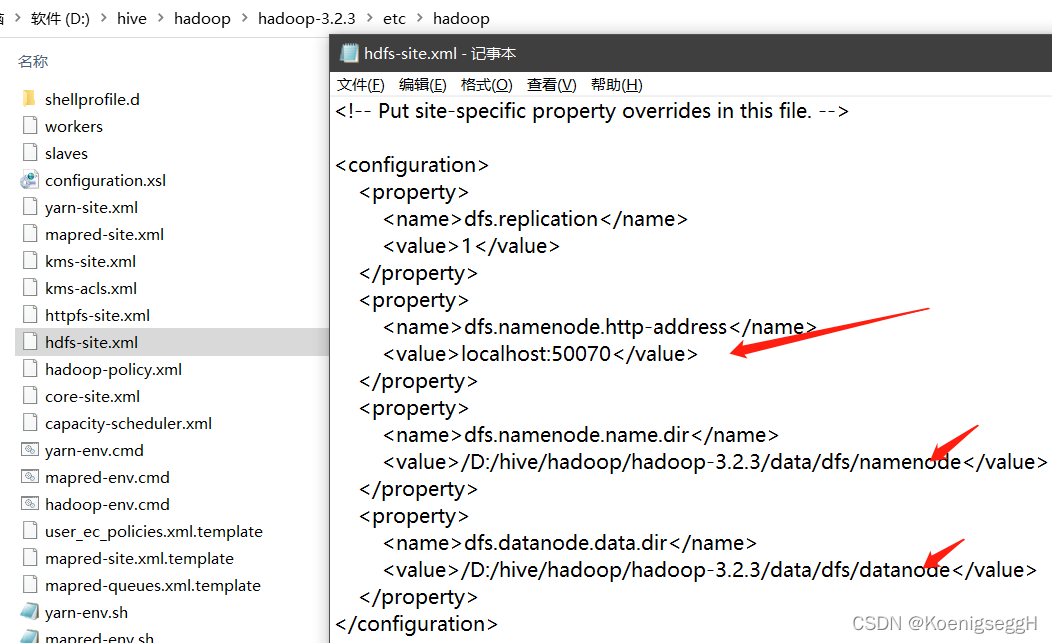

文件1:D:\hive\hadoop\hadoop-3.2.3\etc\hadoop\hdfs-site.xml

- 增加http-address字段

- 修正后两个字段中的路径信息为上一步骤中所创建的信息

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.http-address</name>

<value>localhost:50070</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/D:/hive/hadoop/hadoop-3.2.3/data/dfs/namenode</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/D:/hive/hadoop/hadoop-3.2.3/data/dfs/datanode</value>

</property>

</configuration>

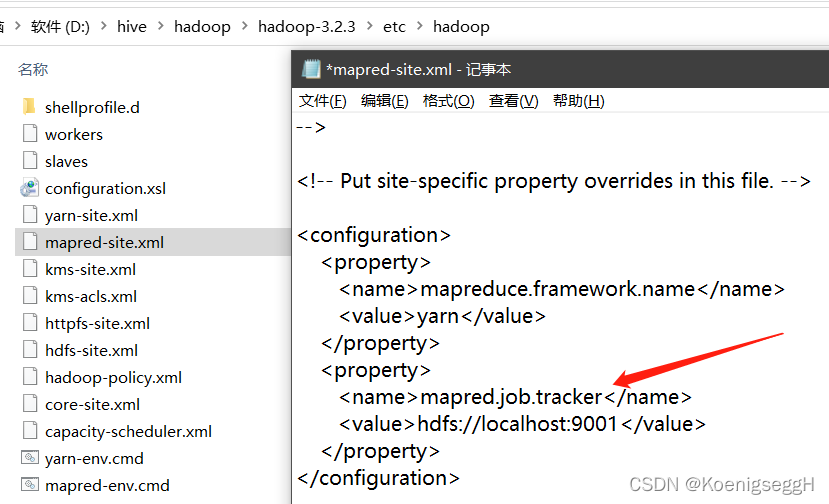

文件2:D:\hive\hadoop\hadoop-3.2.3\etc\hadoop\mapred-site.xml

主要是tracker字段的添加

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapred.job.tracker</name>

<value>hdfs://localhost:9001</value>

</property>

</configuration>

如果按照本文所述步骤安装至此,只用修改这2个文件即可,修改完不放心的朋友可以和大佬的这篇文章对应一下,感谢大佬指路

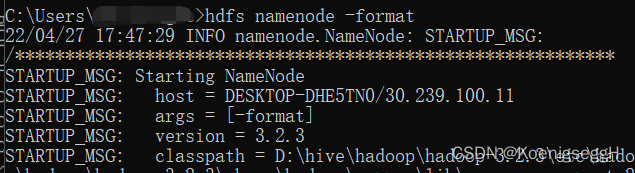

格式化HDFS

在cmd中输入hdfs namenode -format

相关服务开启

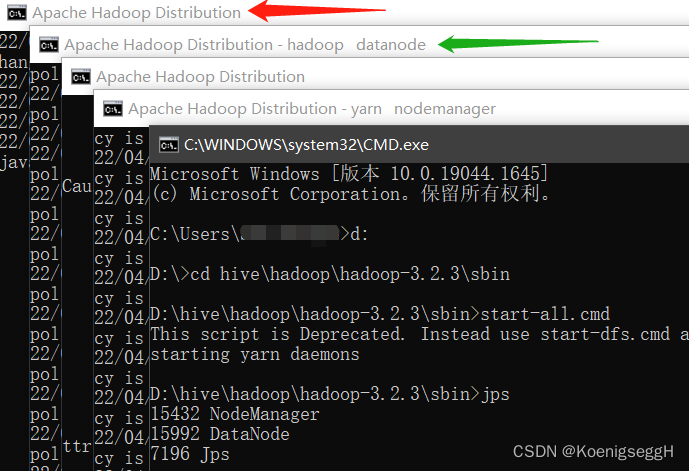

以管理员身份运行cmd,切换至D:\hive\hadoop\hadoop-3.2.3\sbin目录下,输入start-all.cmd,随后输入jps查看服务启动情况

- 目录位置:

- 运行结果:

执行

start-all.cmd之后会出现4个新的执行框,其中正确执行的会在窗口标题处增加“- 服务名称”如图中绿色箭头所示,反之如红色箭头所示

此时查看jps运行结果也不难看出,只有3个服务启动成功(最初只有2个服务可以成功启动,此图为部分修正后的结果)

服务开启过程中遇到的问题

同样先贴上自己hadoop的路径,也就是之前的解压路径

D:\hive\hadoop\hadoop-3.2.3\

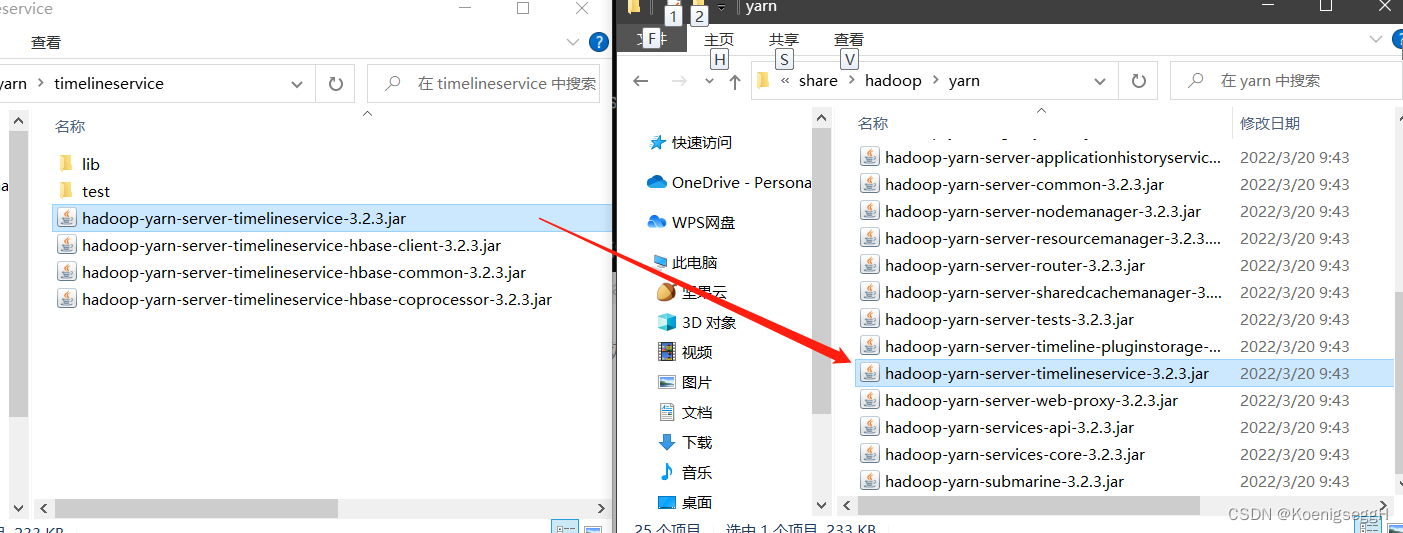

- 问题1:

java.lang.NoClassDefFoundError: org/apache/hadoop/yarn/server/timelineservice/collector/TimelineColl

解决方法:

未找到类定义,感谢大佬指路

将D:\hive\hadoop\hadoop-3.2.3\share\hadoop\yarn\timelineservice路径中的hadoop-yarn-server-timelineservice-3.2.3复制到D:\hive\hadoop\hadoop-3.2.3\share\hadoop\yarn即可

- 问题2:

org.apache.hadoop.io.nativeio.NativeIO$POSIX...

解决方法:

hadoop.dll版本不匹配,感谢大佬指路

安装时采用了hadoop==3.2.3,但是hadooponwindows中的hadoop版本为2.0,在大佬提示的git中下载hadoop.dll的3.0版本,之后复制到D:\hive\hadoop\hadoop-3.2.3\bin下即可

Github链接

- 问题3:

Exiting with status 1: java.io.FileNotFoundException: D:\hive\hadoop\hadoop-3.2.3\data\dfs\namenode\current\VERSION (拒绝访问。)

解决方法:

未以管理员方式运行。

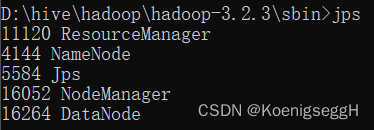

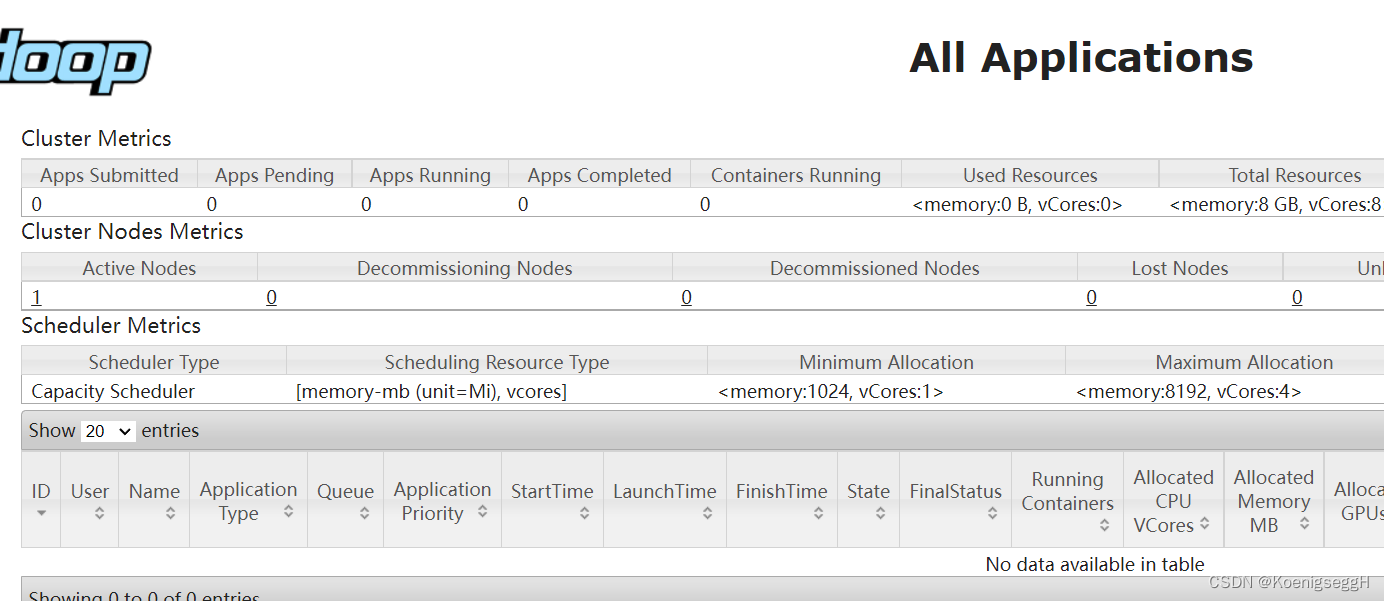

开启服务后的验证

- 切换至

D:\hive\hadoop\hadoop-3.2.3\sbin目录下,输入start-all.cmd,随后输入jps查看服务启动情况

可见所有服务均已正常启动

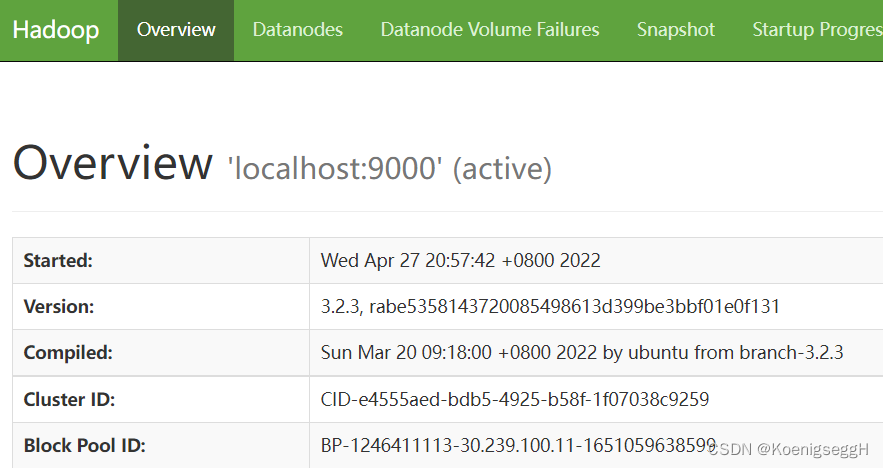

- 在Chrome地址栏输入

http://localhost:50070查看Hadoop状态

- Chrome输入

http://localhost:8088查看集群状态