第六章 数据同步:主从库如何实现数据一致 ?

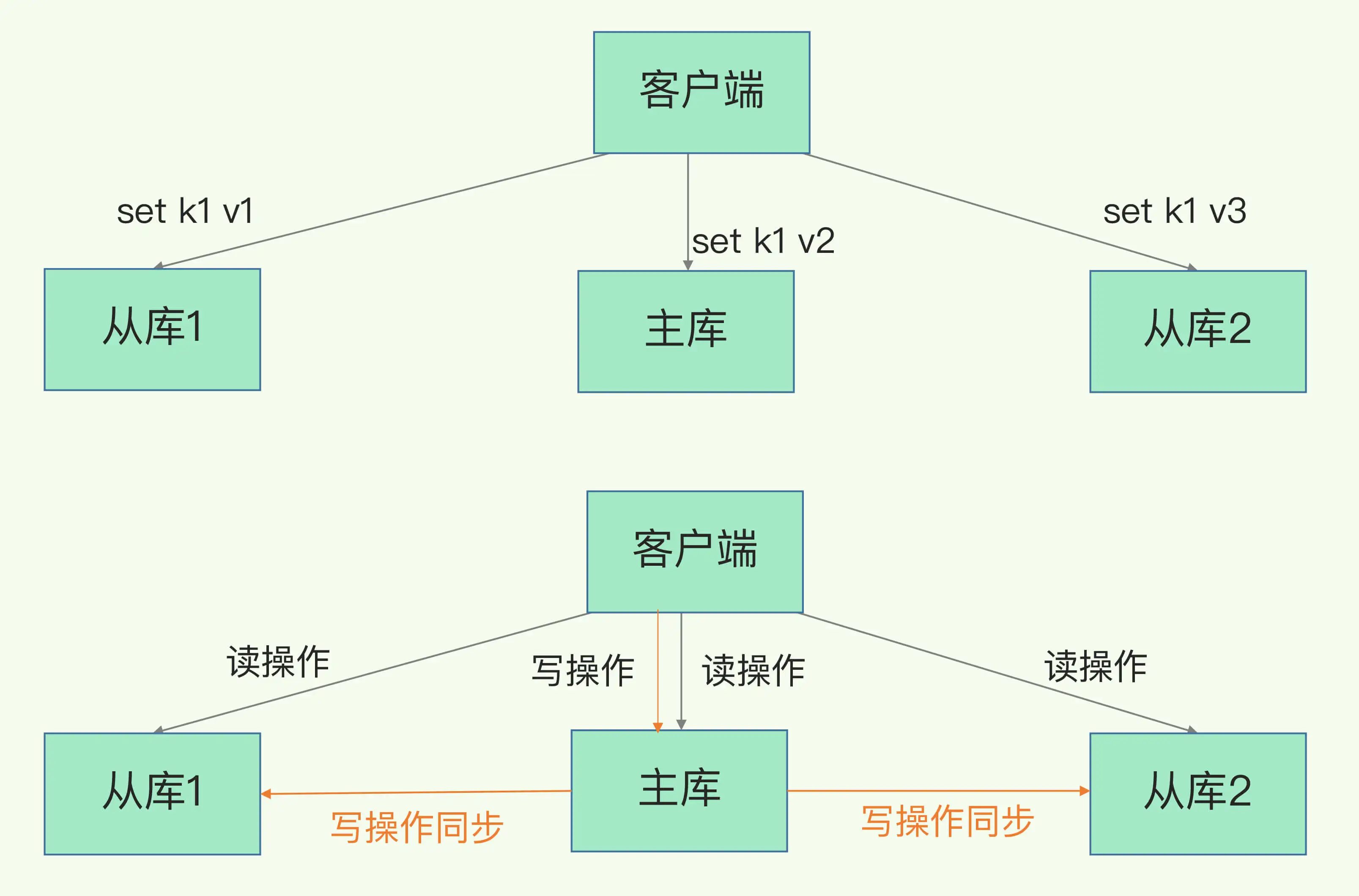

Redis 提供了主从库模式,以保证数据副本的一致,主从库之间采用的是读写分离的方式。

读操作:主库、从库都可以接收;

写操作:首先到主库执行,然后,主库将写操作同步给从库。

主从库间如何进行第一次同步 ?

关于

replicaof命令

主从库间的第一次同步:多个Redis实例之间可以通过replicaof命令形成主库和从库的关系。

例如,现在有实例 1(ip:172.16.19.3)和实例 2(ip:172.16.19.5),我们在实例 2 上执行以下这个命令后,实例 2 就变成了实例 1 的从库,并从实例 1 上复制数据:

replicaof 172.16.19.3 6379

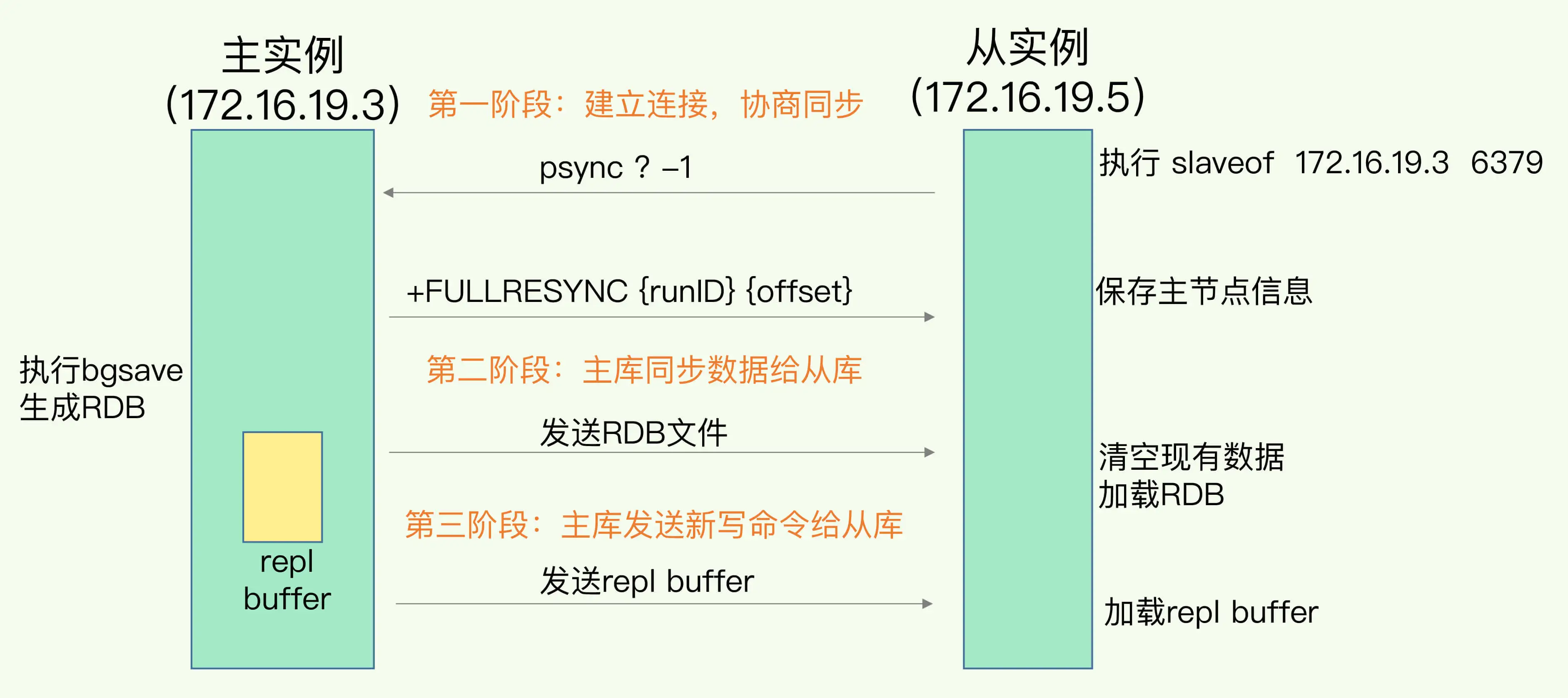

主从库间数据第一次同步的三个阶段 :

- 第一阶段:从库和主库建立起连接,并告诉主库即将进行同步,主库确认回复后,主从库间就可以开始同步了。

- 从库给主库发送 psync 命令,表示要进行数据同步,主库根据这个命令的参数来启动复制。psync 命令包含了主库的 runID 和复制进度 offset 两个参数。

- runID,是每个 Redis 实例启动时都会自动生成的一个随机 ID,用来唯一标记这个实例。当从库和主库第一次复制时,因为不知道主库的 runID,所以将 runID 设为“?”。

- offset,此时设为 -1,表示第一次复制。

- 主库收到 psync 命令后,会用 FULLRESYNC 响应命令带上两个参数:主库 runID 和主库目前的复制进度 offset,返回给从库。从库收到响应后,会记录下这两个参数。

- 需要注意:FULLRESYNC 响应表示第一次复制采用的全量复制,也就是说,主库会把当前所有的数据都复制给从库。

- 从库给主库发送 psync 命令,表示要进行数据同步,主库根据这个命令的参数来启动复制。psync 命令包含了主库的 runID 和复制进度 offset 两个参数。

- 第二阶段:主库将所有数据同步给从库。从库收到数据后,在本地完成数据加载。这个过程依赖于内存快照生成的 RDB 文件。

- 主库执行 bgsave 命令,生成 RDB 文件,接着将文件发给从库。

- 从库接收到 RDB 文件后,会先清空当前数据库,然后加载 RDB 文件。

- 在主库将数据同步给从库的过程中,主库不会被阻塞,仍然可以正常接收请求。否则,Redis 的服务就被中断了。

- 但是,这些请求中的写操作并没有记录到刚刚生成的 RDB 文件中。为了保证主从库的数据一致性,主库会在内存中用专门的

replication buffer,记录 RDB 文件生成后收到的所有写操作。

- 第三阶段:当主库完成 RDB 文件发送后,就会把此时

replication buffer中的修改操作发给从库,从库再重新执行这些操作。这样一来,主从库就实现同步了。

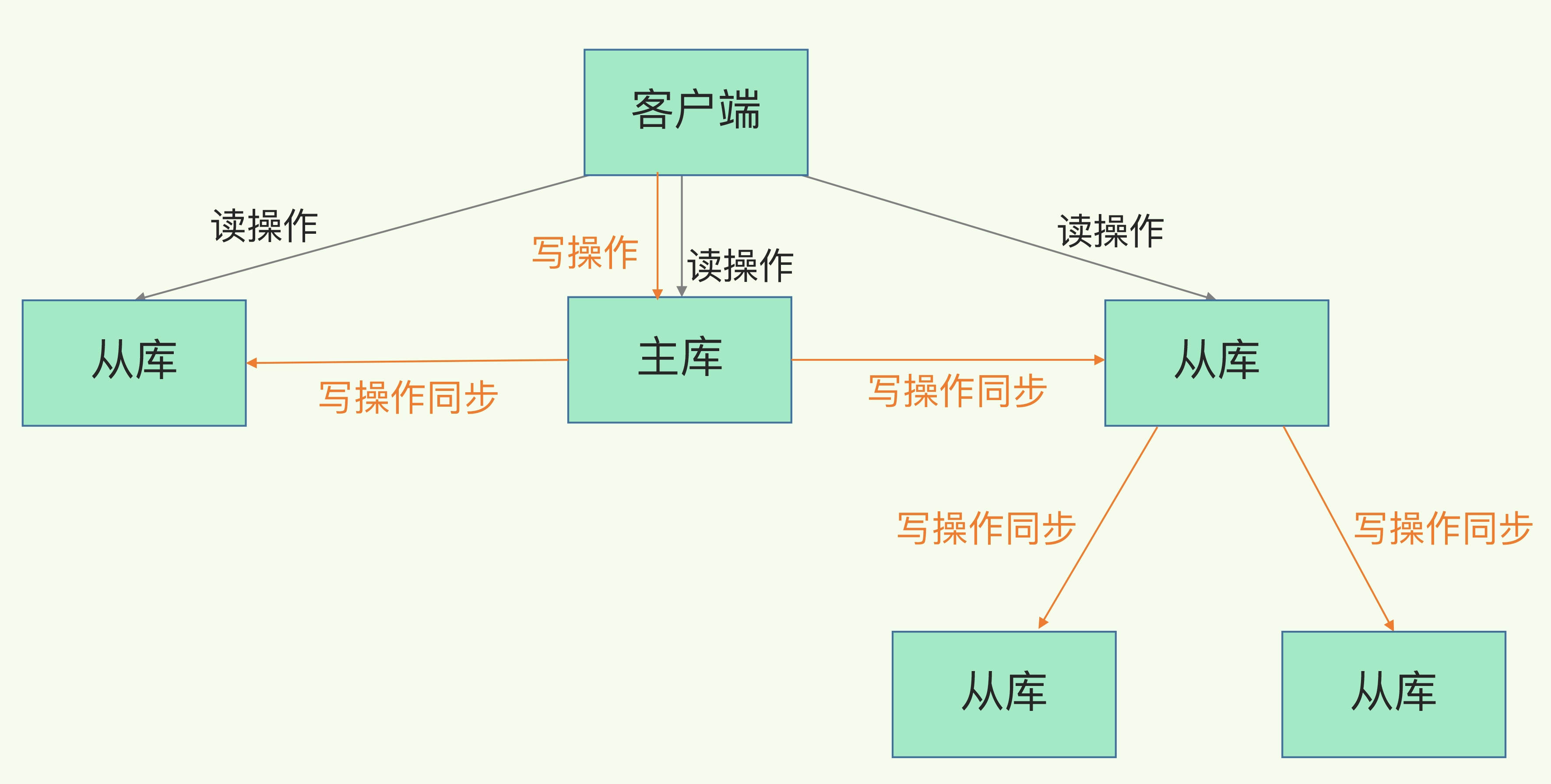

主从级联模式 (主从从) 分担全量复制时的主库压力

在主从库间第一次数据同步,对主库来说有两个耗时的操作:

- 生成 RDB 文件

- fork 子进程这个操作会阻塞主线程处理正常请求,从而导致主库响应应用程序的请求速度变慢。

- 传输 RDB 文件

- 传输RDB文件会占用主库的网络带宽,同样会给主库的资源使用带来压力。

针对上面两个耗时操作,“主-从-从” 模式可以有效分担主库的压力

- 通过 “主 - 从 - 从” 模式将主库生成 RDB 和传输 RDB 的压力,以级联的方式分散到从库上。

- 在部署主从集群的时候,可以手动选择一个内存资源配置较高的从库,用于级联其他的从库。

- 然后,可以再选择一些从库,在这些从库上执行如下命令,让它们和刚才所选的从库,建立起主从关系。

replicaof 所选从库的IP 6379

- 这样一来,这些从库就会知道,在进行同步时,不用再和主库进行交互了,只要和级联的从库进行写操作同步就行了,这就可以减轻主库上的压力,如下图所示:

“主从从” 模式能够减少主库同步给所有从库的压力; 一旦主库和从库完成全量复制,它们之间就会一直维护一个网络连接,主库会把之后收到的命令通过这个连接同步给从库,这个过程就称为基于

长连接的命令传播。

主从库间网络断了怎么办 ?

Redis 2.8 之前,如果主从库在命令传播时出现了网络闪断,那么,从库就会和主库重新进行一次全量复制,开销非常大。

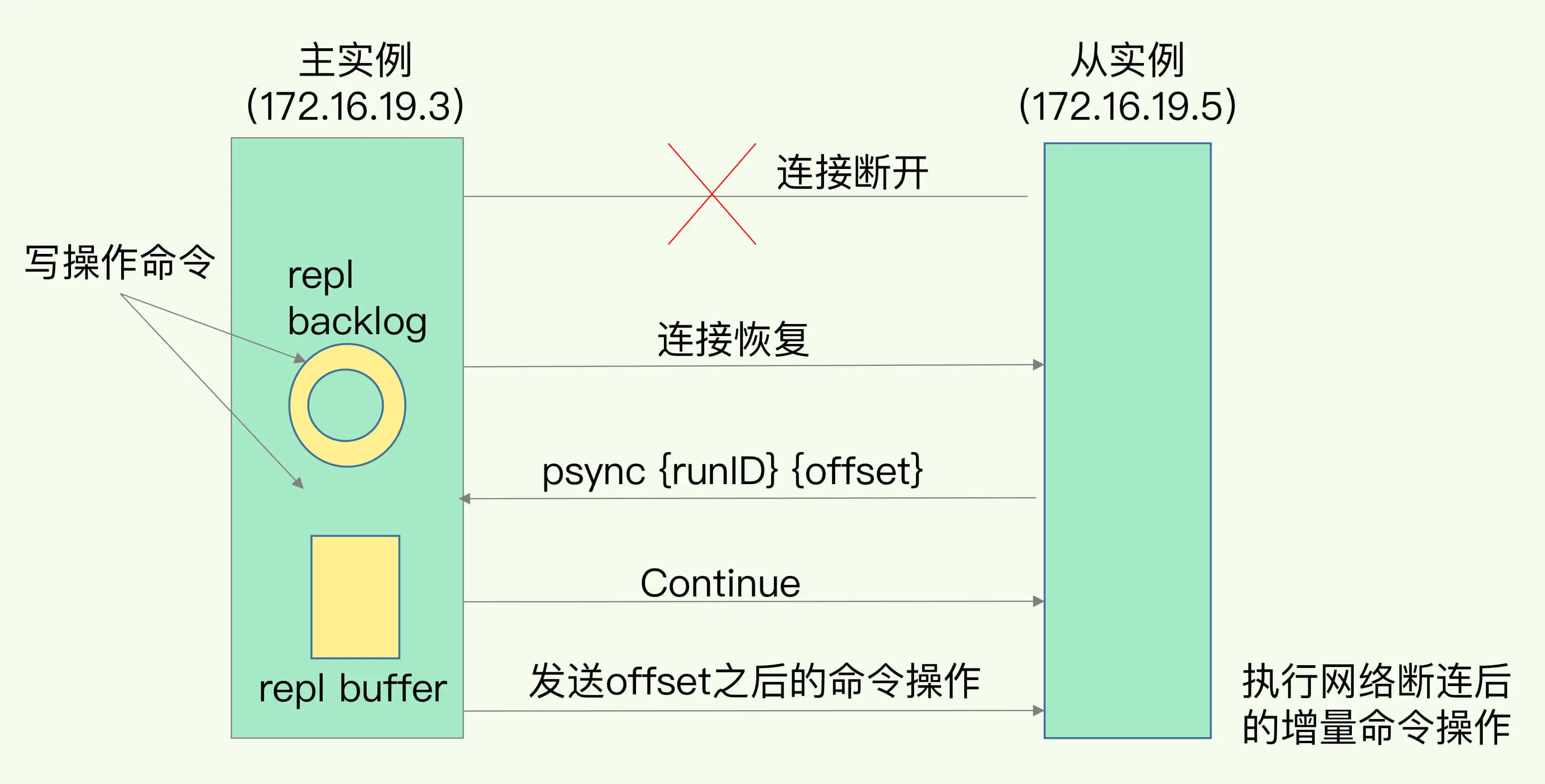

从 Redis 2.8 开始,网络断了之后,主从库会采用 增量复制 的方式继续同步。

全量复制 和 增量复制 有什么区别 ?

- 全量复制是同步所有数据。

- 而增量复制只会把主从库网络断连期间主库收到的命令,同步给从库。

增量复制时,主从库之间具体是怎么保持同步的 ?

- 当主从库断连后,主库会把断连期间收到的写操作命令,写入 replication buffer,当从库断连又重连之后,通过 psync 命令告诉主库自己的 slave_repl_offset,然后主库根据自己的master_repl_offset 和 slave_repl_offset 来判断是需要全量同步还是把两者之间的命令增量同步给从库

- 同步的方式就是通过主库与每个从库建立连接之后的这个所谓的 replication buffer

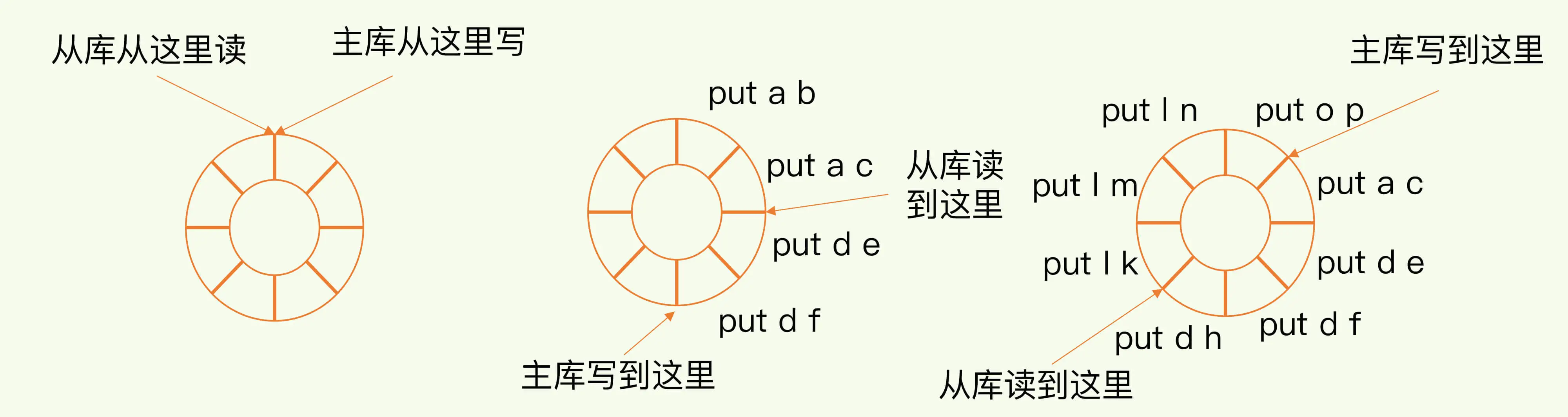

repl_backlog_buffer是一个环形缓冲区,主库会记录自己写到的位置,从库则会记录自己已经读到的位置。- 刚开始的时候,主库和从库的写读位置在一起,这算是它们的起始位置。随着主库不断接收新的写操作,它在缓冲区中的写位置会逐步偏离起始位置,我们通常用

偏移量来衡量这个偏移距离的大小,对主库来说,对应的偏移量就是master_repl_offset。主库接收的新写操作越多,这个值就会越大。 - 同样,从库在复制完写操作命令后,它在缓冲区中的读位置也开始逐步偏移刚才的起始位置,此时,从库已复制的偏移量

slave_repl_offset也在不断增加。正常情况下,这两个偏移量基本相等。 - 只要有从库存在,这个repl_backlog_buffer就会存在。主库的所有写命令除了传播给从库之外,都会在这个repl_backlog_buffer中记录一份,缓存起来,只有预先缓存了这些命令,当从库断连后,从库重新发送psync $master_runid o f f s e t , 主 库 才 能 通 过 offset,主库才能通过 offset,主库才能通过offset在repl_backlog_buffer中找到从库断开的位置,只发送$offset之后的增量数据给从库即可。

- 主从库的连接恢复之后,从库首先会给主库发送

psync命令,并把自己当前的slave_repl_offset发给主库,主库会判断自己的master_repl_offset和slave_repl_offset之间的差距,来决定是进行增量复制还是全量复制。 - 此时,主库只用把

master_repl_offset和slave_repl_offset之间的命令操作同步给从库就行。 - 就像示意图的中间部分,主库和从库之间相差了

put d e和put d f两个操作,在增量复制时,主库只需要把它们同步给从库就行了。

增量复制的流程

repl_backlog_buffer和slave_repl_offset的区别 ?

repl_backlog_buffer是所有从库共享的,slave_repl_offset是由从库自己记录的,这也是因为每个从库的复制进度不一定相同。- 从库断连后再恢复时,会给主库发送

psync命令,并把自己当前的slave_repl_offset发给主库。 - 所以,从库推进的

slave_repl_offset是它自己记录的,不会影响到第二个从库。第二个从库断连后再恢复,只要slave_repl_offset指向的数据没有被覆盖,就能继续恢复。

repl_backlog_buffer和replication buffer的区别 ?

- repl_backlog_buffer:它是为了从库断开之后,如何找到主从差异数据而设计的环形缓冲区,从而避免全量同步带来的性能开销。

- 如果从库断开时间太久,repl_backlog_buffer 环形缓冲区就会被主库的写命令覆盖了,那么从库连上主库后只能乖乖地进行一次全量同步,

- 所以 repl_backlog_buffer 要配置尽量大一些,可以降低主从断开后全量同步的概率。

- 而在 repl_backlog_buffer 中找主从差异的数据后,如何发给从库呢?这就用到了replication buffer。

- 先在 repl_backlog_buffer 里通过offset找到差异数据,然后将这部分差异数据同步到replication buffer 后,replication buffer 才专门的将这部分数据发送给从库,达到增量同步的目的

- replication buffer:Redis和客户端通信也好,和从库通信也好,

- Redis都需要给分配一个 内存 buffer 进行数据交互,客户端是一个client,从库也是一个client,我们每个client连上Redis后,Redis都会分配一个 client buffer,所有数据交互都是通过这个buffer进行的:

- Redis先把数据写到这个buffer中,

- 然后再把buffer中的数据发到client socket中再通过网络发送出去,这样就完成了数据交互。

- 所以主从在增量同步时,从库作为一个client,也会分配一个buffer,

- 只不过这个buffer专门用来传播用户的写命令到从库,保证主从数据一致,我们通常把它叫做replication buffer。

- Redis都需要给分配一个 内存 buffer 进行数据交互,客户端是一个client,从库也是一个client,我们每个client连上Redis后,Redis都会分配一个 client buffer,所有数据交互都是通过这个buffer进行的:

- repl_backlog_buffer 这个缓冲只有在主从重连时才起作用,在主从连接正常时,即使master 覆盖了slave 的数据也没关系,因为数据都在 replication_buffer 里,

- 只要 replication_buffer 没溢出,等slave消费完了replication_buffer,slave_offset也追上去了,

- 只有等到主从重连时才会用到 repl_backlog_buffer 做判断,正常情况下repl_backlog_buffer 只是一直循环写。

- 再延伸一下,既然有这个内存buffer存在,那么这个buffer有没有限制呢?

- 如果主从在传播命令时,因为某些原因从库处理得非常慢,那么主库上的这个buffer就会持续增长,消耗大量的内存资源,甚至OOM。

- 所以Redis提供了client-output-buffer-limit 参数限制这个buffer的大小,

- 如果超过限制,主库会强制断开这个client的连接,也就是说从库处理慢导致主库内存buffer的积压达到限制后,主库会强制断开从库的连接,此时主从复制会中断,

- 中断后如果从库再次发起复制请求,那么此时可能会导致恶性循环,引发复制风暴,这种情况需要格外注意。

什么情况会导致主从库间数据不一致 ?

- 因为 repl_backlog_buffer 是一个环形缓冲区,所以在缓冲区写满后,主库会继续写入,此时,就会覆盖掉之前写入的操作。

- 如果从库的读取速度比较慢,就有可能导致从库还未读取的操作被主库新写的操作覆盖了,这会导致主从库间的数据不一致。

如何调整

repl_backlog_size,降低从库还未读取的操作被主库新写的操作覆盖的概率,从而降低增量复制时主从库数据不一致的风险 ?

- repl_backlog_size 这个参数和所需的缓冲空间大小有关。

- 缓冲空间的计算公式是:缓冲空间大小 = 主库写入命令速度 * 操作大小 - 主从库间网络传输命令速度 * 操作大小。在实际应用中,考虑到可能存在一些突发的请求压力,我们通常需要把这个缓冲空间扩大一倍

- 即 repl_backlog_size = 缓冲空间大小 * 2,这也就是 repl_backlog_size 的最终值。

为什么主从库间的复制使用 RDB 而不使用 AOF 呢 ?

- RDB文件内容是经过压缩的二进制数据(不同数据类型数据做了针对性优化),文件很小。

- 而AOF文件记录的是每一次写操作的命令,写操作越多文件会变得很大,其中还包括很多对同一个key的多次冗余操作。

- 在主从全量数据同步时,传输RDB文件可以尽量降低对主库机器网络带宽的消耗,

- 从库在加载RDB文件时,一是文件小,读取整个文件的速度会很快,

- 二是因为RDB文件存储的都是二进制数据,从库直接按照RDB协议解析还原数据即可,速度会非常快,

- 而AOF需要依次重放每个写命令,这个过程会经历冗长的处理逻辑,恢复速度相比RDB会慢得多,所以使用RDB进行主从全量同步的成本最低。

- 假设要使用AOF做全量同步,意味着必须打开AOF功能,打开AOF就要选择文件刷盘的策略,选择不当会严重影响Redis性能。

- 而RDB只有在需要定时备份和主从全量同步数据时才会触发生成一次快照。

- 而在很多丢失数据不敏感的业务场景,其实是不需要开启AOF的。