运行环境

- Ubuntu16.04

- JDK1.8

- hadoop2.7.1

- eclispe2018

所需环境链接

链接:https://pan.baidu.com/s/1HqfrArKla_VIPe2qtbC_OQ

提取码:klbx

JDK配置

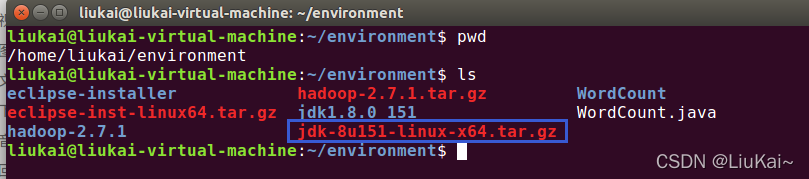

- 下载JDK压缩包 jdk-8u151-linux-x64.tar.gz

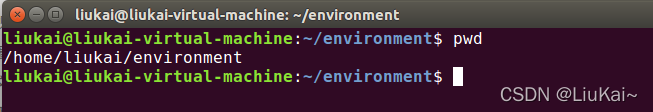

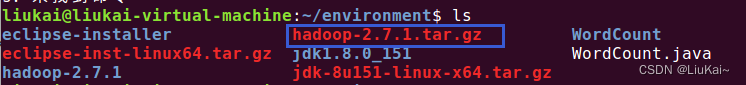

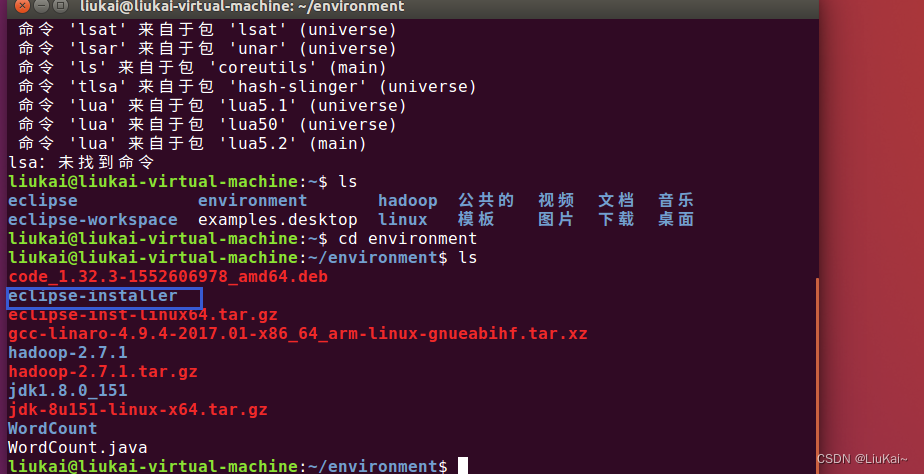

- 创建目录存放所有运行所需环境,路径如下图(可按需修改)

mkdir environment

- jdk压缩包放到environment目录下

- 解压

tar -zxvf jdk-8u151-linux-x64.tar.gz

- 进入jdk目录,并复制路径

cd jdk1.8.0_151 //进入目录

pwd //获取当前路径

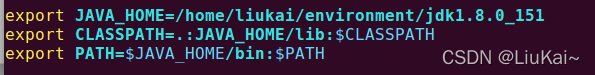

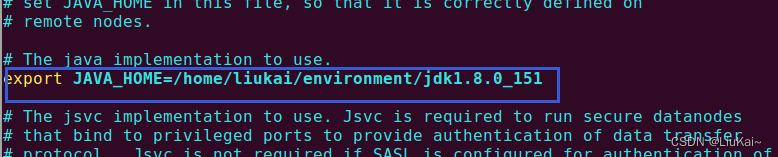

- 配置jdk环境变量,在结尾添加内容如下

sudo vi /etc/profile

JAVA_HOME为刚才复制的路径

source /etc/profile

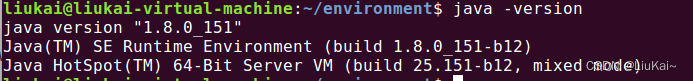

- 输入java -version查看是否成功

hadoop配置

- 将下载的hadoop压缩包放到新建的environment文件夹(放jdk的那个)

- 解压hadoop

tar -zxvf hadoop-2.7.1.tar.gz

- 进入hadoop目录,并复制路径

cd hadoop-2.7.1

pwd

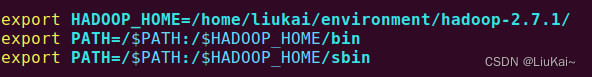

- 配置hadoop环境变量,在结尾添加内容如下

sudo vim /etc/profile

HADOOP_HOME为刚才复制的路径

source /etc/profile

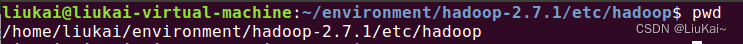

- 修改配置文件

配置文件的路径

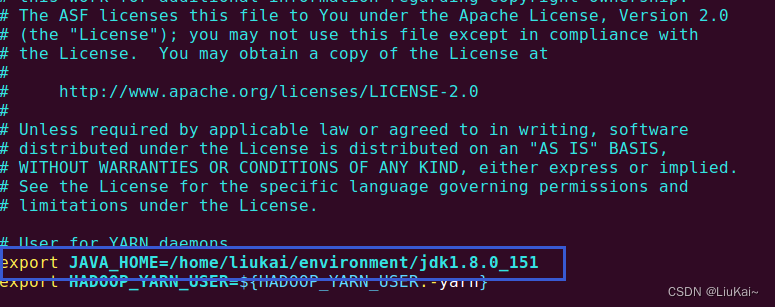

hadoop-env.sh添加jdk路径

yarn-env.sh添加jdk路径

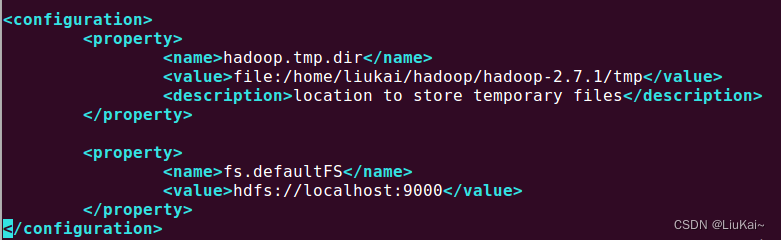

core-site.xml修改如下

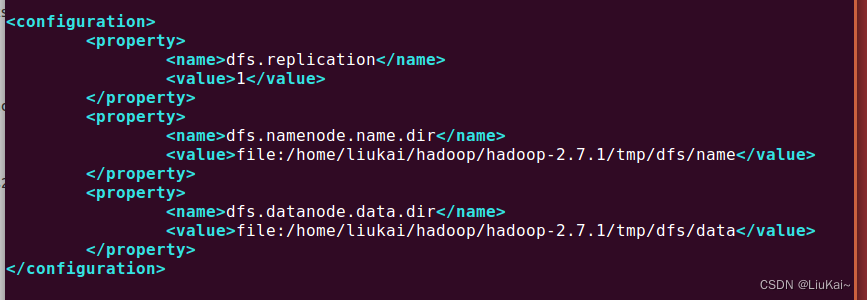

hdfs-site.xml修改如下

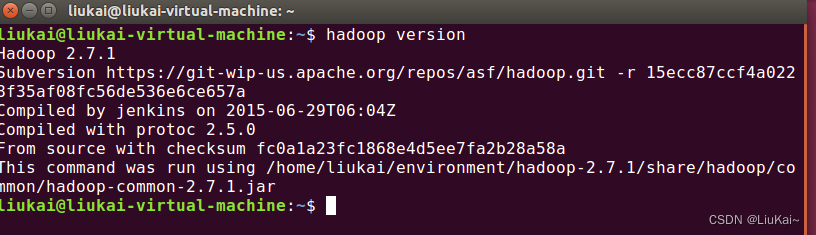

hadoop version出现下图成功

启动hadoop

配置ssh免登陆

ssh 你虚拟机的ip

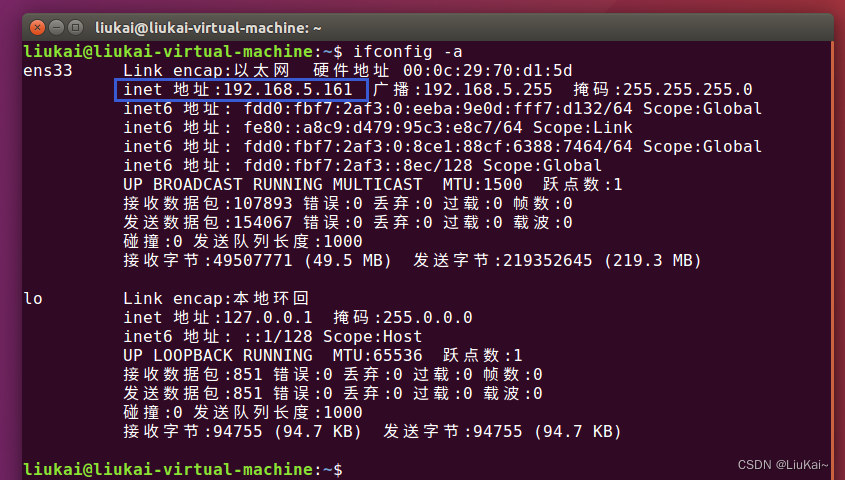

打开终端输入ifconfig -a查看

ssh-keygen -t rsa

cd .ssh

cat id_rsa.pub >> authorized_keys

启动hadoop

hadoop namenode -format

start-all.sh

浏览器查看

localhost:50070

localhost:8088

新建input文件夹

hdfs dfs -mkdir input

本地文件上传

hadoop fs -put xxxx input

至此,hadoop配置完成

安装eclipse

下载工具包中的eclipse-inst-linux64.tar.gz

解压

tar -zxvf eclipse-inst-linux64.tar.gz

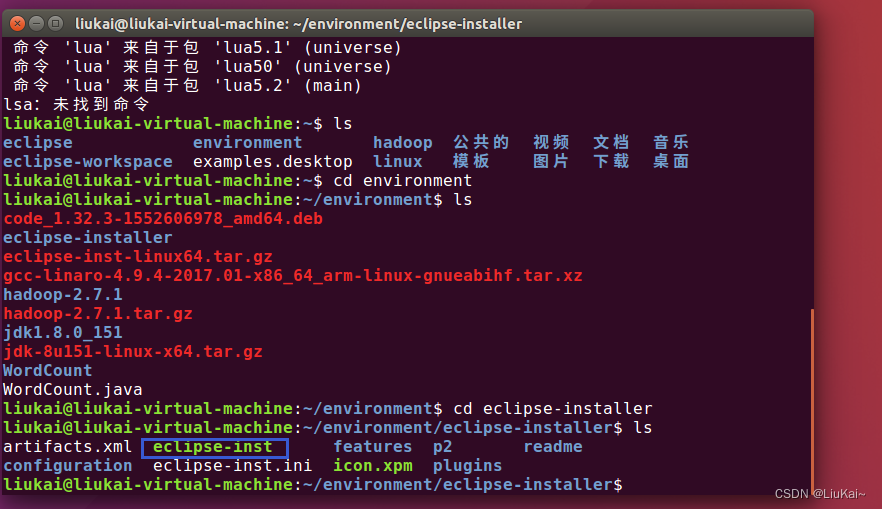

进入解压出的该目录

运行安装程序

./eclipse-inst

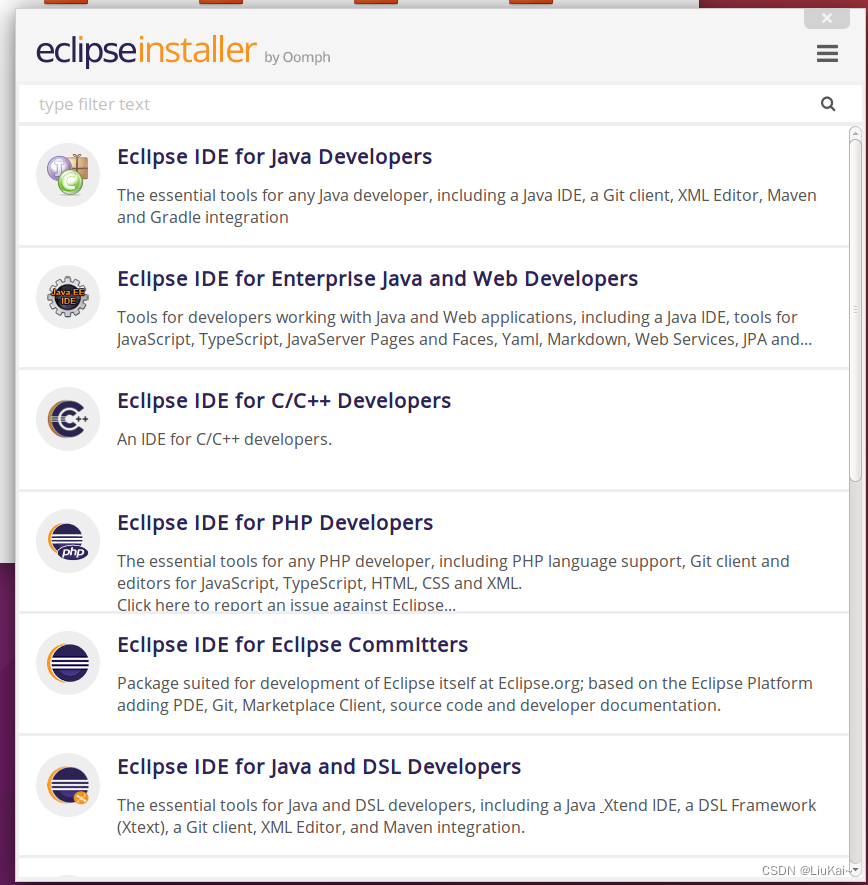

安装第一个(一定开热点,要不会失败)

选择安装目录,并记下

等待安装完成

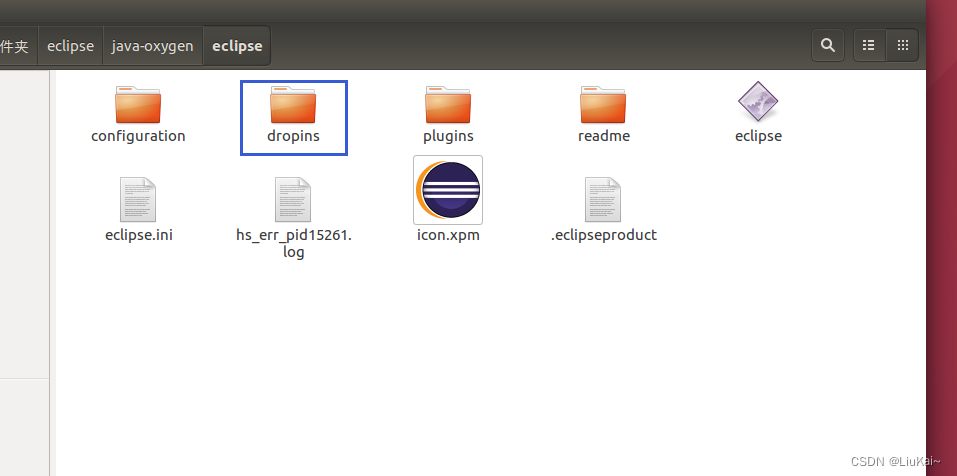

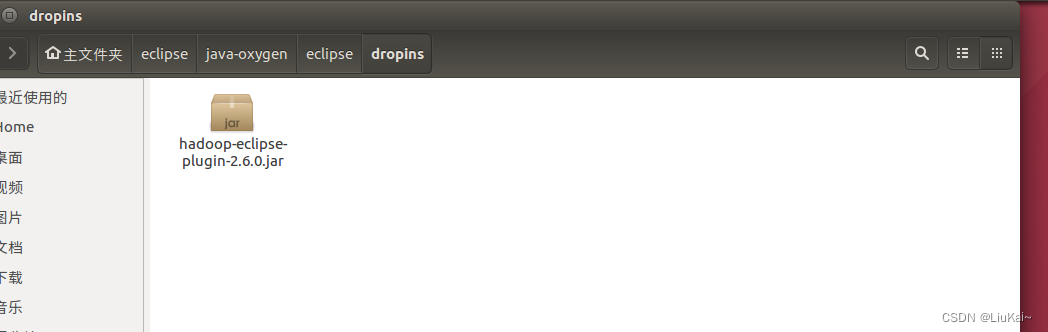

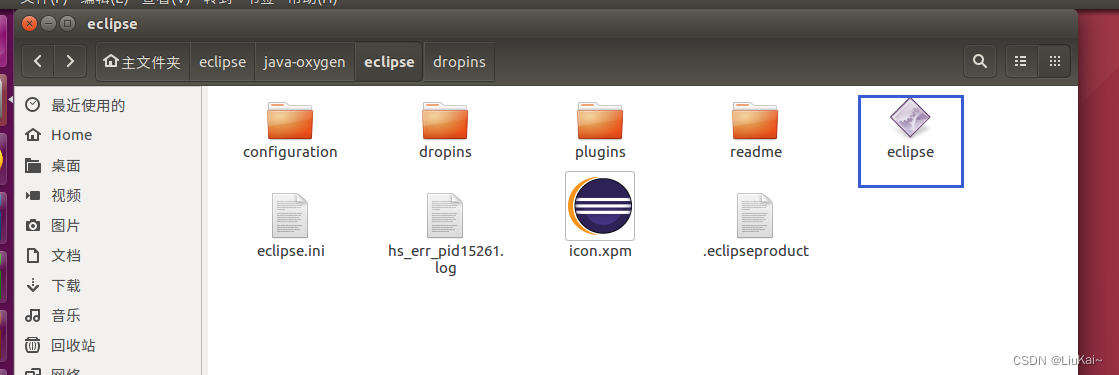

放入hadoop插件

打开刚才的安装目录,找到dropins文件夹,将下载的hadoop-eclipse-plugin-2.6.0.jar放入

启动eclipse

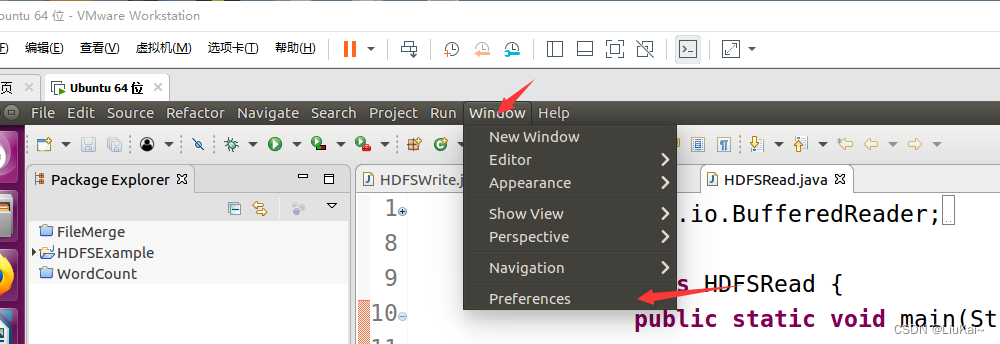

MapReduce

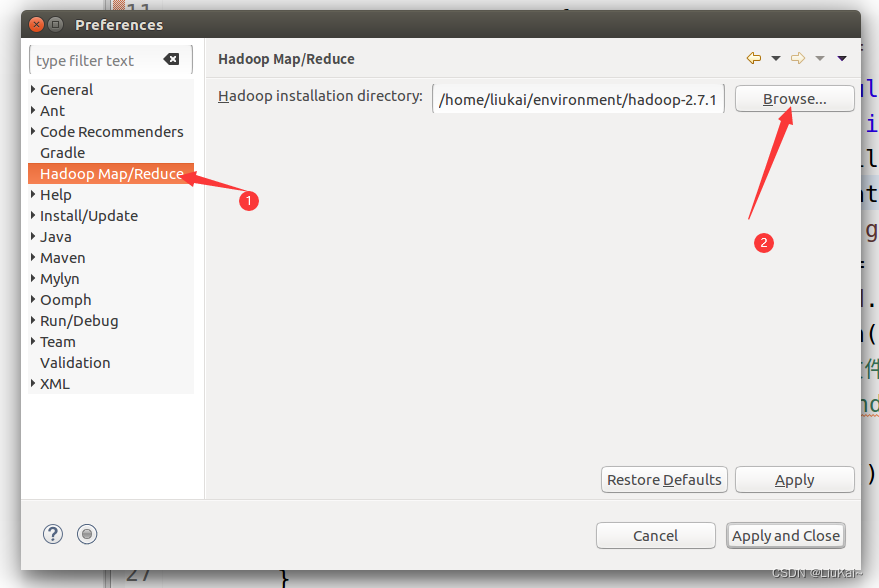

链接hadoop

点击Browse选择hadoop的安装路径

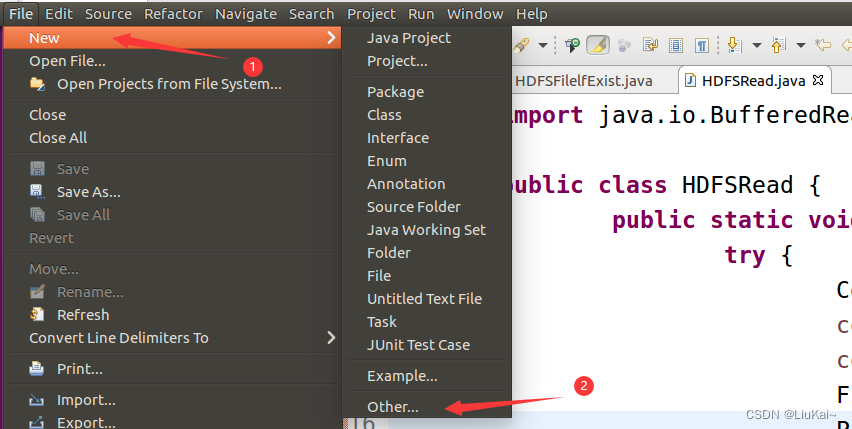

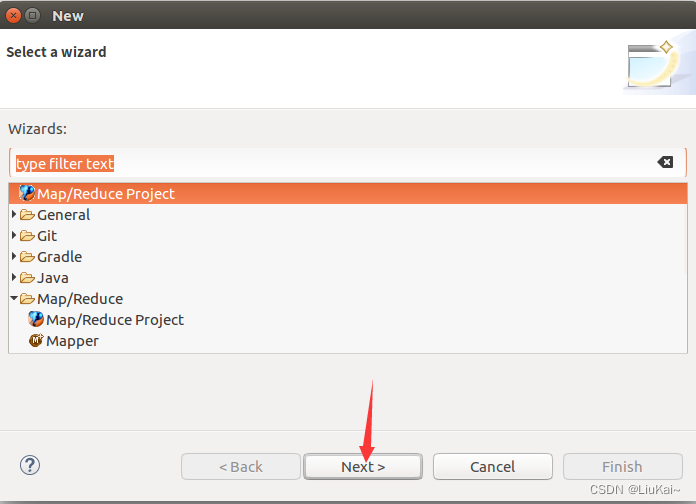

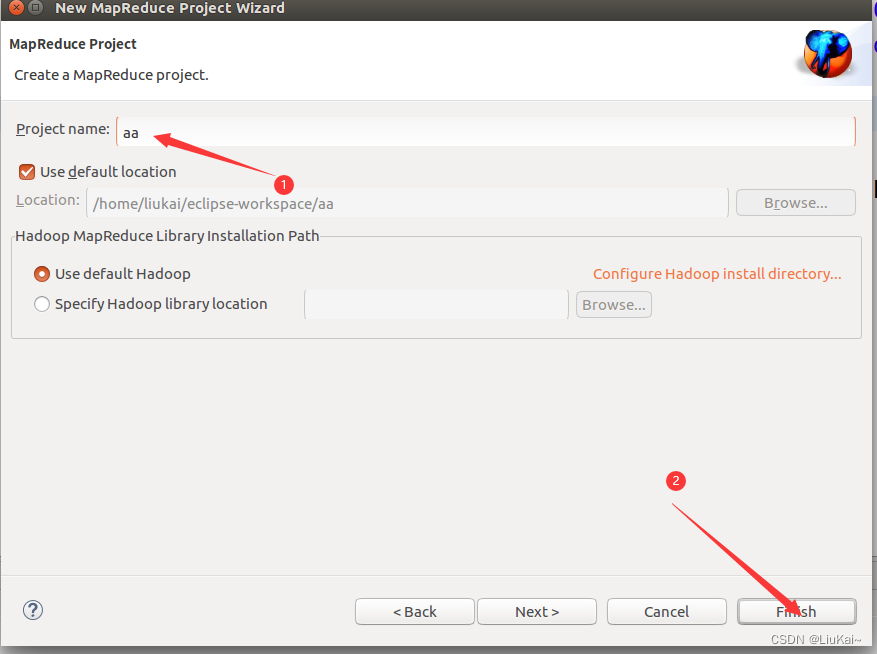

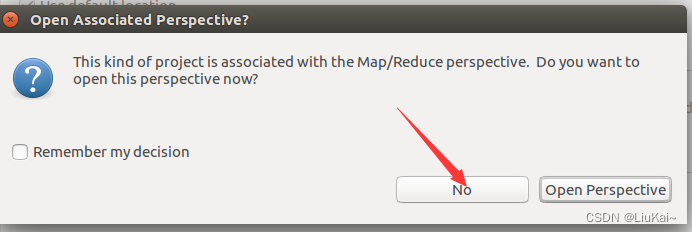

新建MapReduce工程(可跳过直接导入)

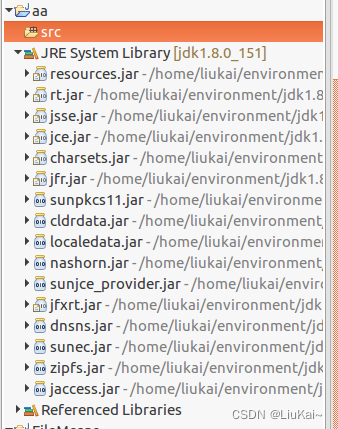

工程目录如下

工程目录如下

导入MapReduce工程

自己百度怎么导入工程

工程链接

链接:https://pan.baidu.com/s/13nfhp8lzHOg38FXI2y1y8g

提取码:euyf

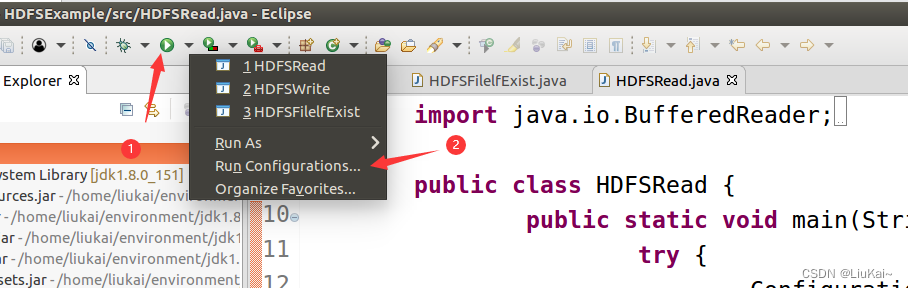

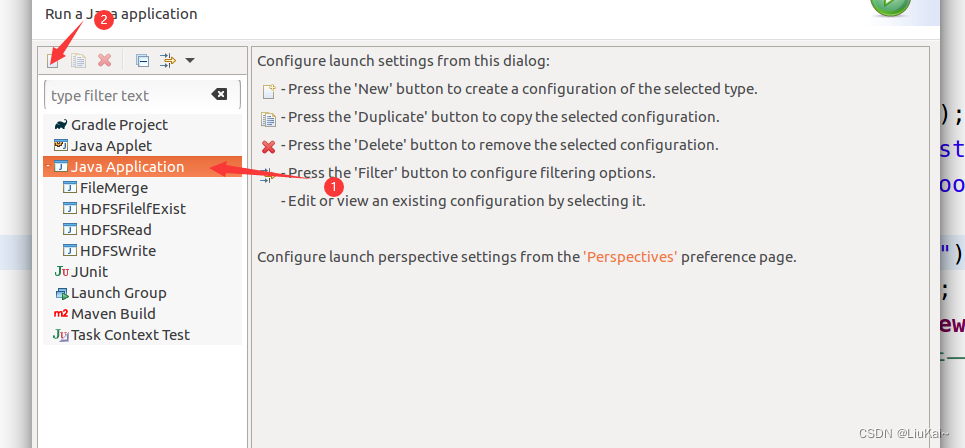

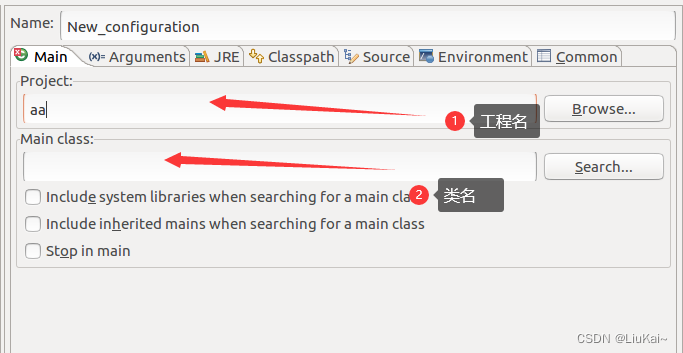

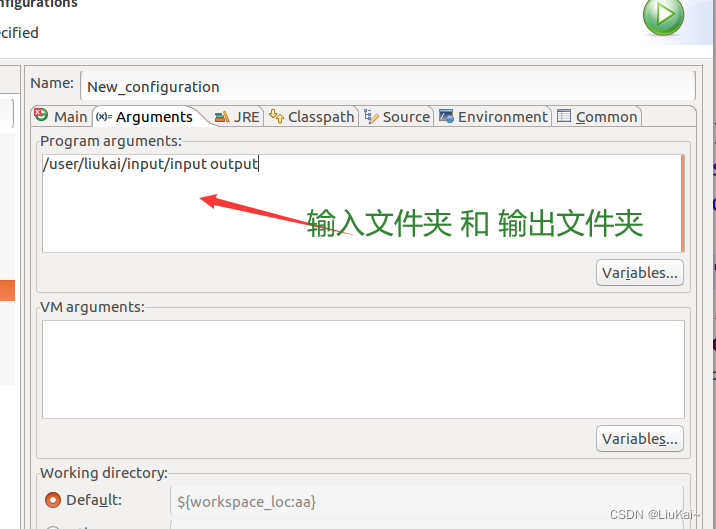

运行环境配置