elasticsearch

elasticsearch是一款非常强大的开源搜索引擎,可以帮助我们从海量数据中快速找到需要的内容。

elasticsearch结合kibana、Logstash、Beats,统称elastic stack(ELK),被广泛应用在日志数据分析、实时监控等领域。

elasticsearch是elastic stack的核心,负责存储、搜索、分析数据,kibana负责数据可视化,Logstash、Beats负责数据抓取。

一、创建docker局域网络

docker network 为容器新增了一张指定网络的虚拟网卡。

创建一个局域网让elasticsearch和kibana进行网络互联,存放在同一个网络,kibana可以直接通过容器访问到es

1. 创建局域网

docker network create es-net

2. 连接局域网

可以在创建容器的时候使用–network进行连接网络,也可以在创建完容器之后进入容器进行连接网络

docker exec -it es bash

docker network connect es-net

二、 安装elasticsearch

1. 拉取es镜像

//拉取elasticsearch的7.12.1版本的镜像

docker pull elasticsearch:7.12.1

可以自己pull,也可以提前下载好镜像上传到服务器使用docker load -i elasticsearch.tar 加载镜像(下载链接放在文章最后)

2. 创建es容器

docker run

--name es \

-e "ES_JAVA_OPTS=-Xms512m -Xmx512m" \

-e "discovery.type=single-node" \

-v es-data:/usr/share/elasticsearch/data \

-v es-plugins:/usr/share/elasticsearch/plugins \

--privileged \

--network es-net \

-p 9200:9200 \

-p 9300:9300 \

-d elasticsearch:7.12.1

3. 参数说明

-e "ES_JAVA_OPTS=-Xms512m -Xmx512m":内存大小

es默认为1g内存,最低不能低于512,否则可能出现内存不足的情况,服务器内存足够的可以往上条-e "discovery.type=single-node":非集群模式-v es-data:/usr/share/elasticsearch/data:挂载逻辑卷,绑定es的数据目录-v es-logs:/usr/share/elasticsearch/logs:挂载逻辑卷,绑定es的日志目录-v es-plugins:/usr/share/elasticsearch/plugins:挂载逻辑卷,绑定es的插件目录--privileged:授予逻辑卷访问权--network es-net:加入一个名为es-net的网络中-p 9200:9200:端口映射配置

elasticsearch 走HTTP 协议的 RESTful 接口使用 9200 端口; 9300 是 TCP 通讯端口,集群间和 TCP Client走9300-e "cluster.name=es-docker-cluster":设置集群名称-e "http.host=0.0.0.0":监听的地址,可以外网访问

三、安装kibana

1. 拉取kibana镜像

kibana版本号要和elasticsearch保持一致,也可以加载kibana存在虚拟机的镜像包,下载链接在文章最后

docker pull kibana:7.12.1

2. 创建kibana容器

docker run -d \

--name kibana \

-e ELASTICSEARCH_HOSTS=http://es:9200 \

--network=es-net \

-p 5601:5601 \

kibana:7.12.1

3. 参数说明

--network es-net:与elasticsearch在同一个网络中-e ELASTICSEARCH_HOSTS=http://es:9200":elasticsearch的地址,kibana与elasticsearch在一个网络,因此可以用容器名直接访问elasticsearch-p 5601:5601:端口映射配置

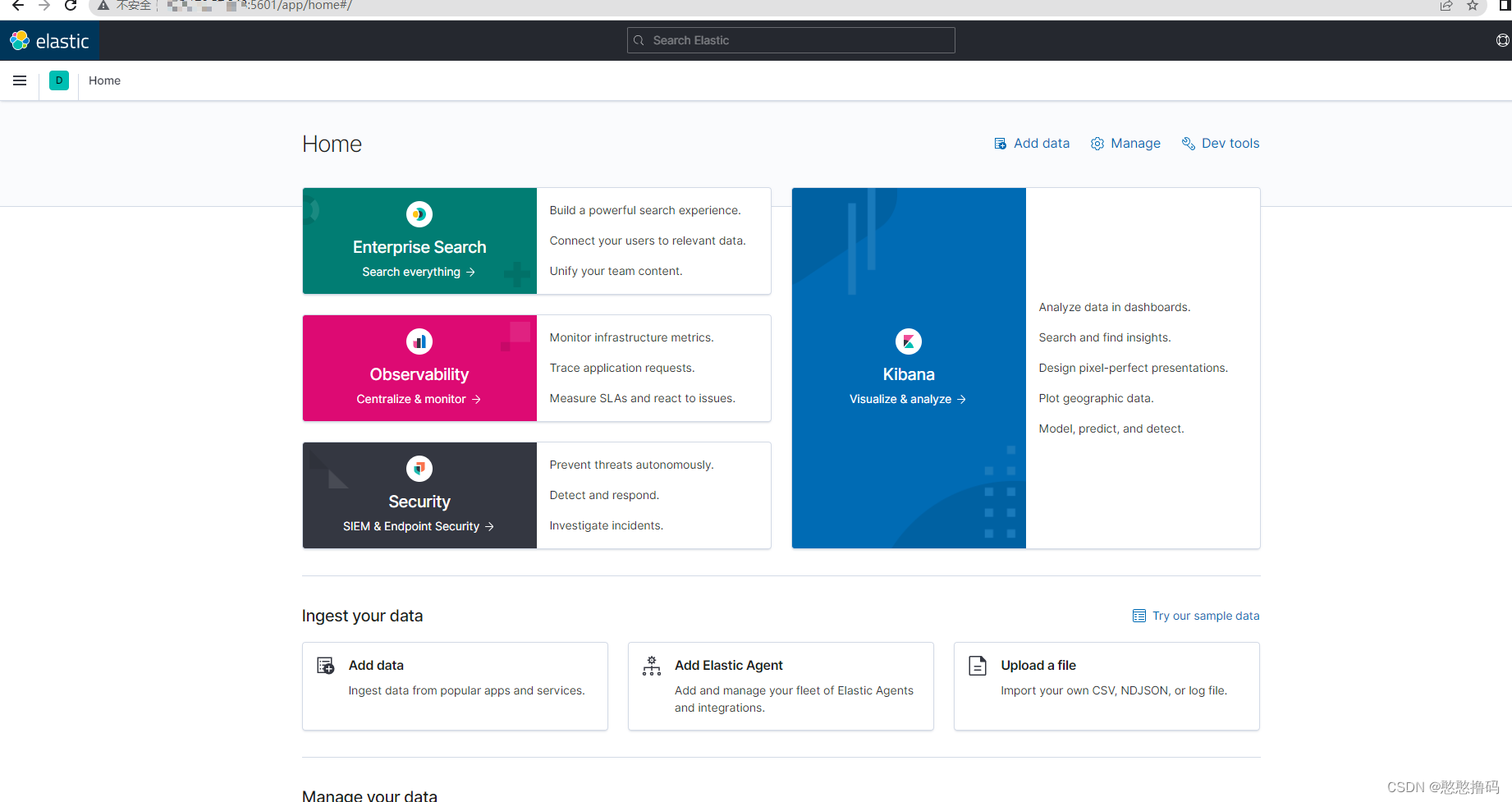

4.访问kibana

通过IP加5601端口访问kibana

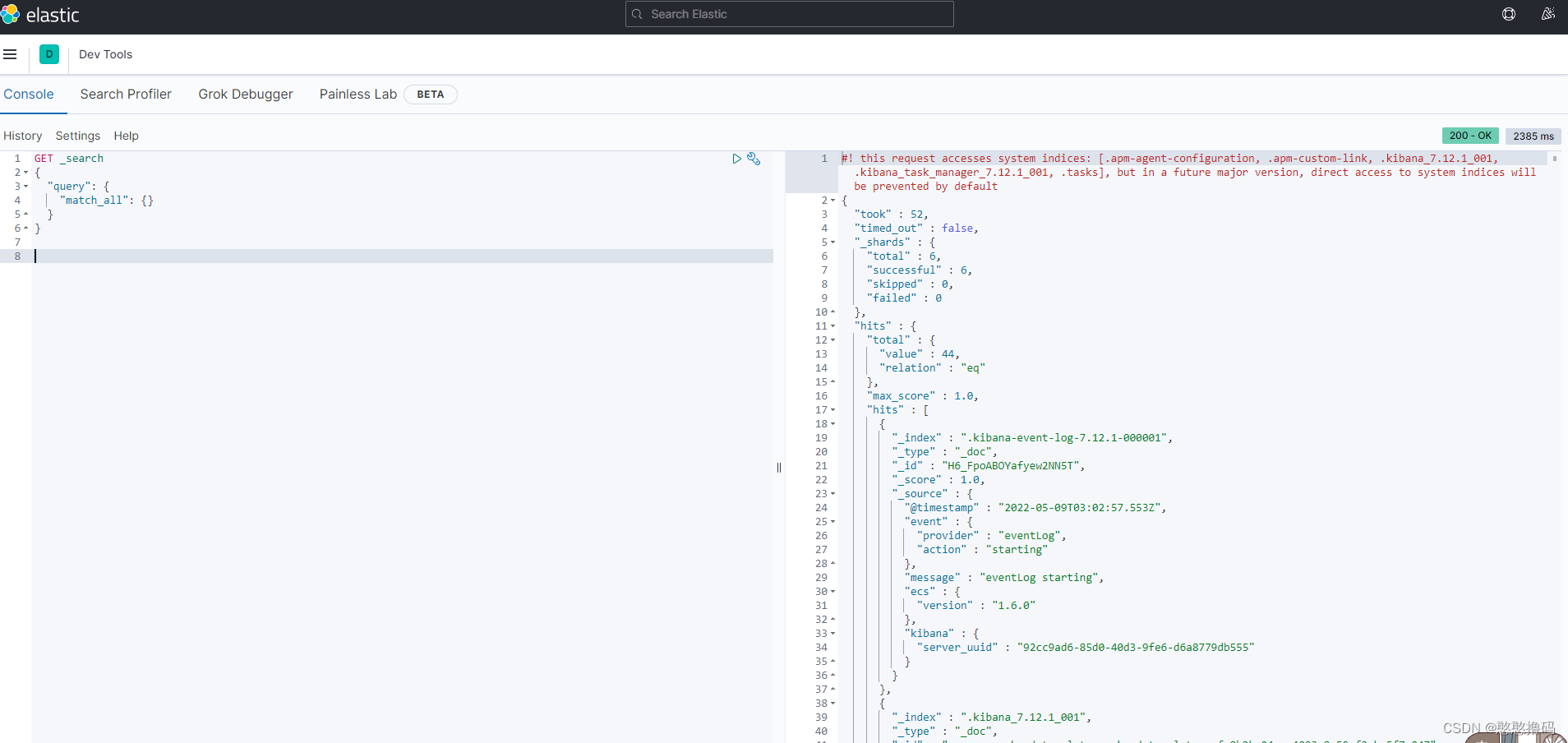

5. 测试使用DSL语句向es发送查询请求

在左侧栏下拉框有一个 Dev Tools,可以向es发送查询请求,左侧语句为DSL语句

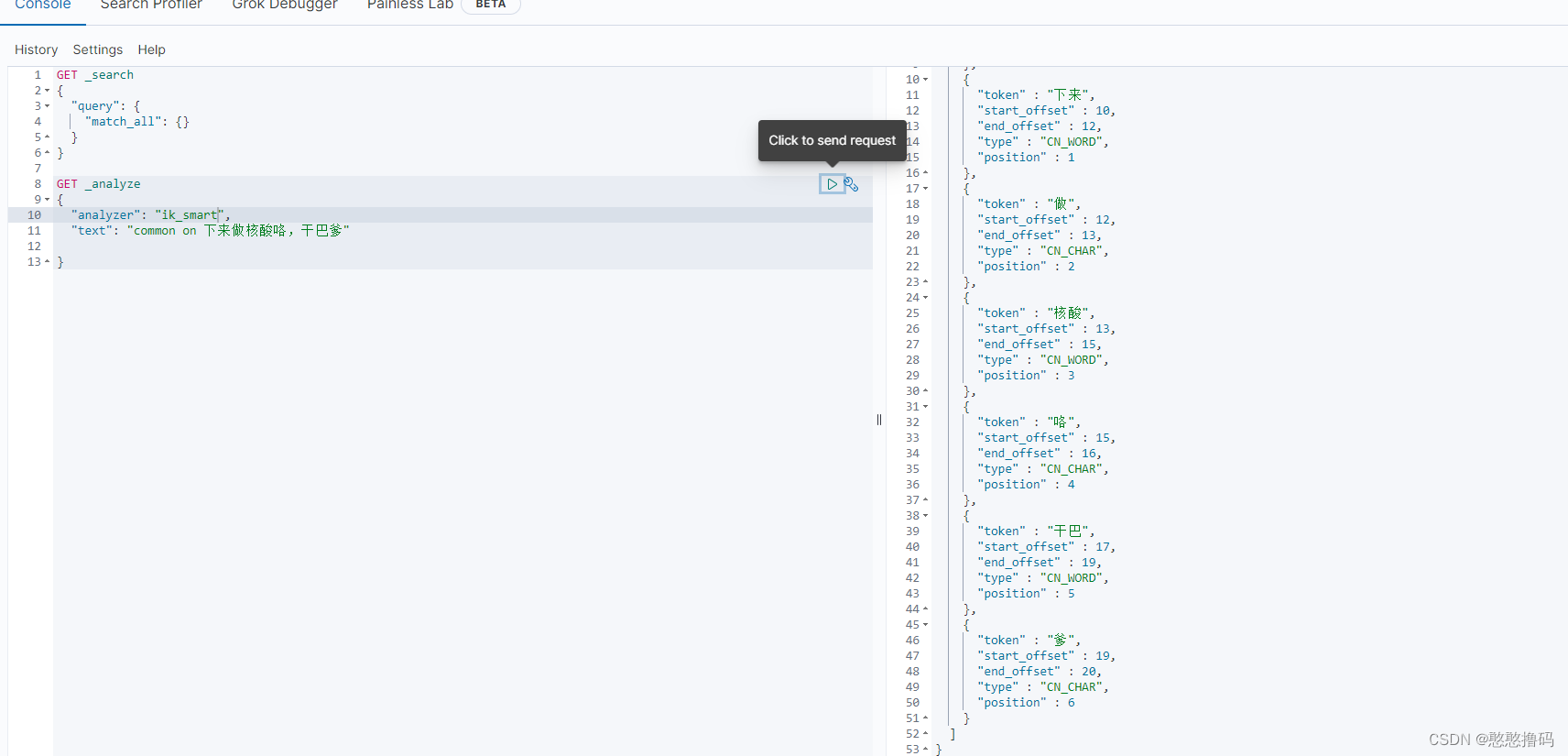

6. 用户搜索时,对输入的内容进行分词

可以通过分词的结果知道使用es默认的分词器对中文语义分词不生效

四、分词器

1. 分词器的作用:

(1) 创建倒排索引时对文档进行分词

(2) 用户搜索时,对输入的内容进行分词

2.IK分词器下载

处理中文分词一般会使用IK分词器,这里有两种方式

(1) 切换到容器内部进行在线下载

docker exec -it es bash

./bin/elasticsearch-plugin install https://github.com/medcl/elasticsearch-analysis-

ik/releases/download/v7.12.1/elasticsearch-analysis-ik-7.12.1.zip

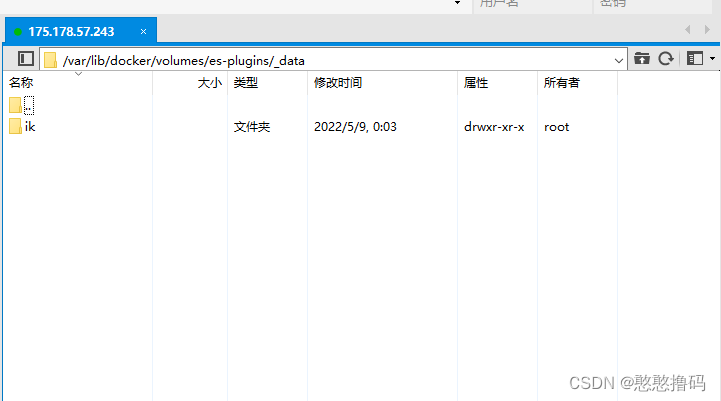

(2)直接将下载好的ik解压到es的plugins目录下(推荐使用这种方式)

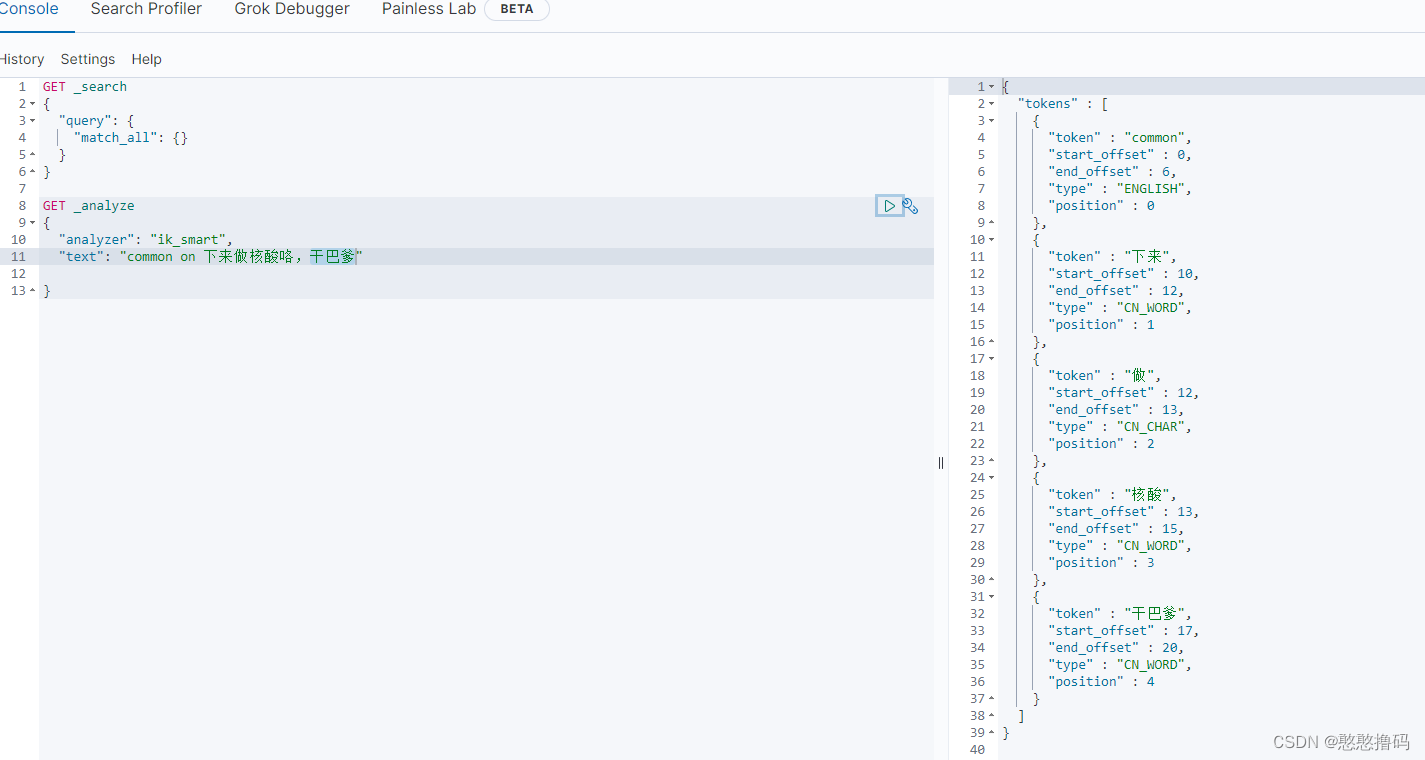

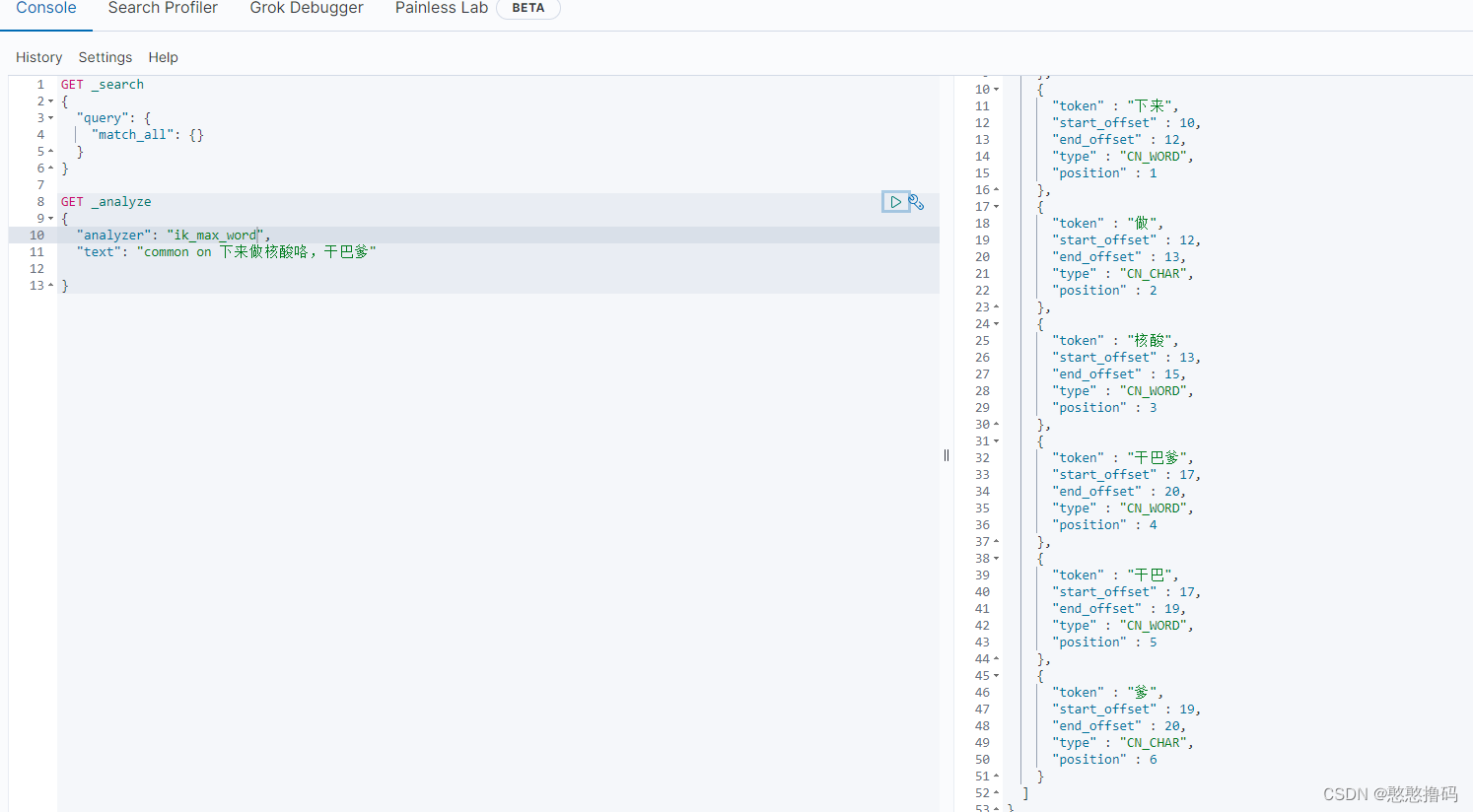

3.IK分词器的模式

ik_smart:最少切分,粗粒度

ik_max_word:最细切分,细粒度

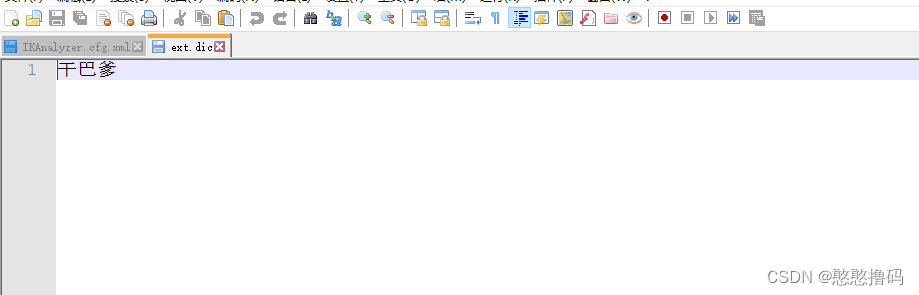

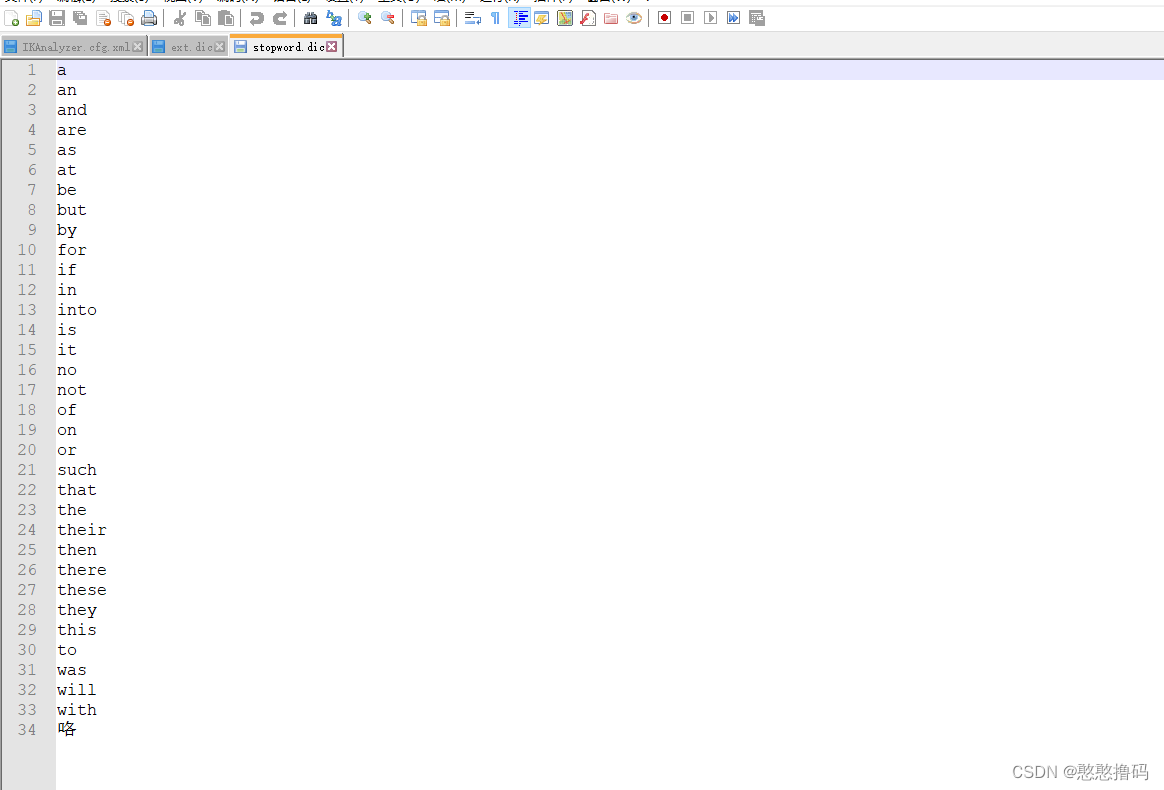

使用IK分词器之后,中文分词有效果,但有些网络用语或者特定的词IK分词器无法识别,这个时候我们可以拓展词库,以及配置一些不允许分词的词语。

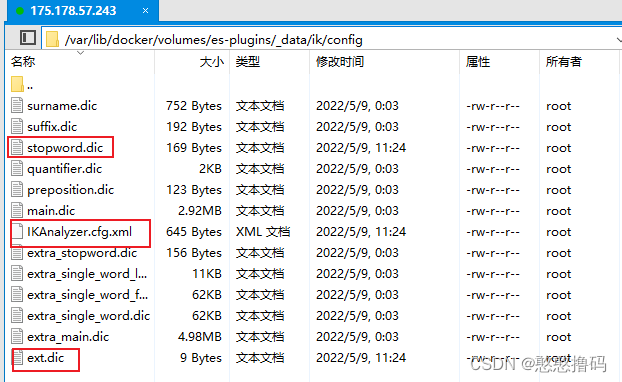

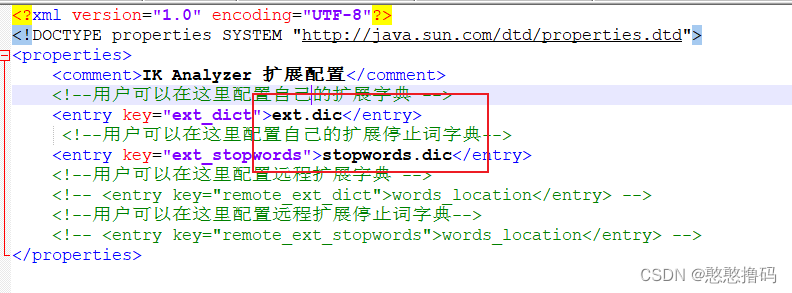

4.配置拓展文档和过滤文档

打开IK分析的配置文档IKAnalyzer.cfg.xml,配置文档,文档位置需要和xml文件在同一个目录

config目录下默认只有stopwords.dic,没有ext.dic,需要自己创建ext.dic;

重启es容器,重新发送请求

资料下载地址:https://download.csdn.net/download/booguojieji/85329645