安装JDK

没有安装的直接去Oracl官网下载相应的JDK版本安装即可。

安装过JDK,可以使用下面命令查看当前安装了哪些JDK版本。

/usr/libexec/java_home -V

下面是笔者机器上安装的JDK版本,已经当前正在使用的版本。

$ /usr/libexec/java_home -V

Matching Java Virtual Machines (2):

11.0.14 (x86_64) "Oracle Corporation" - "Java SE 11.0.14" /Library/Java/JavaVirtualMachines/jdk-11.0.14.jdk/Contents/Home

1.8.0_301 (x86_64) "Oracle Corporation" - "Java SE 8" /Library/Java/JavaVirtualMachines/jdk1.8.0_301.jdk/Contents/Home

/Library/Java/JavaVirtualMachines/jdk-11.0.14.jdk/Contents/Home

ssh免密登录

# 生成没有秘钥的public key,可以使用rsa,也可以使用ed25519

ssh-keygen -t rsa -b 4096 -P '' -f ~/.ssh/id_rsa

ssh-keygen -t ed25519 -P '' -f ~/.ssh/id_ed25519

# 将public key拷贝到authorized_keys

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

# 修改authorized_key的权限

chmod og-wx ~/.ssh/authorized_keys

Bug1:ssh: connect to host localhost port 22: Connection refused

Solution:选择系统偏好设置->共享->点击远程登录然后再输入命令ssh localhost发现已经解决问题

安装配置Hadoop

可以使用brew install hadoop,也可以直接下载hadoop并解压到指定目录。

brew安装的目录为:/usr/local/Cellar/hadoop/。

修改hadoop-env.sh

进入Hadoop的安装目录下的配置目录etc/hadoop,修改hadoop-env.sh的内容。

export HADOOP_OPTS="$HADOOP_OPTS -Djava.net.preferIPv4Stack=true -Djava.security.krb5.realm= -Djava.security.krb5.kdc="

export JAVA_HOME=/Library/Java/JavaVirtualMachines/jdk-11.0.14.jdk/Contents/Home

export HADOOP_CONF_DIR=$HOME/hadoop_spark/hadoop-3.2.0/etc/hadoop

配置hdfs地址和端口

修改core-site.xml文件,如下:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>$HOME/hadoop_spark/hadoop-3.2.0/hdfs/tmp</value>

<description>A base for other temporary directories.</description>

</property>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:8020</value>

</property>

</configuration>

配置MapReduce中jobtracker的地址和端口

找到mapred-site.xml.template文件,将文件重命名为mapred-site.xml,并修改内容。

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>localhost:8021</value>

</property>

</configuration>

修改hdfs备份数

相同目录下,打开hdfs-site.xml文件,修改内容。

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

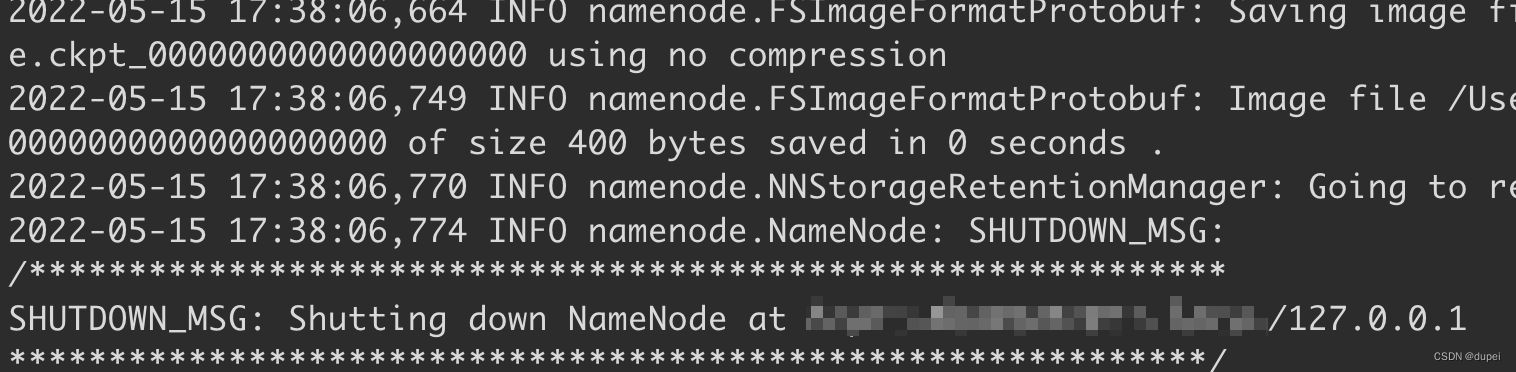

格式化HDFS

初始化文件系统,打开终端输入:hdfs namenode -format

如果出现下面的情况代表成功.

配置Hadoop环境变量

在.bashrc中添加下面的配置

export HADOOP_HOME=$HOME/hadoop_spark/hadoop-3.2.0

export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

启动关闭Hadoop服务

# 启动HDSF服务

./start-dfs.sh

# 关闭HDSF服务

./stop-dfs.sh

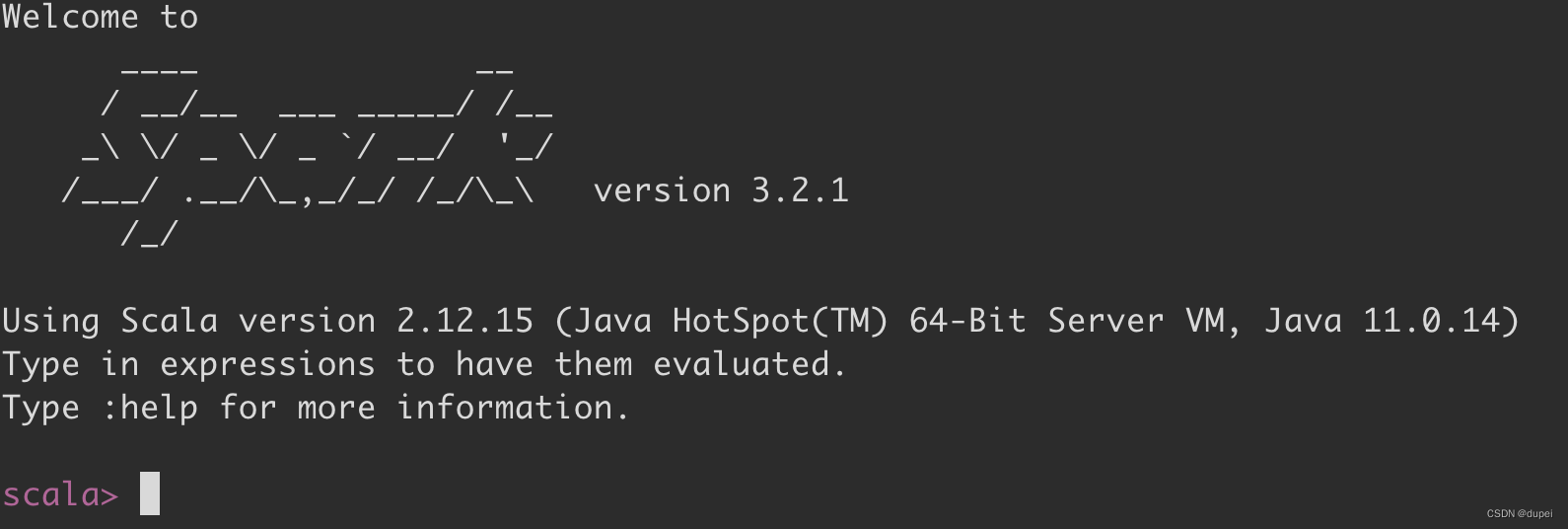

安装Scala

可以直接使用brew install scala安装,并修改环境变量。

export SCALA_HOME=/usr/local/Cellar/scala/2.13.8

export PATH=$PATH:$SCALA_HOME/bin

安装Spark

直接从官网下载相应版本,解压到本地目录,并配置系统变量。下面是完整的配置:

export HADOOP_HOME=$HOME/hadoop_spark/hadoop-3.2.0

export SPARK_HOME=$HOME/hadoop_spark/spark-3.2.1-bin-hadoop3.2

export SCALA_HOME=/usr/local/Cellar/scala/2.13.8

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$SCALA_HOME/bin:$SPARK_HOME/bin:$SPARK_HOME/sbin:$PATH

使用Spark

在终端,使用spark-shell启动:

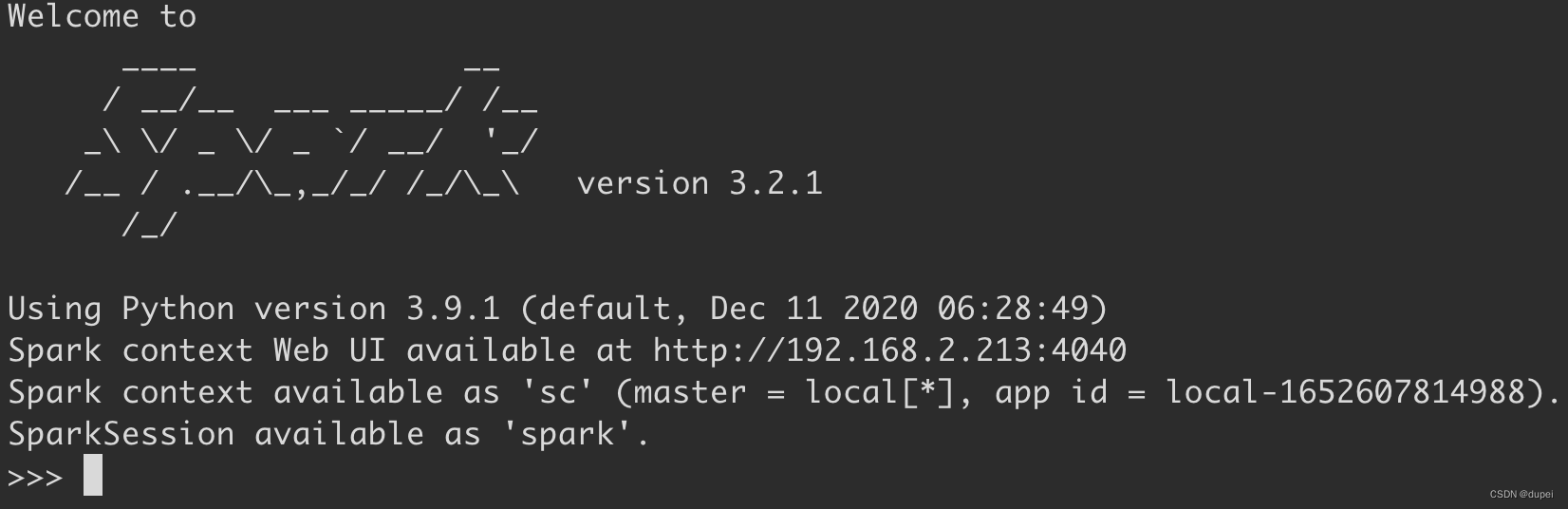

使用pyspark启动:

使用浏览器访问:http://localhost:4040/