一、简介

????????HBase是一种分布式、可扩展、支持海量数据存储的 NoSQL 数据库。

1、数据模型

逻辑上,HBase 的数据模型同关系型数据库很类似,数据存储在一张表中,有行有列。 但从 HBase 的底层物理存储结构(K-V)来看,HBase 更像是一个 multi-dimensional map。

逻辑结构

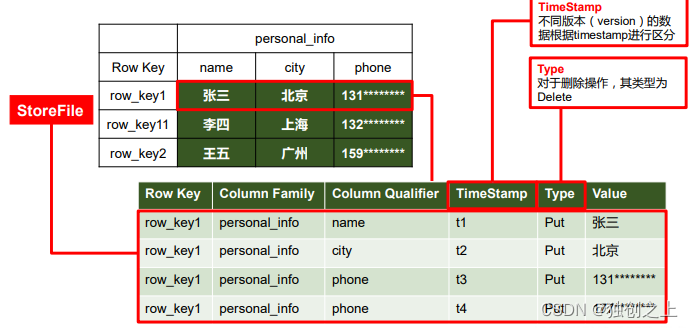

物理存储结构

数据模型

1)NameSpace:命名空间,类似于关系型数据库的 DatabBase 概念,每个命名空间下有多个表。HBase 有两个自带的命名空间,分别是 hbase 和 default,hbase 中存放的是 HBase 内置的表, default 表是用户默认使用的命名空间。

2)Region:类似于关系型数据库的表概念。不同的是,HBase 定义表时只需要声明列族即可,不需 要声明具体的列。这意味着,往 HBase 写入数据时,字段可以动态、按需指定。因此,和关 系型数据库相比,HBase 能够轻松应对字段变更的场景。

3)Row:HBase 表中的每行数据都由一个 RowKey 和多个 Column(列)组成,数据是按照 RowKey 的字典顺序存储的,并且查询数据时只能根据 RowKey 进行检索,所以 RowKey 的设计十分重 要。

4)Column:HBase 中的每个列都由 Column Family(列族)和 Column Qualifier(列限定符)进行限 定,例如 info:name,info:age。建表时,只需指明列族,而列限定符无需预先定义。

5)Time Stamp:用于标识数据的不同版本(version),每条数据写入时,如果不指定时间戳,系统会 自动为其加上该字段,其值为写入 HBase 的时间。

6)Cell:由{rowkey, column Family:column Qualifier, time Stamp} 唯一确定的单元。cell 中的数 据是没有类型的,全部是字节码形式存贮。

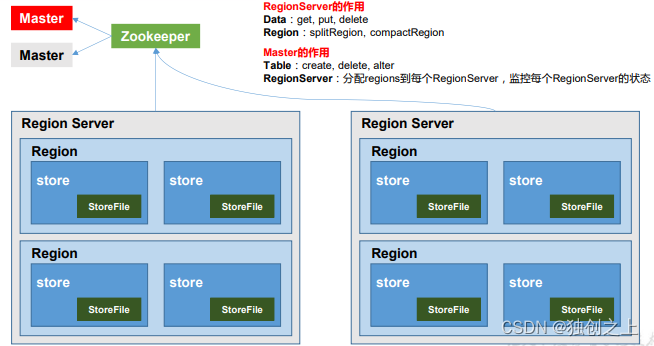

3、HBase基本架构

?1)Region Server:Region Server 为 Region 的管理者,其实现类为 HRegionServer,

主要作用如下: 对于数据的操作:get, put, delete;

????????????????????????对于 Region 的操作:splitRegion、compactRegion。

2)Master:Master 是所有 Region Server 的管理者,其实现类为 HMaster,

主要作用如下: 对于表的操作:create, delete, alter

????????????????????????? 对于 RegionServer的操作:分配 regions到每个RegionServer,监控每个 RegionServer 的状态,负载均衡和故障转移。

3)Zookeeper:HBase 通过 Zookeeper 来做 Master 的高可用、RegionServer 的监控、元数据的入口以及 集群配置的维护等工作。

4)HDFS:HDFS 为 HBase 提供最终的底层数据存储服务,同时为 HBase 提供高可用的支持。

二、安装部署

1、zookeeper部署

??????? 在启动安装HBase之前,要启动zookeeper来对HBase的Master进行管理。

zk.sh start? :之前写的脚本,启动zookeeper

同时要启动hadoop集群

2、HBase部署

1)解压HBase:

tar -zxvf hbase-2.4.11-bin.tar.gz -C /opt/module

?2)HBase配置文件:修改hbase-env.sh

export JAVA_HOME=/opt/module/jdk1.6.0_144

export HBASE_MANAGES_ZK=false

???????? 修改hbase-site.xml文件

<configuration>

<property>

<name>hbase.rootdir</name>

<value>hdfs://hadoop102:9000/HBase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<!-- 0.98 后的新变动,之前版本没有.port,默认端口为 60000 -->

<property>

<name>hbase.master.port</name>

<value>16000</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>hadoop102,hadoop103,hadoop104</value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/opt/module/zookeeper-3.4.10/zkData</value>

</property>

</configuration>

???????? 修改regionservers

hadoop102

hadoop103

hadoop104

?????????软连接 hadoop 配置文件到 HBase

ln -s /opt/module/hadoop-3.1.3/etc/hadoop/core-site.xml /opt/module/hbase/conf/coresite.xml

ln -s /opt/module/hadoop-3.1.3/etc/hadoop/hdfs-site.xml /opt/module/hbase/conf/hdfssite.xml

3、分发到其他集群

xsync hbase/

4、HBase启动和停止

bin/start-hbase.sh

bin/stop-hbase.sh

5、查看HBase页面

启动成功后,可以通过“host:port”的方式来访问 HBase 管理页面(可以查看具体的数据信息),例如:

http://hadoop102:16010

三、HBase shell操作

1、基本操作

1)进入命令行:bin/hbase shell

2)查看当前数据库的表:list

2、表的操作

1)创建表:create 'student','info'

2)插入数据:put 'student','1001','info:sex','male'

3)扫描查看表数据:scan ‘student’

4)查看表结构:describe ‘student’

5)更新指定字段的数据:put 'student','1001','info:name','Nick'

6)查看指定行或指定列族:列数据:get 'student','1001'

7)统计表数据行数:count 'student'

8)删除数据:deleteall 'student','1001'

????????????????????????delete 'student','1002','info:sex'

9)清空表数据:truncate 'student'

10)删除表:首先设为disable状态:disable 'student'

??????????????????????? 在删除:drop 'student'

11)变更表信息:alter 'student',{NAME=>'info',VERSIONS=>3}

四 HBase架构原理

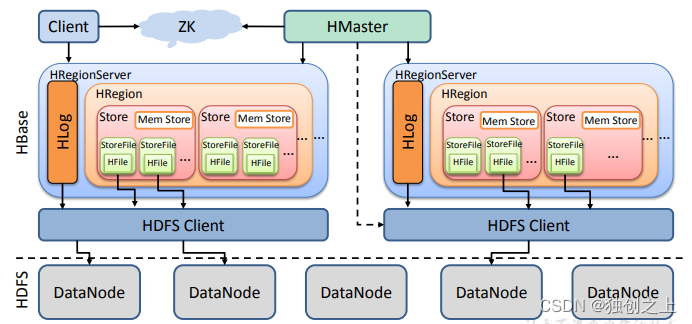

1、架构原理

?1)StoreFile:保存实际数据的物理文件,StoreFile 以 HFile 的形式存储在 HDFS 上。每个 Store 会有 一个或多个 StoreFile(HFile),数据在每个 StoreFile 中都是有序的。

2)MemStore:写缓存,由于 HFile 中的数据要求是有序的,所以数据是先存储在 MemStore 中,排好序后,等到达刷写时机才会刷写到 HFile,每次刷写都会形成一个新的 HFile。

3)WAL(HLog):由于数据要经 MemStore 排序后才能刷写到 HFile,但把数据保存在内存中会有很高的 概率导致数据丢失,为了解决这个问题,数据会先写在一个叫做 Write-Ahead logfile 的文件 中,然后再写入 MemStore 中。所以在系统出现故障的时候,数据可以通过这个日志文件重 建。

2、写流程

1)Client 先访问 zookeeper,获取 hbase:meta 表位于哪个 Region Server。

2)访问对应的 Region Server,获取 hbase:meta 表,根据读请求的 namespace:table/rowkey, 查询出目标数据位于哪个 Region Server 中的哪个 Region 中。并将该 table 的 region 信息以 及 meta 表的位置信息缓存在客户端的 meta cache,方便下次访问。

3)与目标 Region Server 进行通讯;

4)将数据顺序写入(追加)到 WAL;

5)将数据写入对应的 MemStore,数据会在 MemStore 进行排序;

6)向客户端发送 ack;

7)等达到 MemStore 的刷写时机后,将数据刷写到 HFile。

3、MemStore Flush

?MemStore 刷写时机:

1)当某个 memstroe 的大小达到了 hbase.hregion.memstore.flush.size(默认值 128M), 其所在 region 的所有 memstore 都会刷写。 当 memstore 的大小达到了 hbase.hregion.memstore.flush.size(默认值 128M) * hbase.hregion.memstore.block.multiplier(默认值 4) 时,会阻止继续往该 memstore 写数据。

2)当 region server 中 memstore 的总大小达到 java_heapsize ????????????????????????*hbase.regionserver.global.memstore.size(默认值 0.4) ????????????????*hbase.regionserver.global.memstore.size.lower.limit(默认值 0.95), region 会按照其所有 memstore 的大小顺序(由大到小)依次进行刷写。直到 region server 中所有 memstore 的总大小减小到上述值以下。

????????当 region server 中 memstore 的总大小达到 ????????????????java_heapsize*hbase.regionserver.global.memstore.size(默认值 0.4) 时,会阻止继续往所有的 memstore 写数据。

3) 到达自动刷写的时间,也会触发 memstore flush。自动刷新的时间间隔由该属性进行 配置 hbase.regionserver.optionalcacheflushinterval(默认 1 小时)。

4)当 WAL 文件的数量超过 hbase.regionserver.max.logs,region 会按照时间顺序依次进 行刷写,直到 WAL 文件数量减小到 hbase.regionserver.max.log 以下(该属性名已经废弃, 现无需手动设置,最大值为 32)。

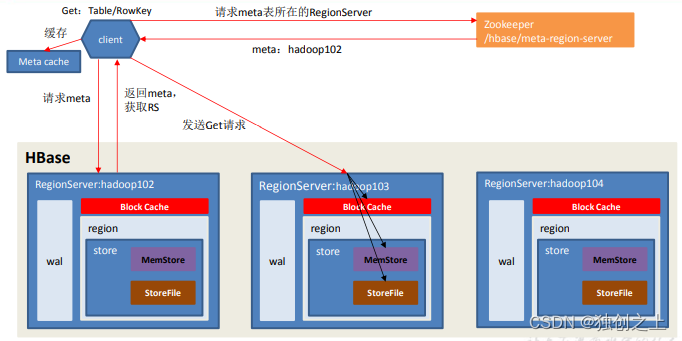

4、读流程

?1)Client 先访问 zookeeper,获取 hbase:meta 表位于哪个 Region Server。

2)访问对应的 Region Server,获取 hbase:meta 表,根据读请求的 namespace:table/rowkey, 查询出目标数据位于哪个 Region Server 中的哪个 Region 中。并将该 table 的 region 信息以 及 meta 表的位置信息缓存在客户端的 meta cache,方便下次访问。

3)与目标 Region Server 进行通讯;

4)分别在 Block Cache(读缓存),MemStore 和 Store File(HFile)中查询目标数据,并将 查到的所有数据进行合并。此处所有数据是指同一条数据的不同版本(time stamp)或者不 同的类型(Put/Delete)。

5) 将从文件中查询到的数据块(Block,HFile 数据存储单元,默认大小为 64KB)缓存到 Block Cache。

6)将合并后的最终结果返回给客户端。

5、StoreFile Compaction(文件合并)

????????由于memstore每次刷写都会生成一个新的HFile,且同一个字段的不同版本(timestamp) 和不同类型(Put/Delete)有可能会分布在不同的 HFile 中,因此查询时需要遍历所有的 HFile。为了减少 HFile 的个数,以及清理掉过期和删除的数据,会进行 StoreFile Compaction。

???????? Compaction 分为两种,分别是 Minor Compaction 和 Major Compaction。Minor Compaction 会将临近的若干个较小的 HFile 合并成一个较大的 HFile,但不会清理过期和删除的数据。 Major Compaction 会将一个 Store 下的所有的 HFile 合并成一个大 HFile,并且会清理掉过期 和删除的数据。

6、 Region Split(合并之后为了避免某个region数据量过大导致的数据倾斜而划分数据)

????????默认情况下,每个 Table 起初只有一个 Region,随着数据的不断写入,Region 会自动进 行拆分。刚拆分时,两个子 Region 都位于当前的 Region Server,但处于负载均衡的考虑, HMaster 有可能会将某个 Region 转移给其他的 Region Server。

???????? Region Split 时机:

????????1)当1个region中的某个Store下所有StoreFile的总大小超过hbase.hregion.max.filesize, 该 Region 就会进行拆分(0.94 版本之前)。

????????2) 当 1 个 region 中 的 某 个 Store 下所有 StoreFile 的 总 大 小 超 过 Min(R^2 * "hbase.hregion.memstore.flush.size",hbase.hregion.max.filesize"),该 Region 就会进行拆分,其 中 R 为当前 Region Server 中属于该 Table 的个数(0.94 版本之后)

?

后续是HBase的API操作和具体项目。。。。。

?