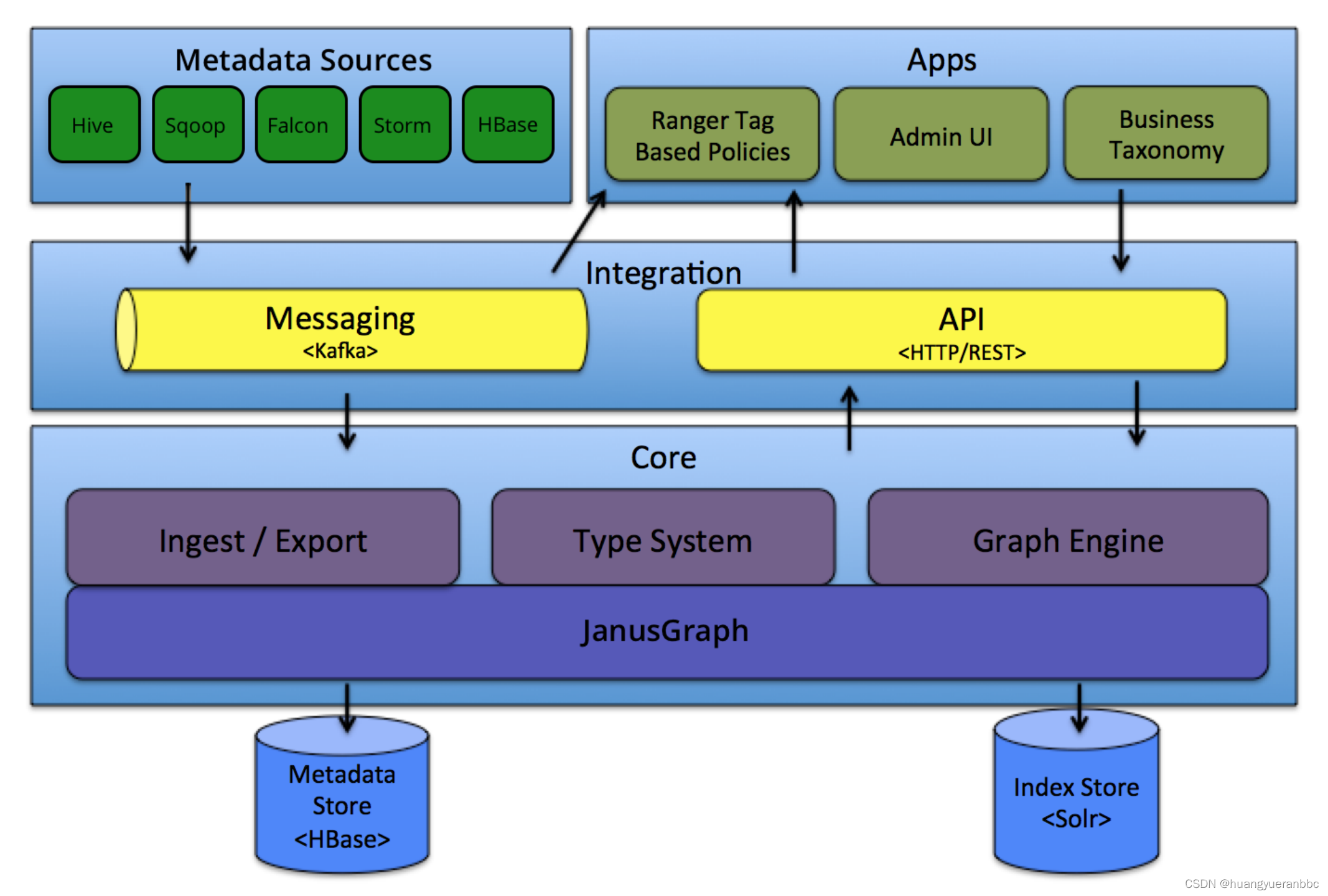

Atlas架构:

Atlas 是一组可扩展和可扩展的核心基础治理服务——使企业能够有效且高效地满足其在 Hadoop 中的合规性要求,并允许与整个企业数据生态系统集成。

Apache Atlas 为组织提供开放的元数据管理和治理功能,以构建其数据资产的目录,对这些资产进行分类和治理,并为数据科学家、分析师和数据治理团队提供围绕这些数据资产的协作能力。

Atlas的核心功能依赖于sorl、hbase、kafka,安装Atlas前需要提前安装相关依赖服务。

安装步骤主要分为以下7步:

1、Hadoop安装

2、Hive安装

3、Zookeeper安装

4、Kafka安装

5、Hbase安装

6、Solr安装

7、Atlas安装

Atlas安装

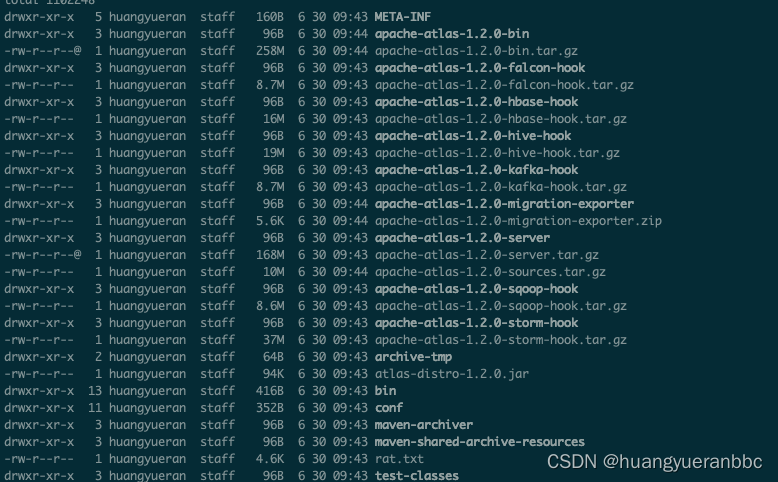

1、下载安装source包

https://atlas.incubator.apache.org/1.2.0/InstallationSteps.html

2、通过mvn clean install和mv clean package命令进行安装和打包

打包成功后,在apache-atlas-sources-1.2.0/distro/target会生成安装包。

安装包目录如下:

2、solr创建索引

./solr create -c vertex_index -d /data/software/atlas-2.1.0/conf/solr -shards 3 -replicationFactor 2 -force #点

./solr create -c edge_index -d /data/software/atlas-2.1.0/conf/solr -shards 3 -replicationFactor 2 -force #线

./solr create -c fulltext_index -d /data/software/atlas-2.1.0/conf/solr -shards 3 -replicationFactor 2 -force #全图

3、开启中间件的atlas hook功能

如要采集hive的元数据,则需进入hive安装目录下的conf目录,在hive-site.xml中增加hook配置来开功能。

<property>

<name>hive.exec.post.hooks</name>

<value>org.apache.atlas.hive.hook.HiveHook</value>

</property>

4、安装Hive Hook

解压apache-atlas-2.1.0-hivehook.tar.gz

将hook解压目录报备至atlas的安装目录

5、执行./bin/atlas-start.py 启动atlas

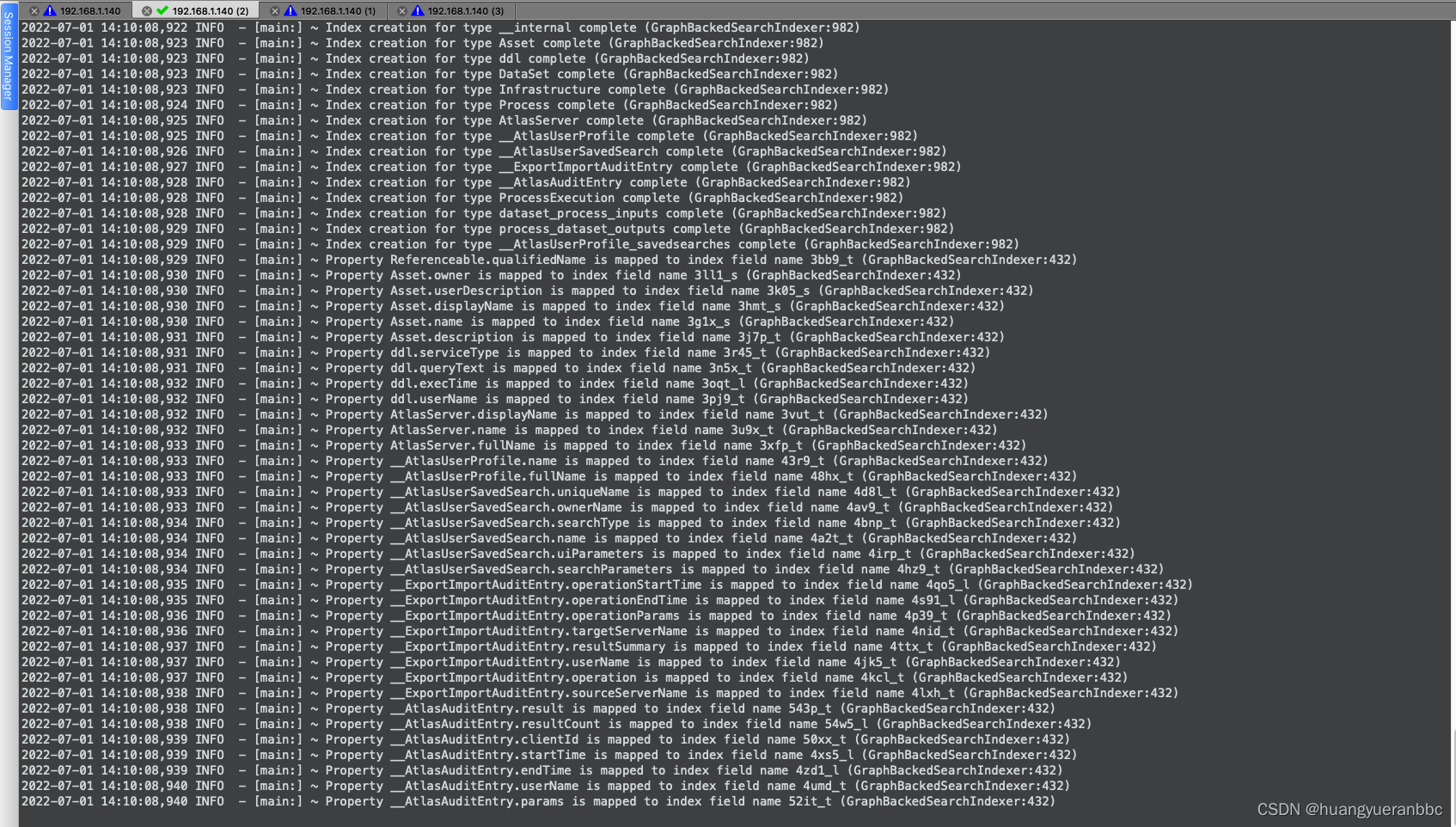

初次启动会创建solr索引和hbase表等文件,时间较久。

6、初始化完成后

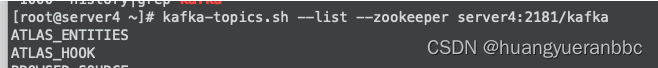

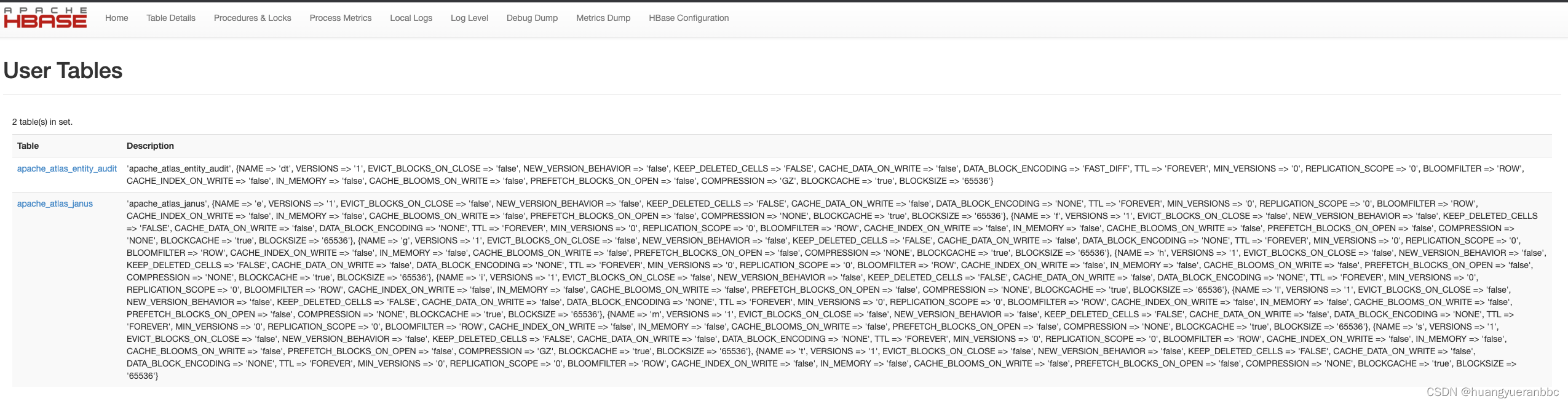

kafka、solr、hbase都会生成相应的atlas数据:

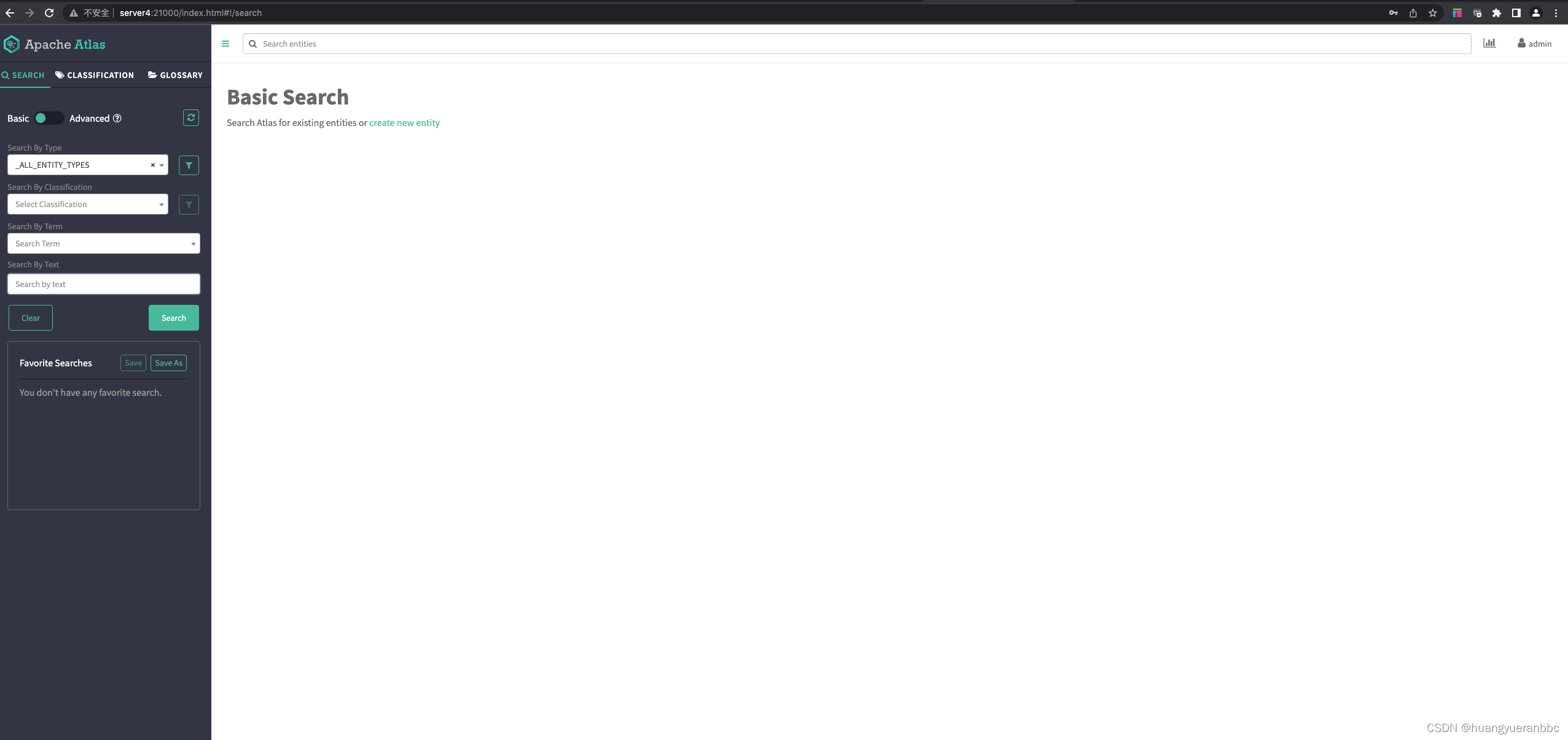

7、启动结束后,输入http://ip:21000,进入apache atlas管理端

默认账号和密码 admin admin

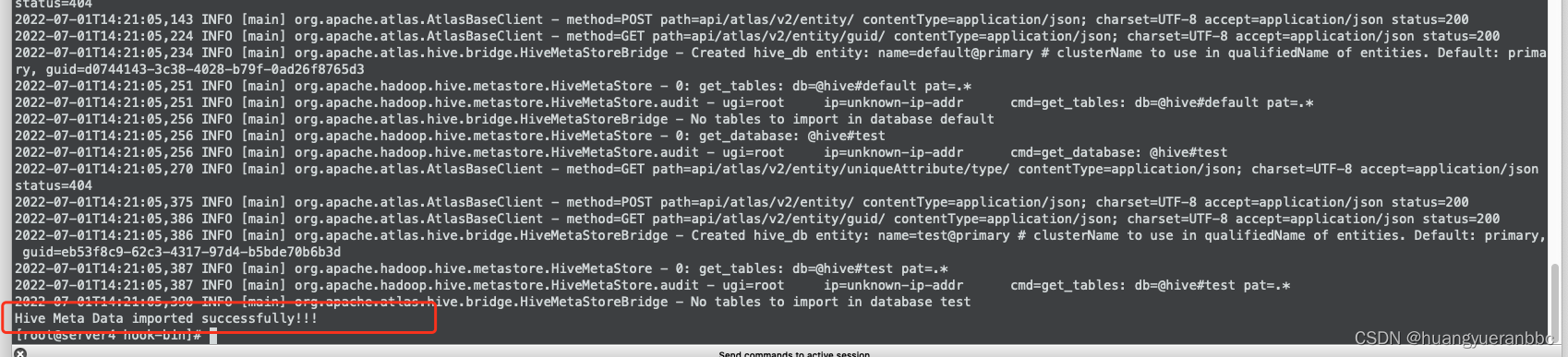

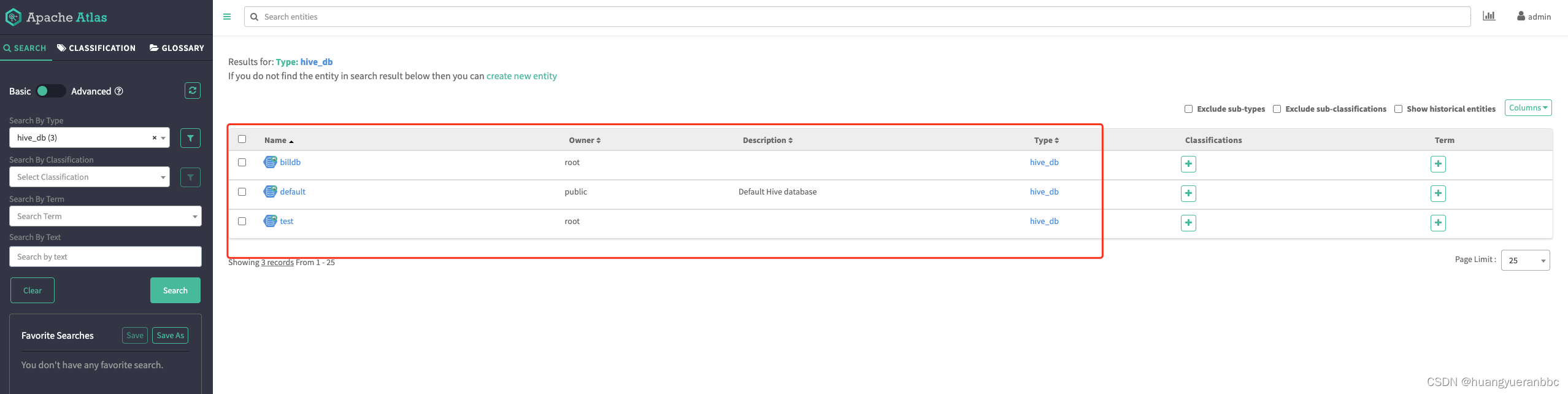

首次离线同步元数据

进入hook-bin目录 atlas-2.1.0/hook-bin

执行 import-hive.sh即可将hive当前的元数据批量同步至atlas。