解压spark安装包

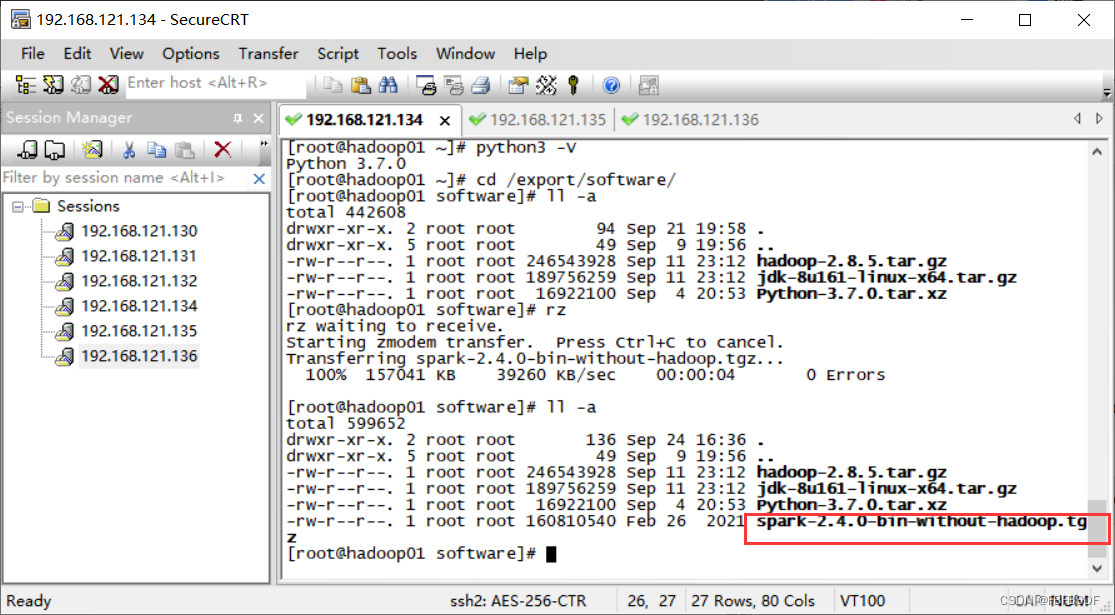

????????首先将spark-2.4.0-bin-without-hadoop.tgz 上传到hadoop01的/export/software/目录下,然后解压至?/export/servers/

[root@hadoop01 software]# tar -zvxf spark-2.4.0-bin-without-hadoop.tgz -C /export/servers/

?

?

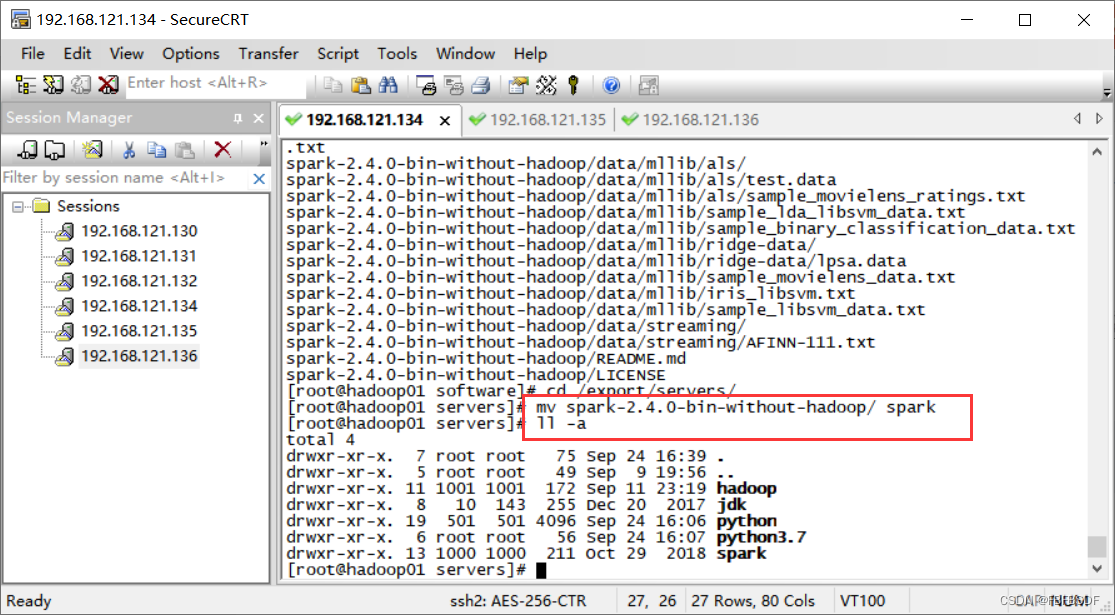

? ? ? ? 为方便后续操作,使用命令将Spark的目录重新命名为spark,命令如下:

[root@hadoop01 servers]# mv spark-2.4.0-bin-without-hadoop/ spark

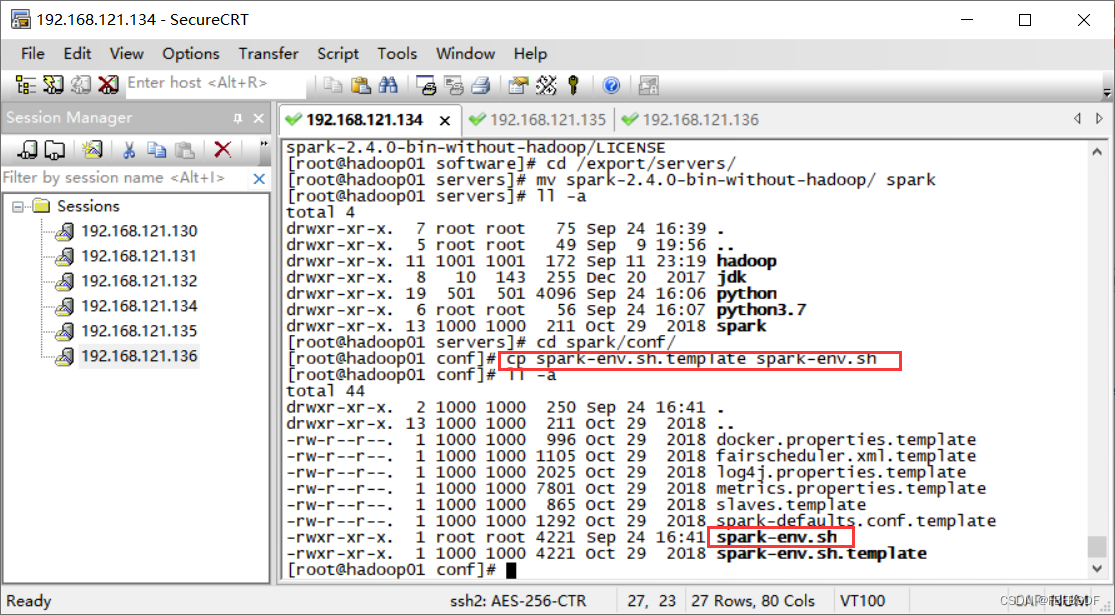

?修改配置文件

????????1)进入spark/conf目录修改Spark的配置文件spark-env.sh,将spark-env.sh.template配置模板文件复制一份并命名为spark-env.sh,具体命令如下。

[root@hadoop01 conf]# cp spark-env.sh.template spark-env.sh

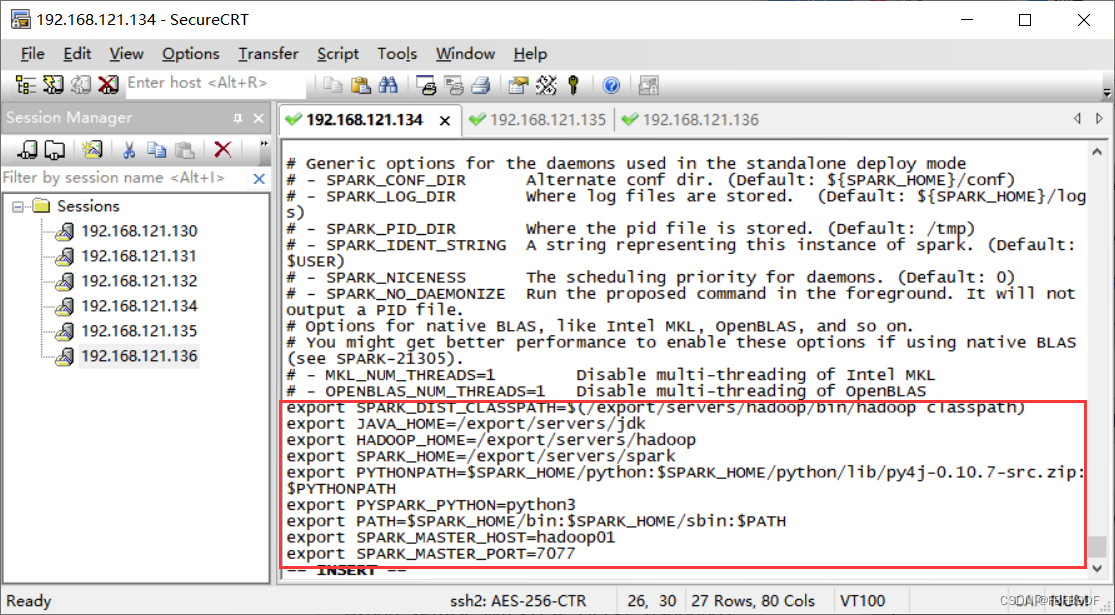

?????????修改spark-env.sh文件,在该文件中添加以下内容:

?????????修改spark-env.sh文件,在该文件中添加以下内容:

export SPARK_DIST_CLASSPATH=$(/export/servers/hadoop/bin/hadoop classpath)

export JAVA_HOME=/export/servers/jdk

export HADOOP_HOME=/export/servers/hadoop

export SPARK_HOME=/export/servers/spark

export PYTHONPATH=$SPARK_HOME/python:$SPARK_HOME/python/lib/py4j-0.10.7-src.zip:$PYTHONPATH

export PYSPARK_PYTHON=python3

export PATH=$SPARK_HOME/bin:$SPARK_HOME/sbin:$PATH

export SPARK_MASTER_HOST=hadoop01

export SPARK_MASTER_PORT=7077

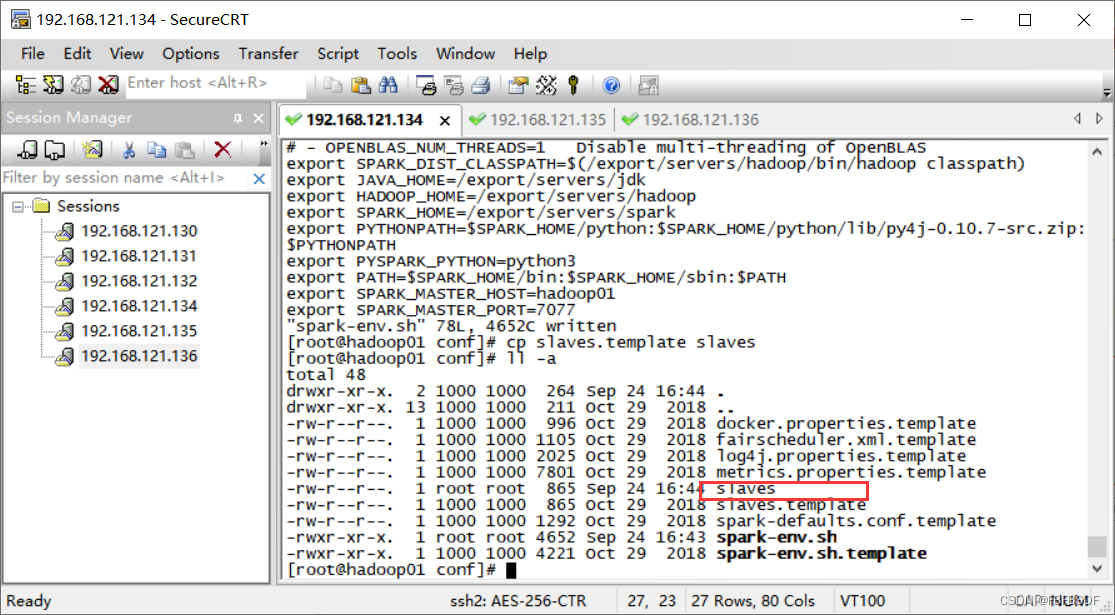

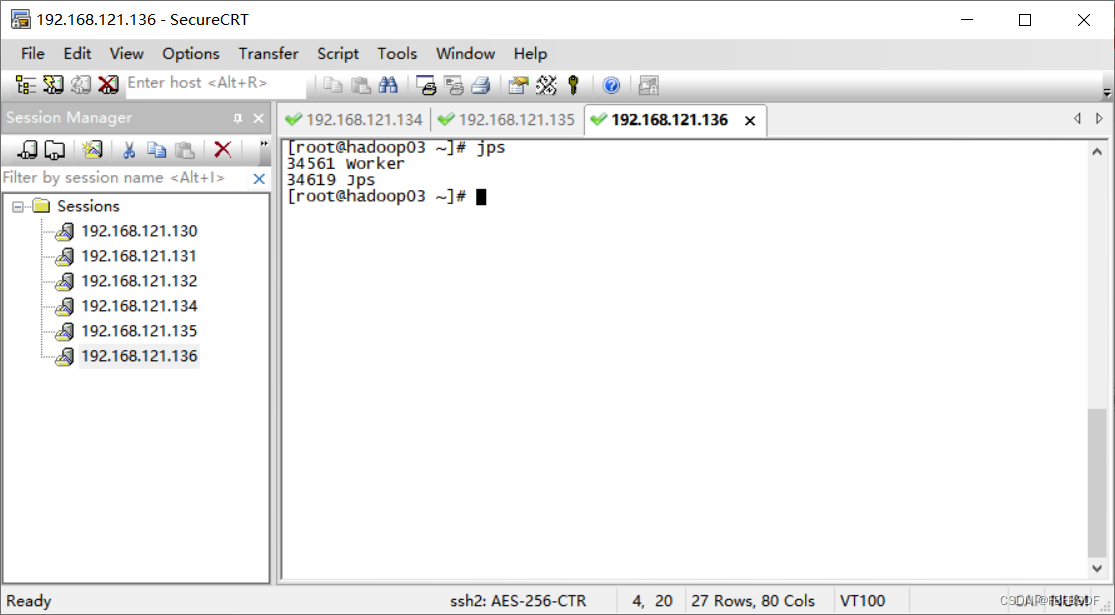

? ? ? ? ?2)复制slaves.template文件,并重命名为slaves,通过vi命令添加以下内容具体命令如下:

[root@hadoop01 conf]#?cp slaves.template slaves

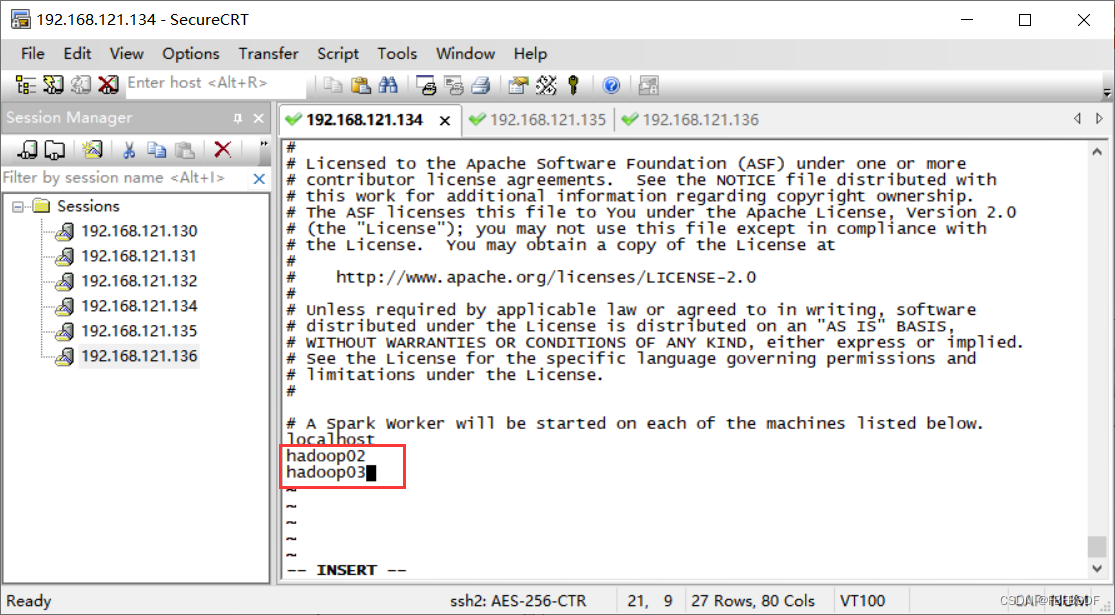

[root@hadoop01 conf]# vi?slaves

#添加内容

hadoop02

hadoop03

异常:后续主节点开启时出现worker,是因为localhost没有删除,后续删除后无异常出现

异常:后续主节点开启时出现worker,是因为localhost没有删除,后续删除后无异常出现

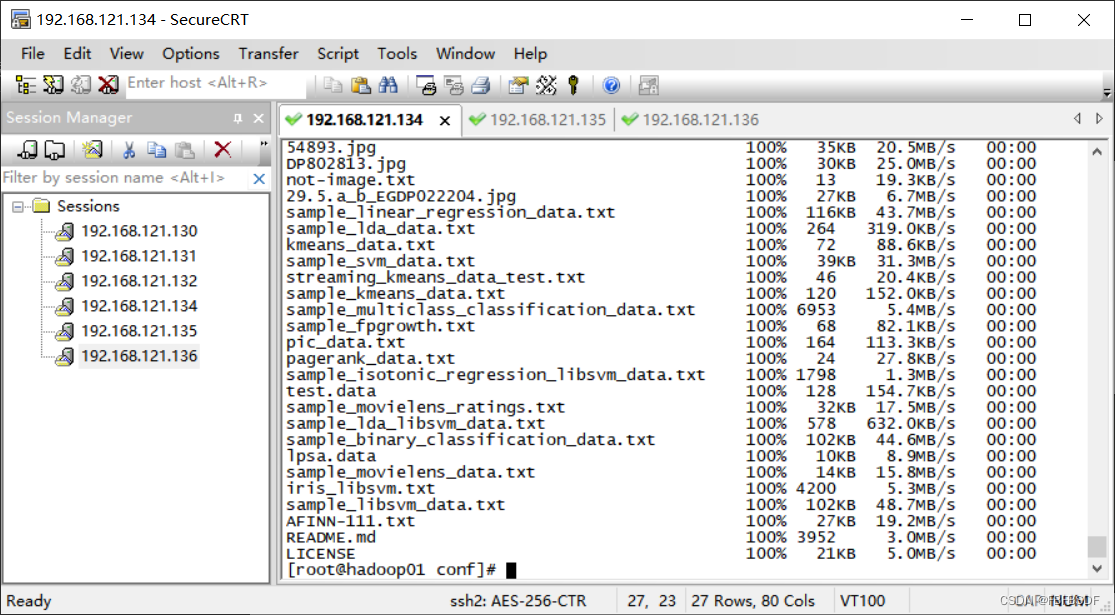

分发文件

scp -r /export/servers/spark root@hadoop02:/export/servers/

scp -r /export/servers/spark root@hadoop03:/export/servers/

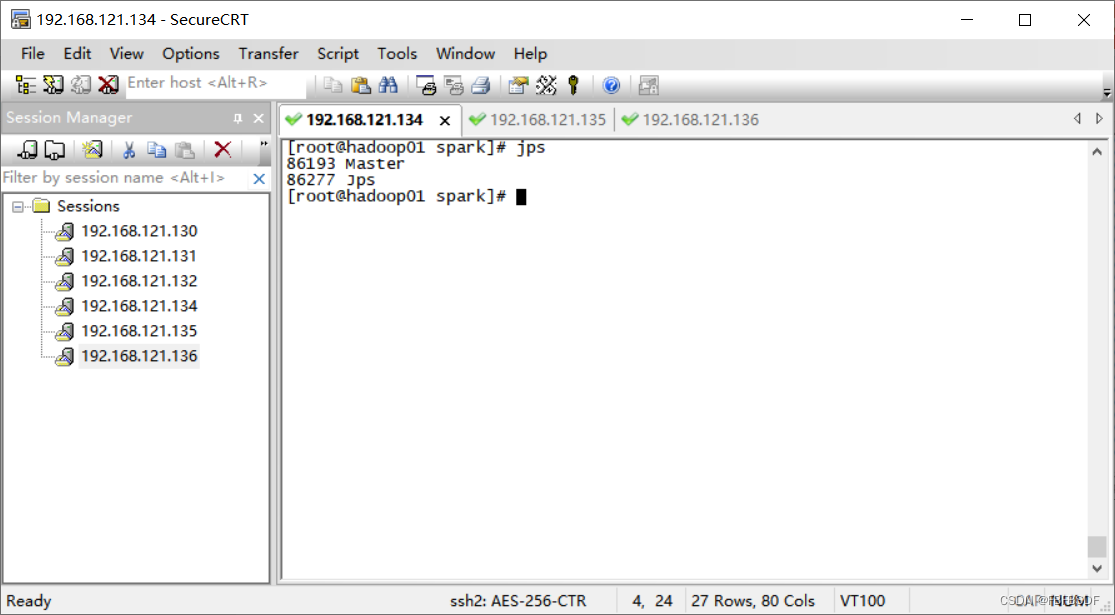

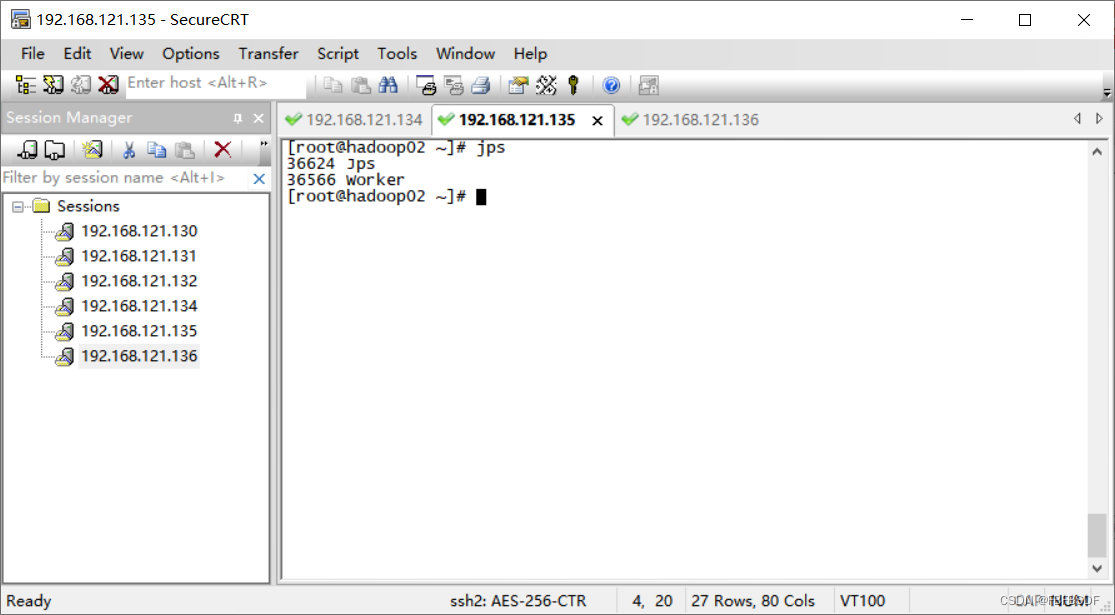

?启动Spark集群

在/export/servers/spark目录下执行命令开启,命令如下:

[root@hadoop01 spark]# sbin/start-all.sh

?

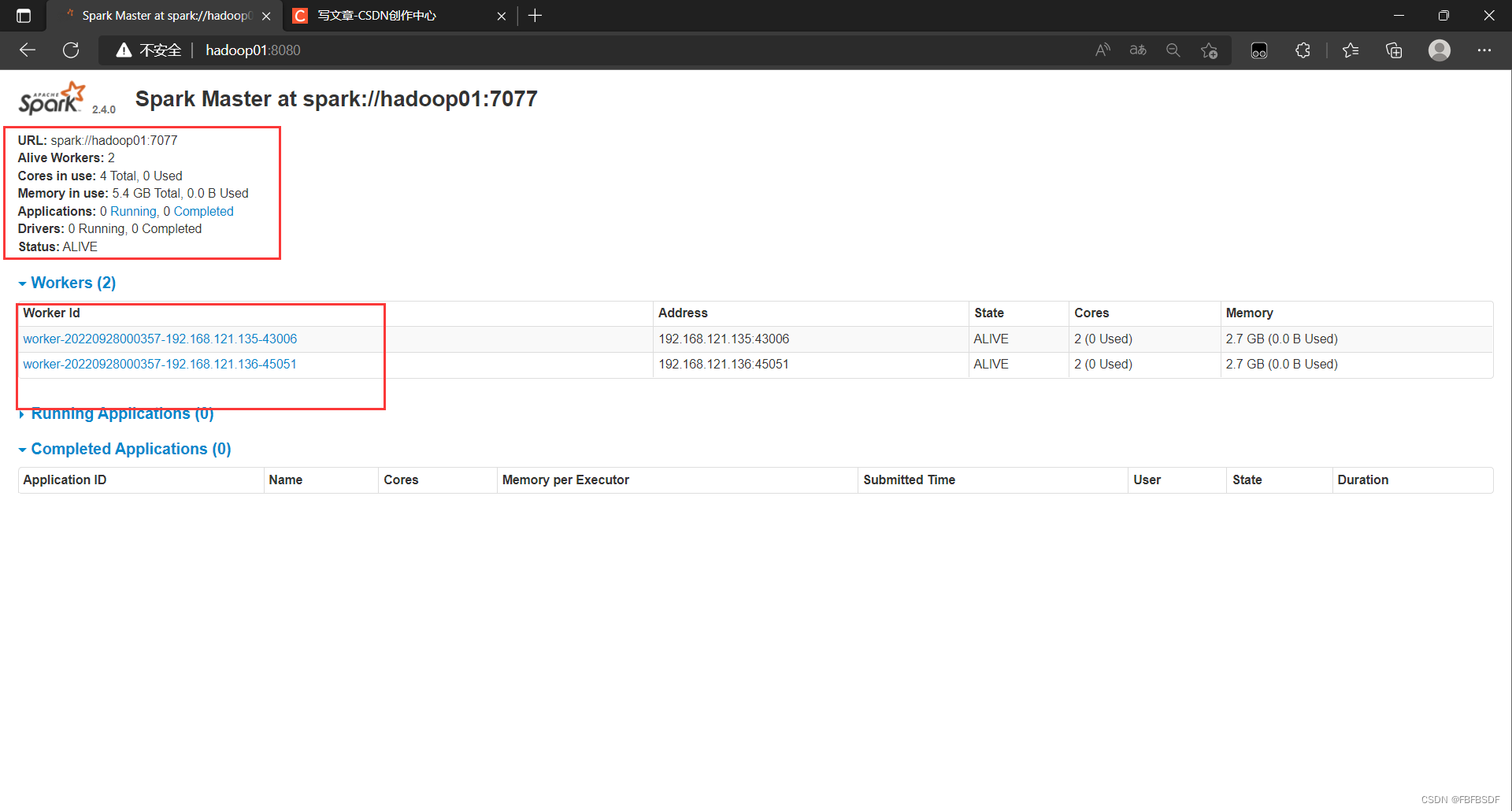

?访问https://hadoop01:8080;来查看集群状态