前言:本篇文章主要分享一些 Hadoop 集群的相关知识点,欢迎纠错指正。

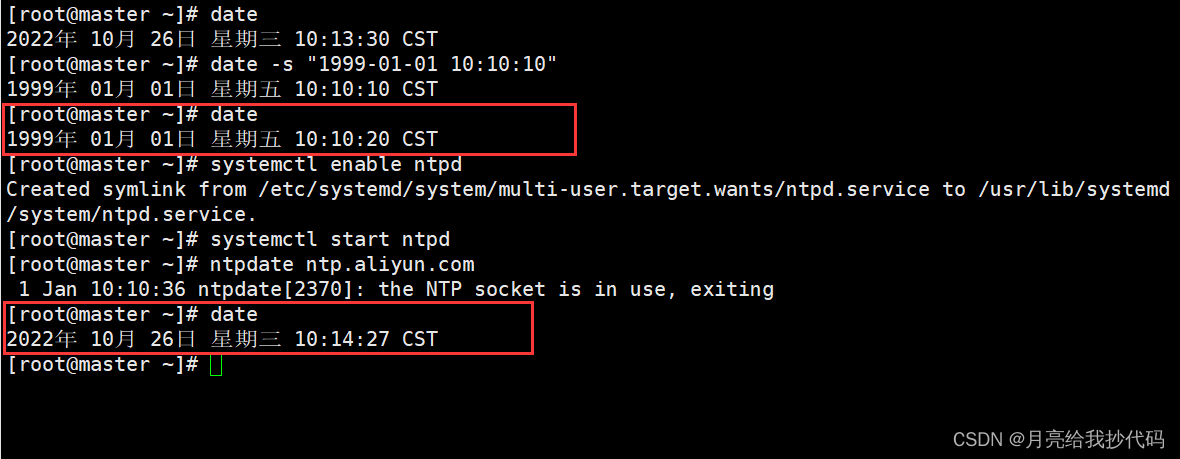

集群时间同步

先切换到 root 账户。

# 安装 ntp 服务

yum install -y ntp

# 启动 ntp 服务

systemctl enable ntpd

systemctl start ntpd

# 同步时间

ntpdate ntp.aliyun.com

集群启动或关闭脚本

我的集群规划如下:

| master | slave1 | slave2 | |

|---|---|---|---|

| HDFS | NameNode DataNode | DataNode | SecondaryNameNode DataNode |

| YARN | NodeManager | ResourceManager NodeManager | NodeManager |

请提前配置好各个主机之间的免密登录。

切换到 root 账号下的 bin 目录中,创建一个文件 tphadoop,根据自己的集群配置进行修改添加。

添加模板内容如下:

#!/bin/bash

source /etc/profile

# 参数小于 1 则直接退出。

if [ $# -lt 1 ]

then

echo "未输入任何参数!"

exit

fi

# 启动

if [ $1 = "start" ]

then

echo "----------------- 正在启动 Hadoop 集群----------------- "

ssh master "source /etc/profile;$HADOOP_HOME/sbin/start-dfs.sh;"

echo "----------------- dfs 启动完成----------------- "

ssh slave1 "source /etc/profile;$HADOOP_HOME/sbin/start-yarn.sh;"

echo "----------------- yarn 启动完成----------------- "

echo "----------------- 启动完成----------------- "

exit

fi

# 关闭

if [ $1 = "stop" ]

then

echo "----------------- 正在关闭 Hadoop 集群----------------- "

ssh master "source /etc/profile;$HADOOP_HOME/sbin/stop-dfs.sh;"

echo "----------------- dfs 关闭完成----------------- "

ssh slave1 "source /etc/profile;$HADOOP_HOME/sbin/stop-yarn.sh;"

echo "----------------- yarn 关闭完成----------------- "

echo "----------------- 关闭完成----------------- "

exit

fi

# 重启

if [ $1 = "restart" ]

then

echo "----------------- 正在关闭 Hadoop 集群----------------- "

ssh master "source /etc/profile;$HADOOP_HOME/sbin/stop-dfs.sh;"

echo "----------------- dfs 关闭完成----------------- "

ssh slave1 "source /etc/profile;$HADOOP_HOME/sbin/stop-yarn.sh;"

echo "----------------- yarn 关闭完成----------------- "

echo "----------------- 关闭完成----------------- "

echo "----------------- 正在重新启动 Hadoop 集群----------------- "

ssh master "source /etc/profile;$HADOOP_HOME/sbin/start-dfs.sh;"

echo "----------------- dfs 启动完成----------------- "

ssh slave1 "source /etc/profile;$HADOOP_HOME/sbin/start-yarn.sh;"

echo "----------------- yarn 启动完成----------------- "

echo "----------------- 重启完成----------------- "

exit

fi

echo "参数不匹配!请输入【start / stop / restart】参数来操作集群。"

exit

给创建的文件添加可执行权限:

chmod +x tphadoop

然后分发给其它机器:

rsync -r /bin/tphadoop slave1:/bin/

rsync -r /bin/tphadoop slave2:/bin/

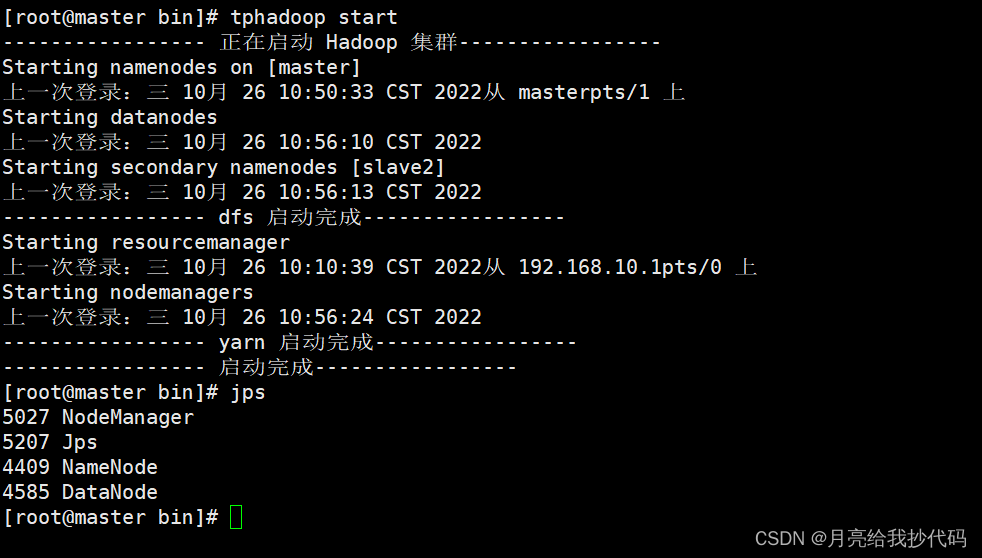

测试是否可以启动成功:

tphadoop start

NameNode:

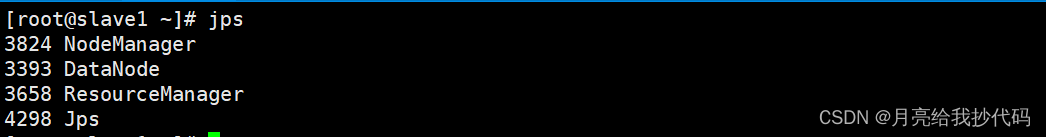

ResourceManager:

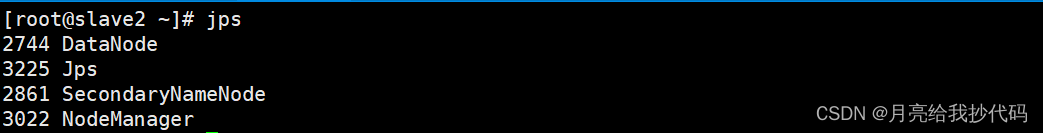

SecondaryNameNode:

可以看到,脚本运行正常,设置完成。

持续更新中…