文章目录

1 前言

相比于协同过滤和矩阵分解利用用户的物品“相似度”进行推荐, 逻辑回归模型将问题看成了一个分类问题, 通过预测正样本的概率对物品进行排序。

这里的正样本可以是用户“点击”了某个商品或者“观看”了某个视频, 均是推荐系统希望用户产生“正反馈”行为, 因此逻辑回归模型将推荐问题转成成了一个点击率预估问题。

要注意这和前面的协同过滤不太一样了, 那里是“TOPN"推荐的问题, 而这里通过逻辑回归转成了一种点击率预估问题, 成了一种二分类, 如果模型预测用户会点击, 那么就进行推荐。

但是由于LR表达能力不强,无法进行特征交叉,特征筛选等一些列“高级”操作,所以在LR的基础上引入了GBDT模型(利用该模型可以有效的构建交叉特征)。

2 传统的推荐系统模型

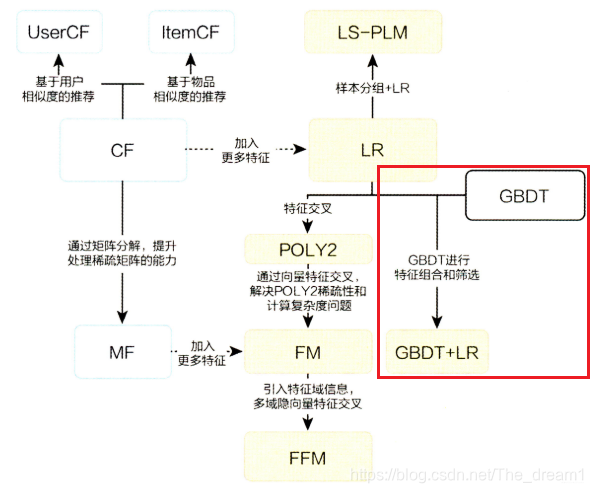

传统模型演化关系

这里对应的核心是 ——> gbdt+lr进行点击预测,然后应用到推荐系统当中。

3 GBDT+LR

3.1 LR简介

总的来说:

- 逻辑回归假设数据服从伯努利分布,通过极大化似然函数的方法,运用梯度下降来求解参数,来达到将数据二分类的目。

对于LR来讲有以下优点:

- LR模型形式简单,可解释性好,从特征的权重可以看到不同的特征对最后结果的影响。

- 训练时便于并行化,在预测时只需要对特征进行线性加权,所以性能比较好,往往适合处理海量id类特征,用id类特征有一个很重要的好处,就是防止信息损失(相对于范化的

CTR 特征),对于头部资源会有更细致的描述 - 资源占用小,尤其是内存。在实际的工程应用中只需要存储权重比较大的特征及特征对应的权重

- 方便输出结果调整。逻辑回归可以很方便的得到最后的分类结果,因为输出的是每个样本的概率分数,我们可以很容易的对这些概率分数进行cutoff,也就是划分阈值(大于某个阈值的是一类,小于某个阈值的是一类)

- 工程化需要, 在深度学习技术之前, 逻辑回归凭借易于并行化, 模型简单,训练开销小等特点,占领工程领域的主流,

因为即使工程团队发现了复杂模型会提升效果, 但一般如果没有把握击败逻辑回归的话仍然不敢尝试或者升级。

对于LR有以下缺点:

- 表达能力不强, 无法进行特征交叉, 特征筛选等一系列“高级“操作(这些工作都得人工来干, 这样就需要一定的经验, 否则会走一些弯路),

因此可能造成信息的损失 - 准确率并不是很高。因为这毕竟是一个线性模型加了个sigmoid, 形式非常的简单(非常类似线性模型),很难去拟合数据的真实分布

- 处理非线性数据较麻烦。逻辑回归在不引入其他方法的情况下,只能处理线性可分的数据, 如果想处理非线性,

首先对连续特征的处理需要先进行离散化(离散化的目的是为了引入非线性),如上文所说,人工分桶的方式会引入多种问题。 - LR需要进行人工特征组合,这就需要开发者有非常丰富的领域经验,才能不走弯路。这样的模型迁移起来比较困难,换一个领域又需要重新进行大量的特征工程。

有兴趣的可以参考(最好推导一下):https://blog.csdn.net/The_dream1/article/details/113341791

3.2 GBDT简介

3.2.1 首先解释下Boosting

Boosting可以概括为训练数据样本权重分布(1和2)和弱学习器权重分布(3)两部分:

-

先从初始训练集训练出一个基学习器,再根据基学习器的表现对训练样本分布进行调整,使得先前基学习器做错的样本受到更多的关注(通过施加权重来控制)

-

然后基于调整后的样本集训练下一个基学习器,如此反复进行,直到学得的基学习器的个数达到设定的个数T(基学习器的个数是我们需要调试的超参,通过交叉验证来选择)

-

对这T个基学习器根据他们的预测表现来施加不同的权重并结合在一起构成我们的强学习器。

为了更好理解,我们可以看下第i论的模型迭代过程

第i轮迭代要做这么几件事:

新增弱分类器WeakClassifier(i)与弱分类器权重alpha(i)

通过数据集data与数据权重W(i)训练弱分类器WeakClassifier(i),并得出其分类错误率,以此计算出其弱分类器权重alpha(i)

通过加权投票表决的方法,让所有弱分类器进行加权投票表决的方法得到最终预测输出,计算最终分类错误率,如果最终错误率低于设定阈值(比如5%),那么迭代结束;如果最终错误率高于设定阈值,那么更新数据权重得到W(i+1)

举个列子:

做个比喻,就好比当年考试,考完后老师会建议我们整个错题本,把做错的题写下来,然后着重学习它。目标预测用户留存,id1 。模型1,留存,实际:不留存。(id1,…idn 50个)给一个相对更高权重。 (NEW训练集),模型2训练。(错id样本点)更高权重。~重复,直至10次(假设10个训练)。

( 》》补!!!有点像调样本权重)

3.2.2 由Bosoting过渡到GDBT

GBDT与传统的Boosting(AdaBoost)有稍微一点的区别,区别主要集中在训练集样本的分布上,Boosting关注判断错误的样本;GBDT关注的是上一次的残差。

GBDT的核心就在于,每一棵树学的是之前所有树结论和的残差(负梯度),这个残差就是一个加预测值后能得真实值的累加量。

比如A的真实年龄是18岁,但第一棵树的预测年龄是12岁,差了6岁,即残差为6岁。那么在第二棵树里我们把A的年龄设为6岁去学习,如果第二棵树真的能把A分到6岁的叶子节点,那累加两棵树的结论就是A的真实年龄;如果第二棵树的结论是5岁,则A仍然存在1岁的残差,第三棵树里A的年龄就变成1岁,继续学。Boosting的最大好处在于,每一步的残差计算其实变相地增大了分错instance的权重,而已经分对的instance则都趋向于0。这样后面的树就能越来越专注那些前面被分错的instance。

3.3 GBDT+LR组合模型

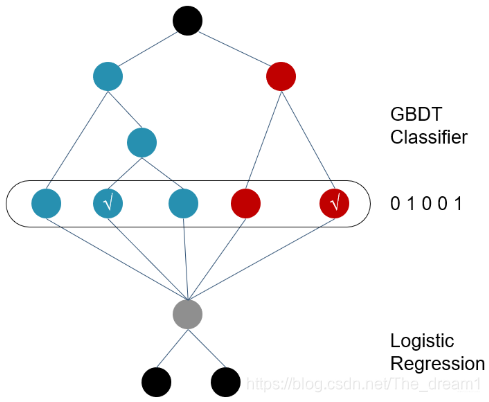

这个模型的总体结构可以用下面的结果图进行表示:

训练时,GBDT 建树的过程相当于自动进行的特征组合和离散化,然后从根结点到叶子节点的这条路径就可以看成是不同特征进行的特征组合,用叶子节点可以唯一的表示这条路径,并作为一个离散特征传入 LR 进行二次训练。

比如上图中, 有两棵树,x为一条输入样本,遍历两棵树后,x样本分别落到两颗树的叶子节点上,每个叶子节点对应LR一维特征,那么通过遍历树,就得到了该样本对应的所有LR特征。构造的新特征向量是取值0/1的。 比如左树有三个叶子节点,右树有两个叶子节点,最终的特征即为五维的向量。对于输入x,假设他落在左树第二个节点,编码[0,1,0],落在右树第二个节点则编码[0,1],所以整体的编码为[0,1,0,0,1],这类编码作为特征,输入到线性分类模型(LR or FM)中进行分类。

预测时,会先走 GBDT 的每棵树,得到某个叶子节点对应的一个离散特征(即一组特征组合),然后把该特征以 one-hot 形式传入 LR 进行线性加权预测。

这个方案应该比较简单了, 下面有几个关键的点我们需要了解:

- 通过GBDT进行特征组合之后得到的离散向量是和训练数据的原特征一块作为逻辑回归的输入, 而不仅仅全是这种离散特征

- 建树的时候用ensemble建树的原因就是一棵树的表达能力很弱,不足以表达多个有区分性的特征组合,多棵树的表达能力更强一些。GBDT每棵树都在学习前面棵树尚存的不足,迭代多少次就会生成多少棵树。