机器学习系列文章目录

机器学习——XGBoost算法介绍及代码实现

机器学习——时间序列分析

机器学习——模型融合

前言

K近邻算法的介绍以及代码实现过程

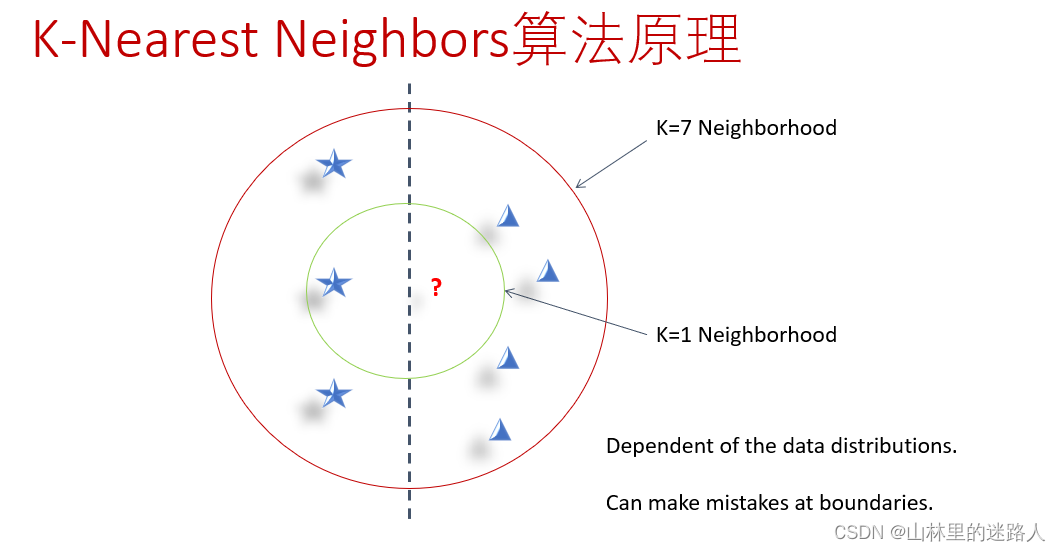

一、KNN算法原理

二、K-Nearest Neighbors算法特点

-

优点:

精度高

对异常值不敏感

无数据输入假定 -

缺点

计算复杂度高

空间复杂度高 -

适用数据范围

数值型和标称型

三、工作原理

-

存在一个样本数据集合,也称作训练样本集,并且样本集中每个数据都存在标签,即我们知道样本集中每个数据与所属分类的对应关系。

-

输入没有标签的新数据后,将新数据的每个特征与样本集中数据对应的特征进行比较,然后算法提取样本集中特征最相似数据(最近邻)的分类标签。

-

一般来说,只选择样本数据集中前N个最相似的数据。K一般不大于20,最后,选择k个中出现次数最多的分类,作为新数据的分类。

四、K值得选择

-

如果选择较小的K值

“学 习”的近似误差(approximation error)会减小,但 “学习”的估计误差(estimation error) 会增大

噪声敏感

K值的减小就意味着整体模型变得复杂,容易发生过 拟合. -

如果选择较大的K值

减少学习的估计误差,但缺点是学习的近似误差会增大.

K值的增大 就意味着整体的模型变得简单.

五、代码实现

kNN中的分类算法:

def classify0(inX, dataSet, labels, k):

dataSetSize = dataSet.shape[0]

diffMat = tile(inX, (dataSetSize,1)) - dataSet

sqDiffMat = diffMat**2

sqDistances = sqDiffMat.sum(axis=1)

distances = sqDistances**0.5

sortedDistIndicies = distances.argsort()

classCount={}

for item in range(k):

voteIlabel = labels[sortedDistIndicies[item]]

classCount[voteIlabel] = classCount.get(voteIlabel,0) + 1

sortedClassCount = sorted(classCount.iteritems(), key=operator.itemgetter(1), reverse=True)

return sortedClassCount[0][0]