引言

在测试执行过程当中,并不清楚现在测试到的结果到底能不能满足活动的需求,本次需求涉及到的模块和接口也不清楚,这种性能测试方式,就是没有做性能测试目标分析,虽然说做了性能测试,但是基本是无效的性能测试,因为:没有做目标分析的性能测试,会与真实的活动场景相差甚远

例如在使用前的测试和使用中的实际情况完全不一样,原因因为一个低访问量的接口没有纳入测试范围,性能测试目标是性能测试的重要先决条件指定目标可以确定范围内需要达到的测试结果,指定目标后才能对本次性能测试的核心目标有清晰的认知,并指导你做后期的测试活动,包括测试所需要的资源以及测试的停止条件等,在回答如何指定性能测试指标之前,要搞清楚我们衡量性能测试指标对于什么,TPS,报错率等需要有深入的了解,不仅仅知道各自代表的含义,还要知道是如何制定出来的

定制计划

衡量指标

TPS

第一个衡量指标TPS,很多人都说是并发,并发是指同一时间节点发生的事情,但同一时间节点并不是一个标准的度量,也不是性能测试直接测试来的结果,性能测试往往是通过在工具中增加虚拟用户数得到的接口每秒调用量去衡量,在实际生产中,不管是网关还是服务,通常都是记录一定时间内的访问请求次数,所以在业内,性能测试往往以TPS作为最重要的度量指标,因为它具有可度量性和通用性的特质,可度量行是指TPS是真实、客观且明确的衡量指标,通用性指无论在运维角度还是测试角度,TPS都可以达成一致的定义

响应时间

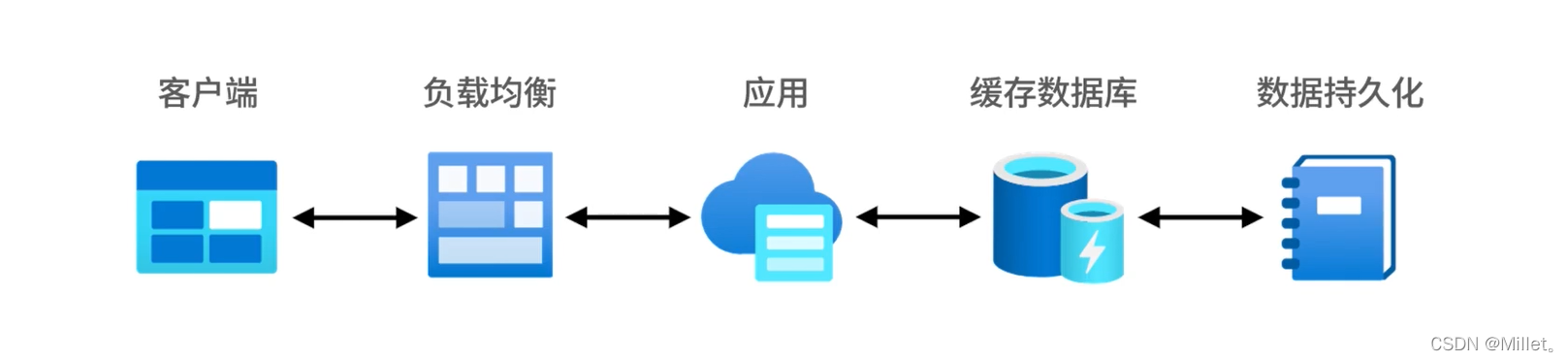

响应时间和用户体验密切相关,一个请求从客户端发出,到返回客户端的时间作为响应时间,在实际工作中,会以TPS的量级来限制响应时间必须在多久之内,

从响应时间过程图可以看出,从最左侧的客户端到最右侧的数据持久化,在返回到客户端,这样一次完整的过程就是一次完整的请求响应时间,这样的响应时间在正常情况下是这样的,在有了一定的性能测试实践之后,会发现这样的过程不是绝对的,比如有的业务在第一次请求数据库之后,应用层会把本地缓存放在应用服务器上,也就是接下来的缓存有效期内,不会去数据库取数据,而是在应用层取数据后会直接返回,所以响应实践会比第一次低很多,这也是随着性能测试的进行,响应时间变低的原因之一

报错率

报错率的计算方式是在统计时间范围内不符合返回期望的请求数/总共的请求数,在测试过程中,这一指标不符合期望的话,一般体现在对结果的校验上,一般分为三个层面去校验

1、状态码的校验

2、业务层面的校验(业务返回数据的正确性)

3、数据库校验(不建议在性能测试过程中校验,会影响性能,在测试后,做统计数据数量和状态)

以简单的登陆为例:

如果用户名密码不匹配则直接返回错误报文,不需要走正确流程的逻辑校验和数据库操作,存在很大的性能差别

性能测试指标分析

列举了最重要的三个指标TPS、响应时间和报错率,那我们如何定制测试目标呢?有人说根据28原则,老板说我们百万日活,80%的用户在20%的时间里去访问,响应时间根据业内的258来制定;还有人说竞品,业务定;实际上没有性能测试可以参考的有效信息,基本可以判断一个同学是否做过性能测试,那么说了半天,如何做呢?一般可以分为4种。

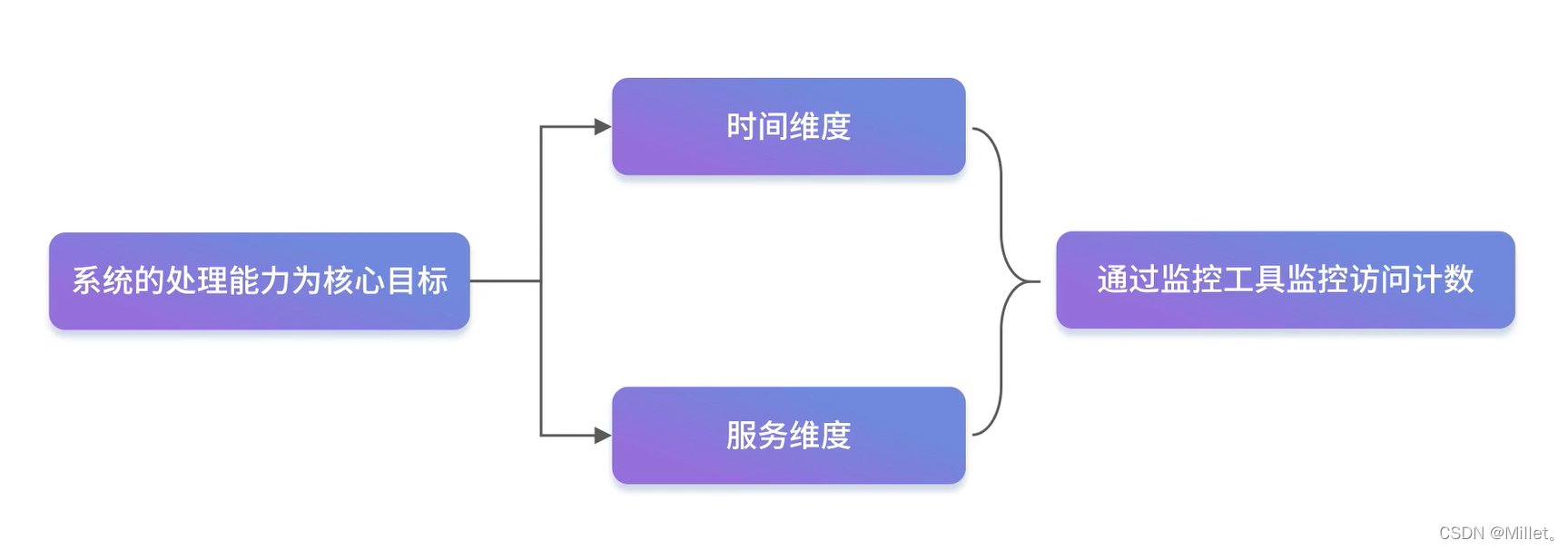

1、以衡量系统处理能力为核心目标的性能测试

以衡量系统处理能力为核心目标的性能测试一般是性能测试的主要目标,用来评估当前系统的处理能力和容量规划,评估这个目标最重要的是对数据的客观分析,那我们需要什么样的数据呢?对于每个接口都会有访问统计,这是目前业内比较常见的,也是衡量接口访问能力最准确的指标之一,一般会有自己的监控工具或者一些开源或商业工具,有了工具后,我们要从哪些维度去统计数据呢,通常我们会通过时间维度和服务维度来统计

时间维度

按照经验,我们一般会考虑大于当天的访问量来测试,当从分析的角度,一般前后半个月的时间都会考虑在测试范围内,首先我们需要根据大出前后哪些天数的访问量是比较高的,以天为单位,根据经验选择合适的时间范围,对最高峰和次高峰进行分析

当我们选了某一天,在以小时为维度进行分析,发现晚上的访问量大于白天,最高是晚上几点到几点,这样一来获取到我们在时间上所需要的数据,然后是服务维度

服务维度

什么是服务维度,以目前比较流行的电商微服务架构为例,会做微服务的拆分

网关是请求进入应用层的第一个入口,也是统计网站入口访问量的方式之一,当我们请求通过网关之后,下发到各个应用服务,我们会按照确定的时间节点统计各个服务的访问量数据,完成服务级访问量的统计,应该继续按照时间维度统计服务下接口的访问数据,你可以看到每个接口的调用比例都不一样,很多同学使用jmeter写性能测试脚本时,是用接口串联的方式进行,比如从登陆到浏览商品到添加购物车这样的添加方式,也就默认了用户登陆后就得浏览商品之后就得到购物车,这是典型的自动化测试思维