2021SC@SDUSC

1背景

学术类文章数量急剧增加。一方面为我们发现解决问题的方案提供了良好的参考;另一方面在大量信息中提取有用信息存在很大的难度。**关键词(keyfhrase)**在从大量文本中提取信息和数据检索具有重大作用。

2两类基本方法

关键词的提取有两类基本方法,监督(supervised)和无监督(unsupervised)。

在监督学习方法中关键词提取被转化成二分类问题,即正例(是关键词)和反例(不是关键词)。关于有监督学习的方法,论文中举了Frank在1999年的工作,他将将短语提取了两个特征——短语的TF-IDF和该短语距离其目标文档开头的距离。监督学习通常有着更高的准确率,然而监督学习需要大量数据,因此人们对于无监督学习的研究从未停止。

在无监督学习中关键词提取被阐述为一个排名问题(Ranking Problem)。而基于图的排序技术有着不错的表现,大致思路是为目标文档构建一个单词图,节点代表单词而边代表单词之间的关联,使用中心量度(graph centrality measures)为节点进行排序,并将具有最高排名的短语作为关键词返回。

3本文提出的方法

作者在论文中举了一个例子:

上图是一篇论文的题目和摘要,标红的部分为人工标注的关键词。我们不难看出,关键词常常出现在文章的开头并且可能多次出现,因此可以考虑**联合单词的位置信息(position information)和频率信息(frequency)**来设计一个无监督学习方法提取关键词。

基于此,作者引入了一个指标——位置排名(position rank),这是一个无监督的图模型,它将一个单词的所有位置信息整合到一个有偏PageRank中。经过实验,作者发现使用一个单词的所有位置信息比只使用单词第一次出现的位置信息具有更好的表现。

4模型详解

对于每一个单词,聚合所有的位置信息来计算一个权重,这个权重之后被整合到一个PageRank算法中。

4.1位置排名

算法步骤:

? 1.在所有单词上构建一张图。

? 2.设计Position-Biased PageRank。

? 3.候选短语生成。

4.1.1在所有单词上构建一张图

d:目标文档

G:G=(V,E)工作图

w:移动窗口,用于提取连续的内容(contiguous tokens,理解可能不准确)

首先选择d中的名词和形容词作为候选词。为d构造G,每一个候选词对应G中的一个节点。如果两个词在文章中一定范围w内同时出现,那么为这两个词对应的节点构造边,其中边的权重由两个词一起出现的次数确定(也就是说共同出现次数越多,认为联系越密切)。。

4.1.2设计Position-Biased PageRank

M:图G的邻接矩阵

S:PageRank分数向量,初始化为1/|V|

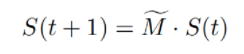

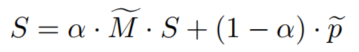

S需要被递归计算,第t+1次计算公式为:

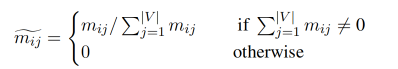

其中,

M

~

\widetilde{M}

M

为归一化后的M,归一化公式为:

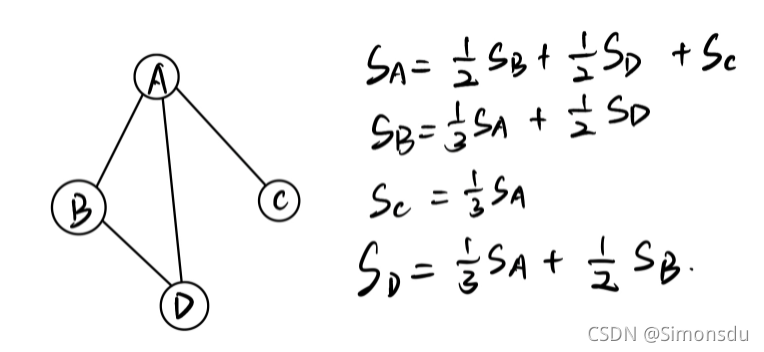

即vi的si由与其邻接的所有顶点的sj确定,并且sj需要根据该顶点邻接顶点的数量均分。由此递归计算,直到S收敛(满足一定大小关系)。

举例如下:

PageRank的计算可以看作是一个马尔科夫过程,其中S代表状态向量,而链接代表转移概率矩阵。为了保证计算可以收敛,我们使用如下式子(根据PageRank α是阻尼系数,一个经验性取值,比如0.85):

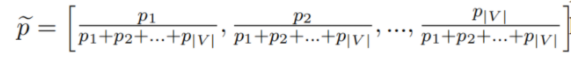

其中 p ~ \widetilde{p} p ?是一个长为|V|的向量,如果将 p ~ \widetilde{p} p ?中每一个值设置为相同的值,那么表示下一次等可能的进入其他节点,而若将值设为不同,那么可以表示下一次进入节点的“喜好”。

回到本文提到的方法,我们要考虑词的位置和频率信息,而且排名靠前的词拥有更高的可能性成为关键词。综上,我们可以采用词出现的所有位置的排名倒数之和作为

p

~

\widetilde{p}

p

?中该词的分,即

∑

1

r

a

n

k

\sum\frac{1}{rank}

∑rank1?。归一化结果如下:

4.1.3候选短语(phrases)生成

候选词列表中若有词在原文中连续存在,那么我们可以借助其生成候选短语,但要注意通常的表达习惯,如名词短语为形容词+名词,同时总长度不超过三个词。候选短语的分数由构成其的单词求和,最终将排名最高的候选短语作为结果输出。