参考论文:Character-oriented Video Summarization with

Visual and Textual Cues

介绍

随着社交媒体平台上内容再创造的发展,面向角色的视频总结已经成为了一个用户生成视频内容的关键形式。副标题和弹幕评论的出现使得视频伴随着丰富的文本信息,因此存在挖掘文本信息增强面向人物的视频总结的潜力。本文中我们提出一种独特的联合视觉和文本信息的架构。具体来说,首先我们通过无差别的定位人物,然后通过识别这些人物挖掘关键帧,这种情况下文本信息会被自动选择集成,最后关键帧会被聚合成面向人物的摘要。我们的实验作用在真实世界的数据集上用来验证我们的结果比现有的方法要好。

粉丝们热衷于剪辑视频中他们喜爱的明星,并取得了很好的视频热度,这个现象表明面向人物的摘要能够吸引到广大的用户,同时也提出了有效地生成视频总结的挑战。

和传统的视频总结任务不同,面向人物的视频总结任务应该包括出现具体人物的片段。因此,为了实现面向人物的总结,有必要去识别含有具体人物的片段。人物搜索任务已经通过联合探测和重新识别的模型或者是基于卷积LSTM的内存引导的模型被解决了。但是,这些之前的方法都是设计用来其他的应用场景上(例如视频监测分析)。因此,他们主要是集中于搜索相对相对静止的背景和动作的人物。在面向人物总结的场景中,背景和动作都是一直在变化的(不同场景有不同的衣服),这会增加难度,因此现有的人物搜索方法值得被进一步改进。

同时,弹幕作为一种丰富的文本信息,不仅可以提供及时的反馈,更多易于理解和客观的描述可以被实现,这样可以更清晰地去捕捉人物。文本信息有利于更高效地人物总结。

相关工作

视频总结

通常来说视频总结任务目的是产生一个短小的视频总结,总结给定视频的任务(例如高光时刻或者匹配特殊话题的片段或者描述)。通常下,突出检测被用来测量具体帧的重要程度和匹配程度,早期依赖于至下而上的图片线索(亮度、颜色、纹理)。最近,一些目标驱动的总结工具用语义线索尝试去学习高纬度的特点去揭露一些特殊的主题。同时,一些问题驱动的总结工具总结多组理想观念根据用户查询。除此之外,还有技术用个性化约束发展了实时视频摘要流算法。但是,这些方法都集中于语义或者相关话题的总结,很少有面向人物的片段。

人物搜索

人物搜索的目标是给定一个查询图片在一个场景中定位一个具体的人,分为两个部分:行人探测和重新识别。

对于行人探测,传统方法通常依赖于手写描述特征,现在依赖于深度学习。例如RCNN结构适用于达到比较好的效果。

对于重新识别模块,早期工作集中于特征设计和度量学习,最近一些高级的工具被提出,例如KPM模块去恢复两张相似图片,三元组损失去改善训练效率,在多级语义层级上没有人工注释下分解人的视觉外貌为潜在的因子,然后通过注意力网络去优化多任务学习。

结合上面两个模块,人物搜索解决方法被广泛用在在线例子匹配(用联合学习的方法)。但是,一些其他的研究人员分别擦用这两个模块,因为他们关注的分别是类间和类内的差异。本文中我们跟从两个模块分离的方法。

多模态学习

M-DBM用一个深度玻尔兹曼机去实现模态间融合,Lajugie尝试去学习一个Mahalanobis距离去执行多种时间序列的对齐,Lv设计了一个视频理解架构通过文本摘要去安排与时间有关的标签在高光视频上。同样,结构VSE提出一种对比学习的方式有效地在细粒度上的图片标题对齐上应用,DSM在情绪识别上通过多模态网络推断潜在的表情区域。

模型结构

问题定义

用一个序列 V = { f t } V=\{f_t\} V={ft?}去代表一个视频,带有时间戳t。在这条线上,每个帧或许包含若干个兴趣区域 R o I s RoIs RoIs,其中每个 R o I RoI RoI表明一个包含具体人物的回归框。其中 { R o I } t = ? \{RoI\}_t=\empty {RoI}t?=?表明在帧 f t f_t ft?内没有人物出现。用 D v = { d t } D_v=\{d_t\} Dv?={dt?}表示文本序列。具体来说,考虑帧 f t f_t ft?,语义相关的文本或许存在于相邻时期的帧。因此,直觉来说,我们定义时间窗口为 T s = [ t ? m , t + n ] T_s=[t-m,t+n] Ts?=[t?m,t+n]去捕获所有与{f_t}相关的文本。

最终,对于面向人物的摘要任务,给定目标人物C,对于那些RoI包含了C的帧会被捕获。用这种方法,我们收集了所有标签的 R o I t RoI_t RoIt?,对应的文本在窗口 T t T_t Tt?内作为 D t D_t Dt?,形成了C的查询 Q c = { < R o I t , D t > } Q_c=\{<RoI_t,D_t>\} Qc?={<RoIt?,Dt?>}对于视频摘要任务。

定义:给定视频V,文本信息 D v D_v Dv?,预标签查询 Q c Q_c Qc?包括目标人物C,我们目的是生成一个摘要视频S(由所有在V中包括了目标人物C的帧)

整体架构

框架由三个部分组成:探测、重新识别、聚合

- 探测:在V中定位人物去产生RoIs

- 重新识别:基于查询Q识别RoI中是否包含了目标人物C,含有目标人物C的潜在的关键帧会被收集

- 聚合:最终我们总结所有的收集的关键帧作为面向C的V摘要(基于时间间隔和密度)

探测模块

使用Faster R-CNN去探测不同大小的目标物体,也用了叠层式的RCNN去解决过拟合和推断时间不匹配的问题。在这个过程中,所有的人物会被无差别的定位。同时,为了增强效果,我们简化探测模块为一个二元分类器(一个RoI是否包含一个人物)。用这种方法,分类器的质量能够被充分的训练数据(面向人物的帧)保证。

重新识别模块

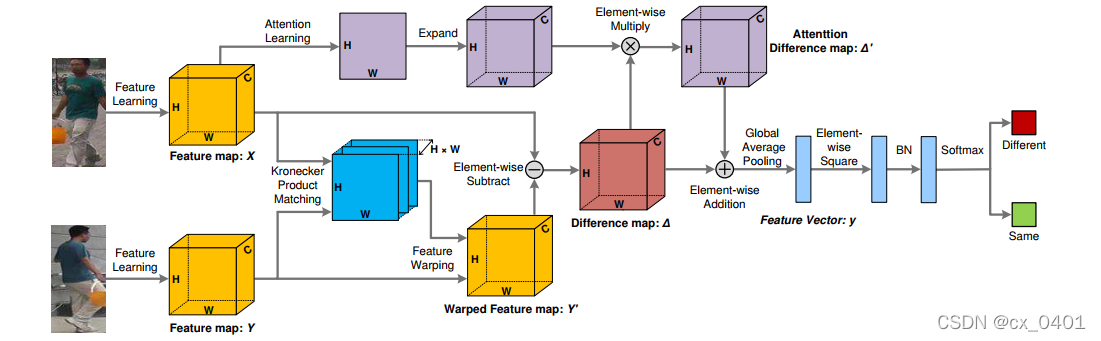

给定了探测模块中的RoIs,为了识别目标人物C,基于视觉和语义线索我们形成了一种结合了文本的重识别模块。具体来说,我们采用了KPMM作为我们模型的主干去提取成对的视觉特征(在行人重定位任务上取得了可观的效果)。沿着这个思路,文本信息可以作为扩展表征。

KPMM采用了一种深度CNN去生成多范围的特征映射,然后匹配这些基于KPM模块的特征对去产生特征差异映射用来相似性估计。值得注意的是,为了简化这个模型,我们替换特征提取部分(从ResNet50到ResNet34)。除此之外,我们在模型的剩余部分保持不变下添加特征差异映射去捕捉更多细节和本质的特征去估计视觉向量上的差异。最终,基于自适应的KPMM模型和文本表征的联合特征向量,目标人物C得以区分。

聚合模块

在重识别模块之后,我们现在得到了潜在的包含了人物C的关键帧。如果严格跟从面向人物摘要的定义,我们应该简单地连接所有的关键帧作为摘要视频。但是,考虑到视觉影响,浏览者或许更喜欢去浏览连续故事的流利视频,我们决定去“容忍”没有目标人物的部分帧用来连接两个片段。

我们首先连接所有相邻的关键帧去形成部分片段。然后,如果两个片段之间间隔短于设置的阈值会被连接成一个新的片段。最终为了确保连接片段的质量,我们研究了片段密度(定义为 ρ s = ∣ s f ∣ ∣ s ∣ \rho_s=\frac{|s_f|}{|s|} ρs?=∣s∣∣sf?∣?,其中 s f s_f sf?表明包含了目标人物的帧数量,其中 ∣ s ∣ |s| ∣s∣表明片段中帧的总数量)。相对应的,如果 ρ s \rho_s ρs?小于预定的阈值,片段会被丢弃。最终,我们连接所有保存下来的片段作为面向人物的摘要视频。

文本处理的解决方法

文件向量化

初始化步骤:首先尝试向量化每个文件(一条副标题或者弹幕)。直觉上来说,考虑副标题的强逻辑性和规范性,用负样本他们能够简单地被Skip-gram模型向量化。但是,对于被大量用户生成的弹幕评论,由于这类新颖的评论类型能够是非正式表达的短语或者俚语,我们可以用下面两种方式去向量化他们:

- 人物级别的LSTM,被用来处理弹幕评论中的非正式表达。这里我们用一个三层的人物级的LSTM去模型化弹幕中的序列特征。

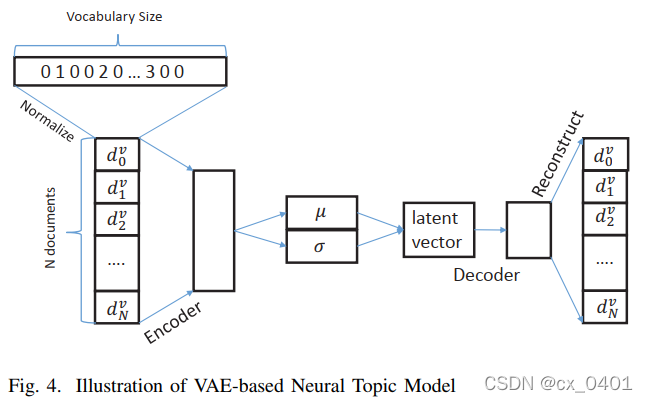

- 神经话题模型,被采用去挖掘弹幕中的隐藏主题。这里我们用基于VAE的Neural Topic Model作为提取器(由于强大的能力映射文件到后验分布上)。

首先初始化每个文件为向量 d v ∈ R W d^v\in R^W dv∈RW,其中 W W W是词汇表的大小。 d v d^v dv中的每个元素表明了一个人物在文件中的出现频率。然后再对 d v d^v dv进行下面的规范化处理:

g ( d v ) = l o g 10 ( I + d v ) f ( d v ) = g ( d v ) ∣ ∣ g ( d v ) ∣ ∣ 2 g(d^v)=log_{10}(I+d^v) \\ f(d^v)=\frac{g(d^v)}{||g(d^v)||_2} g(dv)=log10?(I+dv)f(dv)=∣∣g(dv)∣∣2?g(dv)?

然后再将此规范化的文件向量通过一个encoder传送去获取隐藏的话题分布( μ σ \mu \sigma μσ),其中向量z通过一个decoder被分布去重建 d v d^v dv

基于attention的语义表征

尽管文件已经被向量化,但是他们和视觉信息的关联仍是未知的。为了去增强文本和视觉之间的联系去得到联合学习的目的,我们提出一种通过注意力机制的语义表征的方法。其中两种现象值得关注:1)相邻的文本信息语义上是相似的 2)不同时间窗口的文本会根据视觉信息表达出不同的意义

基于1)我们将一个时间窗口分为k个相同长度的阶段,在同一个阶段的文件基于平均语义向量汇聚在一起,通过一个全连接层获取一个联合表征。

基于2)每个文件向量

H

i

H_i

Hi?会通过注意力机制测量出它们的重要性分数

α

i

=

e

x

p

(

H

i

T

V

i

s

)

∑

j

e

x

p

(

H

j

T

V

i

s

)

\alpha_i=\frac{exp(H_i^TV_{is})}{\sum_j{exp(H^T_jV_{is})}}

αi?=∑j?exp(HjT?Vis?)exp(HiT?Vis?)?,其中

V

i

s

V_{is}

Vis?表明通过自适应的KPMM在平均池化以及全连接层之后获取的视觉信息。

具体来说,顶级特征映射被选择用来描述内容(因为在CNN中它能表达更抽象的语义信息),其中每个时期的 H i H_i Hi?再通过加权变成: H i ~ = ( 1 + α i ) H i \tilde{H_i}=(1+\alpha_i)H_i Hi?~?=(1+αi?)Hi?。在这之后借用KPMM的思想,我们产生这个语义差矩阵 Δ H \varDelta_H ΔH?对于语义矩阵对 ( H x ~ , ( ~ H y ) ) (\tilde{H_x}, \tilde(H_y)) (Hx?~?,(~?Hy?))为 Δ H = H x ~ ? ( H x ~ H y T ~ ) H y ~ \varDelta_H=\tilde{H_x}-(\tilde{H_x}\tilde{H^T_y})\tilde{H_y} ΔH?=Hx?~??(Hx?~?HyT?~?)Hy?~?。最终我们压缩 Δ H \varDelta{H} ΔH为语义差向量,然后用视觉差向量去分离来支持re-ID模块的区分。

源选择机制

文本信息来源于两个途径:副标题和弹幕。其中副标题是人物第一人称视角直接的描述,弹幕是非正式表达的第三人称视角的描述。因此原则合适的文本信息是必要的。

选择机制:首先,我们用一个联合特征映射

U

v

∈

R

2

×

h

×

w

×

c

U_v\in R^{2×h×w×c}

Uv?∈R2×h×w×c来描述视觉内容,其中h,w,c分别代表顶层特征映射的长宽和通道数目。之后再经过一个池化层和全连接层。对于弹幕和副标题的语义差距矩阵

Δ

H

1

\varDelta_{H_1}

ΔH1??和

Δ

H

2

\varDelta _{H_2}

ΔH2??我们分别再经过一个矩阵

S

2

S_2

S2?处理

(

Δ

H

1

′

,

Δ

H

2

′

)

=

(

Δ

H

1

,

Δ

H

2

)

×

S

2

(\varDelta'_{H_1}, \varDelta'_{H_2})=(\varDelta_{H_1},\varDelta_{H_2})×S_2

(ΔH1?′?,ΔH2?′?)=(ΔH1??,ΔH2??)×S2?

最终我们从不同的源压缩语义差距矩阵,然后用视觉差异向量(前面的工作)拼接起来。