1, 架设定位器,HTCVIVE,两个定位器位于两侧略朝下,目的为了检测定位追踪器,两个最大距离不适宜唱过5米,小于2米,取中间距离,保持信号稳定输出;

2, 绑定追踪器到场景相机,将追踪器安置到相机上面,两个最佳

3, 在UE调试追踪器,

新建空actor命名为SceneMover,然后新建空actor,命名为CameraTracker,然后在CameraTracker底下放置Cine Camera Actor,命名为LiveCmaera, 将CameraTracker转换为蓝图可编辑actor,然后在RventGraph图框使用节点查找调用追踪器,此处需要使用tick事件:

配图如下:

先测试安装一个,再复制粘贴查找另外一个,如果此处一直没反应,可以尝试安装Steam,然后测试,这里补充下,如果需要把真是相机位置映射到虚拟场景相机,这一步是必须的,而且一定需要安装steam的,然后进行定位设置的;

4, 启动插件:“Blackmagic Media Player”,“Timecode Synchronizer”,”Apple Prores Media”,”Media Framework Utilities”,”Composure”;

5, 新建New Empty Media Profile,然后点击编辑新建的Media Profile,首次点击需要认证信息,点击认证就行,认证OK会有如下两个文件夹出现:

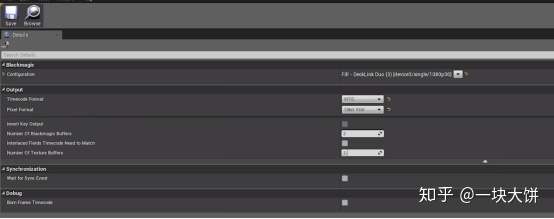

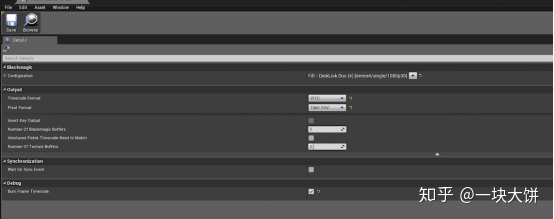

6, 接下来就是编辑Media Profile:

这里对以上数据进行简单说明,主要是视频格式要对,然后启动RGB,效果会比较好

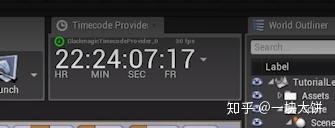

7, 这一步为了方便观看时间,可以选择启动:Windows-Developer Tools-Timecode Provider;

8, 通过Media新建 Media bundle:

此处将修改后的boundle拉进去场景,应该有摄像机的拍摄到的内容;

9,通过Media新建BlackmagicMediaOutput,命名为3dWorldOutputSDi,并设置参数如下

9, 接下来通过window-developer tools –Media Capture,然后在Media viewport capture 新建数组,然后在camera添加数组,选定前面第二部创建的livecamera,然后Media output选择为第九步设置的3dWorldOutputSDi,

10, 通过Media新建Blackmagic Media Output,命名为 VideoFeedOutputSDI;参数如下

11, 通过widow-composure compositing 鼠标右键新建新建comp,然后点击新建的comp右键add layer element ,选择Media plate,点击media plate 细节面板,input -mediasource-mediasource给上第五步生成文件夹里的media-bundles-MediaBundle-01_InnerAssets下的T_MediaBundle-01_BC,

12, 持续11步细节面板,output添加数组,outputpass选择media capture,然后capture output选择之前创建的videoFeedOutputSDI,

13, 鼠标右键点击11步生成的comp右键添加layer Element,命名为CG_Element然后把需要添加的物体拉到场景中命名:theactor_A

14, Window-layers-鼠标右键新建Empty layer,命名为:CG_layer,把13步添加的物体theactor_A直接拉到CG_layer;

15, 找到comp 中CG_Element的Composure-Input-Capture Actor添加数组中ActorSet选择14步新建的CG_Layer,切换到Composure-Output-Outputs添加数组,Capture Output选择第九步创建的3dWorldOutputSDI,然后清空第九步添加的数组;

16, 然后调节焦距,点击运行,将Camera输出的的流通过blackmagic mini input 输入到另外一台电脑,电脑最佳选择为苹果笔记本,然后在笔记本中通过OBS找到sources,选择进来的视频流,然后右键Filters开启Luma key 可以将虚拟物体和摄像机实际拍摄到的物体结合起来,虚拟物体是CG_layer中添加的物体;也就是虚拟物体合到真实场景中;

17, 接下来是如何操作把真是场景中的人合到虚拟场景中,这个需要借助绿幕场景之类的,原理前面基本差不多,这里17步紧接前面第十一步开始进行

18, Composure- meida_plate-transform Passes-composure-transform/Compositing Passes-transform Passes-Chroma Keying-key Colors添加数组,颜色修改为media_plate的背景色

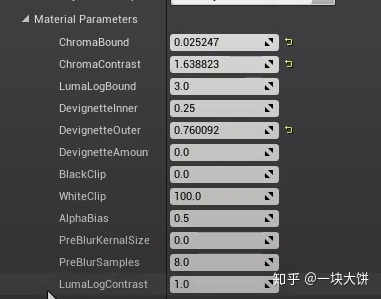

19, 然后就是紧接上步,调节对应的Material Parameters,这里不做一一介绍,给出个参考参数

20, 然后是对边缘颜色的过滤,对应上面第18步,调节Despill,添加Key Colors数组,吸附边缘交会的颜色,

21, 然后就是进阶上面调节Erode,边缘参数

22, 项目设置里postprocessing为linear color space only;

23, Comp添加CG_Layer,命名为BG,然后选中BG,Viewport Options-Create Camera Here-CineCameraActor;

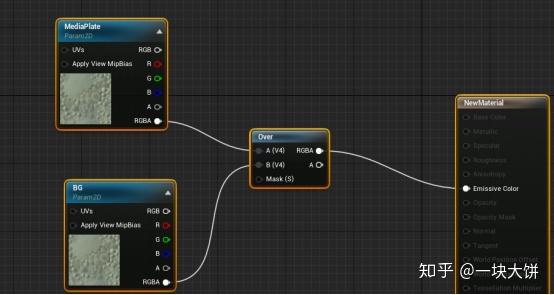

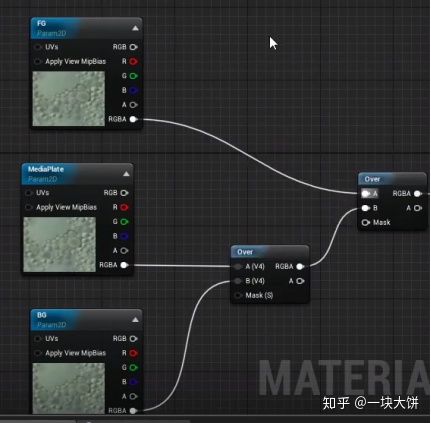

24, 新建材质M_comp_Tut为Post Process类型,使用材质TextureSampleParamter2D,具体参数如下

25, 然后选中Comp,Composure-input-TargetCameraActor给上场景中的CinCameraActor,Transform/Compositing passes-Transform Passes添加数组,其中Material给上24创建的材质,其中BG给上BG,MediaPlate给上Comp的media_plate1;此时正常应该合成了虚拟场景和绿幕的结合

26, 如果需要添加道具,物体之类的需要通过前面Layer的方式添加,具体可以看13,14步顺序;此处如果需要再次叠加背景雾气等,可以通过上面创建材质的方法在此叠加:

27,以上是自己搭建项目的流程,目的是为了了解原理,最后,如果对这块比价熟悉,或者是比较不想动手,我建议可以直接启动项目的时候选择虚拟制片模板项目,然后就可以直接启动里面虚拟制片对应的关卡,里面我上面讲解的流程和内容基本大部分都有了,可以对照修改下

28,接下来这一步呢,是吧相机接入UE,相机最好专业,使用SDI和HDMI接口都行,长距离选SDI,小于5米用HDMI接口

29,相机输入参数要和UE上面我提到的接受参数必须完全保持一致,大概就是接口,接受方式,速度,是否启用RGB,我建议中间使用OBS先把相机信号确定了,然后再推出OBS,使用UE进行调试,OBS和UE不能同时开启

30,如果想做多相机之间机位切换,可以多个相机对应UE多个location,中间借助导播台进行相机切换