文章目录

0. 摘要

最近,已经提出了一种生成变分自动编码器 (variational autoencoder, VAE) 用于语音增强以对语音统计进行建模。然而,这种方法只在训练阶段使用干净的语音,使得估计对噪声的存在特别敏感,尤其是在低信噪比 (SNR) 的情况下。为了提高 VAE 的鲁棒性,本文建议在训练阶段加入噪声信息,该策略可通过使用(noisy-clean pairs)训练的noise-aware encoder实现。本文使用两个不同的噪声数据集评估我们对不同噪声环境和声学条件的真实记录的方法。实验表明,本文提出的噪声感知 VAE 在整体失真方面优于标准 VAE,而不会增加模型参数的数量。同时,我们证明了我们的模型能够比有监督前馈深度神经网络 (DNN) 更好地泛化到看不见的噪声条件。此外,我们展示了模型性能对减少训练数据规模方面的鲁棒性。

1. Introduction

语音增强通常需要对噪声和语音的功率谱密度(PSD)进行统计估计,非负矩阵分解(Non-negative matrix factorization, NMF)是PSD估计的常用方法。然而,在对复杂的高维数据建模时,线性假设条件限制了NMF方法的性能。 相比之下,基于非线性深度神经网络(DNN)的语音增强表现出更好的建模能力。 常见的方法侧重于以监督方式推断时频掩码 [7]。 然而,为了推广到看不见的噪声条件,DNN需要引入大量的数据进行训练。

生成变分自编码器(generative VAE)是一种概率模型,广泛用于学习概率分布的潜在表示。VAE具有与经典自编码器类似的结构,为encoder和decoder架构,但是VAE的潜在空间不同,其需要经过正则化处理,以满足标准高斯分布。此外,VAE方法已应用于单通道和多通道语音增强场景中[14-16]。这些方法仅对纯净语音频谱进行训练,以此来对语音统计进行建模。然而,由于在训练阶段缺少噪声信息,标准VAE的encoder对噪声很敏感,在低信噪比情况下,这种噪声敏感性会导致对潜在变量的错误估计,从而导致不恰当地生成语音系数并降低性能。

[14] Y. Bando, M. Mimura, K. Itoyama, K. Yoshii, and T. Kawahara, “Statistical speech enhancement based on probabilistic integration of variational autoencoder and non-negative matrix factorization,” in IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), 2018, pp. 716–720.

[15] S. Leglaive, L. Girin, and R. Horaud, “A variance modeling framework based on variational autoencoders for speech enhancement,” in International Workshop on Machine Learning for Signal Processing (MLSP), 2018, pp. 1–6.

[16] S. Leglaive, L. Girin, and R. Horaud, “Semi-supervised multichannel speech enhancement with variational autoencoders and non-negative matrix factorization,” in IEEE International Conference on Acoustics, Speech and Signal Processing (ICASSP), May 2019, pp. 101–105.

受conditional VAE 及其在图像分割应用中的启发,为了提高噪声鲁棒性,本文提出用噪声感知编码器替换 VAE 的编码器。首先使用干净语音频谱训练VAE,之后使用带噪语音进行训练,以有监督的方式进行训练,使得潜在空间表示尽可能接近仅使用纯净语音训练的encoder。本文方法以VAE-NMF的语音增强框架为基础,该模型框架中,NMF用于对噪声的PSD进行建模。实验结果表明,本文方法对噪声存在更加鲁棒,并且在不增加模型参数数量的情况下改进了语音估计。 该方法还通过评估来自不同噪声数据集的真实记录,显示出对看不见的噪声条件的鲁棒性。 最后,本文说明使用少量noisy-clean的语音数据可以改善整体失真。

2. Problem Formulation

2.1 Mixture model

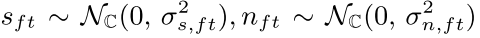

本文考虑加性噪声模型,在STFT变换域表示为:

假设语音和噪声谱是具有零均值的相互独立的复高斯分布。表示为

信号的 功率谱密度(PSD)由局部平稳假设下的参数方差表征。

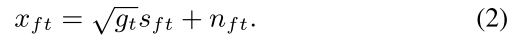

此外,为了增加对音频话语响度的鲁棒性,引入了与时间和频率无关的增益 gt。因此,(1)中的加性混合模型可修改为

带噪语音服从复高斯分布,可表示为:

2.2 Speech model

对于基于 VAE 的语音模型,定义了逐帧的 D 维潜在变量 z t ∈ R D z_t \in R^D zt?∈RD,并假设从条件似然分布 p θ ( s t ∣ z t ) p_{\theta}(s_t|z_t) pθ?(st?∣zt?)中采样 F 维语音帧 s t s_t st?。这项工作可通过VAE的decoder实现,也称为生成模型。变量 θ \theta θ表示decoder网络的参数, σ ^ s 2 \hat{\sigma}^2_s σ^s2?表示非线性函数。

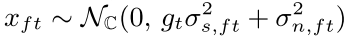

VAE方法遵循贝叶斯框架,联合学习潜在变量和推理模型,需要逼近难以处理的真实后验分布

p

(

z

t

∣

s

t

)

p(z_t|s_t)

p(zt?∣st?)。在VAE中,encoder又称为推理模型,用于近似真实后验分布,表示为

q

?

(

z

t

∣

s

t

)

q_{\phi}(z_t|s_t)

q??(zt?∣st?)。在随机梯度下降下,生成模型的参数 θ 和推理模型的参数 φ 通过最大化变分下限联合优化,由下式给出

p

(

z

t

)

p(z_t)

p(zt?)表示D维变量

z

t

z_t

zt?的先验分布,KL 表示 Kullback-Leibler 散度。潜在变量的先验定义为一个零均值各向同性多元高斯 zt~N(0, I),目标函数(3)中的第一项是指潜在空间中的正则化误差,以确保有意义的潜在变量,第二项是重建误差。

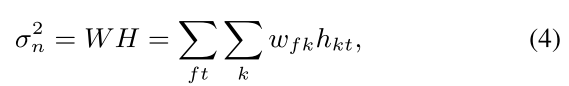

2.3 Noise model

NMF 试图通过包含由系数矩阵加权的基函数的字典矩阵来找到输入矩阵的最佳近似值。本文利用NMF对噪声方差进行建模,噪声方差通过字典矩阵

W

∈

R

F

×

K

W \in R^{F \times K}

W∈RF×K和系数矩阵

H

∈

R

K

×

T

H \in R^{K \times T}

H∈RK×T相乘的结果进行近似:

K表示噪声模型的秩,用k索引。

w

f

k

和

h

k

t

w_{fk}和h_{kt}

wfk?和hkt?分别表示W和H的元素。

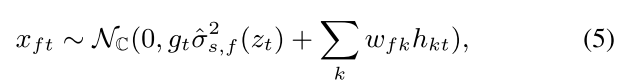

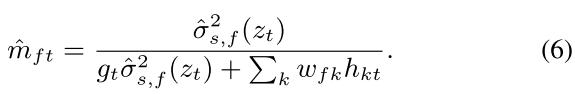

2.4 Clean speech inference

通过使用VAE和NMF分别对语音和噪声进行建模,带噪语音的分布可以表示为:

其中

σ

^

s

,

f

2

\hat{\sigma}^2_{s, f}

σ^s,f2?表示对第f个频点的非线性函数

σ

^

s

2

\hat{\sigma}^2_s

σ^s2?。给定噪声混合作为观察值,蒙特卡洛期望最大化 (MCEM) 算法用于估计 NMF 参数和增益因子,采样策略基于Metropolis-Hastings算法。通过构造维纳滤波

m

^

f

t

\hat{m}_{ft}

m^ft?,可以从带噪语音中提取出纯净信号。

3. Noise-Aware VAE

本文提出一种噪声感知编码器,可以提高编码器对噪声存在的鲁棒性。对于生成过程,很难甚至不可能推导出潜在变量和目标之间的最佳映射。 然而,我们认为,使从噪声混合估计的潜在变量尽可能接近从相应的纯净语音中推断出的潜在变量可能是相关的。

本文提出了两步学习方法,学习从带噪信号到潜在变量之间的非线性映射,该潜在变量表示了纯净语音的统计。本文首先利用公式三训练VAE,从而学习干净语音信号上的正则化潜在表示。然后,noise-aware encoder用于在带噪混合语音

x

t

x_t

xt?的条件下,逼近D维潜在变量

z

t

′

∈

R

D

z'_t \in R^D

zt′?∈RD输出的概率

q

γ

(

z

t

′

∣

x

t

)

q_{\gamma}(z'_t|x_t)

qγ?(zt′?∣xt?),还假设条件概率

q

γ

q_{\gamma}

qγ?服从标准高斯分布。变量

γ

\gamma

γ表示encoder的参数。最后,从带噪语音得到的

z

t

′

z'_t

zt′?到相应的纯净语音推断得到的潜在变量

z

t

z_t

zt?的距离基于Kullback-Leibler散度最小化,如图2(a)所示,对应公式如下:

μ

~

d

和

σ

~

d

2

\tilde{\mu}_d和\tilde{\sigma}_d^2

μ~?d?和σ~d2?表示神经网络对变量

z

t

′

z'_t

zt′?后验高斯分布的均值和方差的非线性映射。通过使用随机梯度下降算法最小化成本函数来优化新推理模型 γ 的参数。 通过这种方式,我们结合了 VAE 对语音特征的无监督学习和使用噪声-干净语音信号对的监督学习。

如图 2 (b) 所示,通过在潜在空间中引入这个成本函数,从噪声混合 xt 估计的潜在变量 zt 被拉向从相应的干净语音 st 估计的 zt。 这里的虚线表示从信号空间到潜在空间的非线性映射,不同的颜色表示两个映射对。 在推理阶段,噪声感知推理模型用于替代标准的基于语音的编码器,VAE 的解码器保持不变。

4. 实验验证

语音数据 WSJ0

噪声数据集:QUT-NOISE 和 DEMAND。其中QUT-NOISE用于构造训练集合测试集,DEMAND用于构造unseen验证集。

信号采样率为16kHz, STFT变换时使用窗长1024,hop_length为25%。由于 Kullback-Leibler 散度与尺度相关,因此采用全局归一化为零均值和单位标准差来训练噪声感知编码器。NMF的秩选择K=8,W和H随机初始化。MCEM方法的参数设置与[15]相同。

VAE的encoder和decoder包含两个128单元的前馈隐藏层,隐藏层使用双曲正切激活函数,潜在空间L的维度设置为16。

评价指标为SI-SDR。

5. Result and Discussions

5.1 Performance evaluation

5.2 Analysis of the amount of training data