Multimedia Tools and Applications (2019) CCF-C

面部动画从2D到3D的实时表情迁移

Abstract

提出了一种三阶段的方法,通过检测人脸表情并将其实时转移到三维模型中:

有肌肉关节的面部模型

检测图片上的关键点,用骨骼动画来拟合这些位置

用关键帧来记录骨骼动画

基于平均人脸

不需要训练

使用单个相机来跟踪

我们的贡献是:

将检测到的面部坐标的2D信息转换为3D面部关节的运动,不需要深度信息或用户的校准

改进了3D模型的嘴部运动,通过眉毛标志和平均的3D脸得到了嘴部动作的限制条件

根据视频实时生成3D动画

可以夸张或限制的表情转移到3D模型中,允许编辑动画帧

可以通过各种设备来生成面部动画

3 Overview

面部建模、数据的采集和传输、生成模型动画

3.1 Facial modelling

3.2 Data acquisition and transfer

3.3 Animating

4 Methodology

4.1 Preparation of 3D face model

面部跟踪系统可以跟踪被检测到的人脸上预定义的面部地标,并提供地标的视频大小相关的坐标。

我们的系统将与视频大小相关的世界坐标转换为相对坐标,以提供在面部地标上的相对运动。

这种相对运动依赖于一个基于关节的关节定位平台,它考虑到跟踪标志和基于伪的肌肉建模。

该系统是建立在最首选的动画程序之一[2]。

我们开发了一种名为“关节钻机工具”(JRT)的工具,它可以创建一个基于关节的钻机,并在眉毛、眼睛、嘴和鼻子上定位两个嵌套的关节。

将一个球体作为一个控制器形状分配给每个集合,以简化关节的使用。

这两个关节,一个作为偏移关节,另一个作为控制器关节,使用Maya的“关节”属性,并允许使用相对坐标。

控制器关节相对于其偏移关节移动,其中偏移关节保持在其初始位置。

图2a显示了控制器关节与其偏移关节的相对运动。

带有基本摄像头的跟踪系统只提供面部地标的x轴和y轴坐标。

这些坐标足以产生眼睛、眉毛和鼻子关节在x-y平面上的相对运动。

然而,嘴在z轴上的高运动能力需要一个不同的口端关节系统。

我们为每个嘴端关节的控制器分配了一个受限制的圆周运动能力,它由眉毛曲线控制。

眉端关节限制了嘴端关节在x轴和z轴上的最远运动。

深度运动是通过在z轴上移动与x轴上的运动来提供的。

当嘴端关节的x坐标更接近眉端关节的x坐标时,嘴端关节的z坐标相对地更接近眉端关节的z坐标。

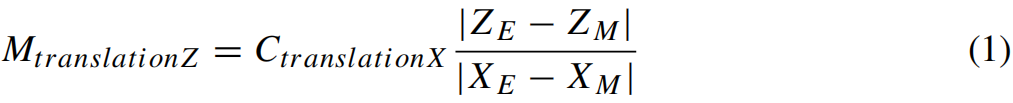

口端面部标志(CprenenationX)的转换x轴运动被直接指定为嘴端的x轴运动联合控制器

公式中的XE和ZE表示眉端偏移关节x和z坐标,其中XM和ZM表示嘴端偏移关节x和z坐标。

图2b显示了圆周运动,其中k表示计算出的比率。

此外,JRT创建了一个头部平台,并为头部运动转移准备了模型。

嘴部表情的运动被简化为x轴的运动

CtranslationX:面部照片上的x轴坐标

MtranslationX:模型上的x坐标

4.2 Expression recognition and transfer

4.3 Real-time animation of 3D model

假定48个点中有4个点不随表情变化(图中标出来的4个rp)

找到其余点与这48个点的相对位置变化

然后形变3D模型