首先我们来学习一种反反爬策略UA伪装。

UA是User-Agent(请求载体的身份标识)

绝大多数网站都有一种UA检测的反爬机制,就是会检测请求载体的身份标识,如果检测到请求载体的身份标识为某一款浏览器,说明该请求正常,反之如果检测身份标识不是基于浏览器,那就是爬虫,很有可能服务器端拒绝该次请求。

UA伪装:让爬虫的身份标识伪装成某一款浏览器。

怎么伪装呢?

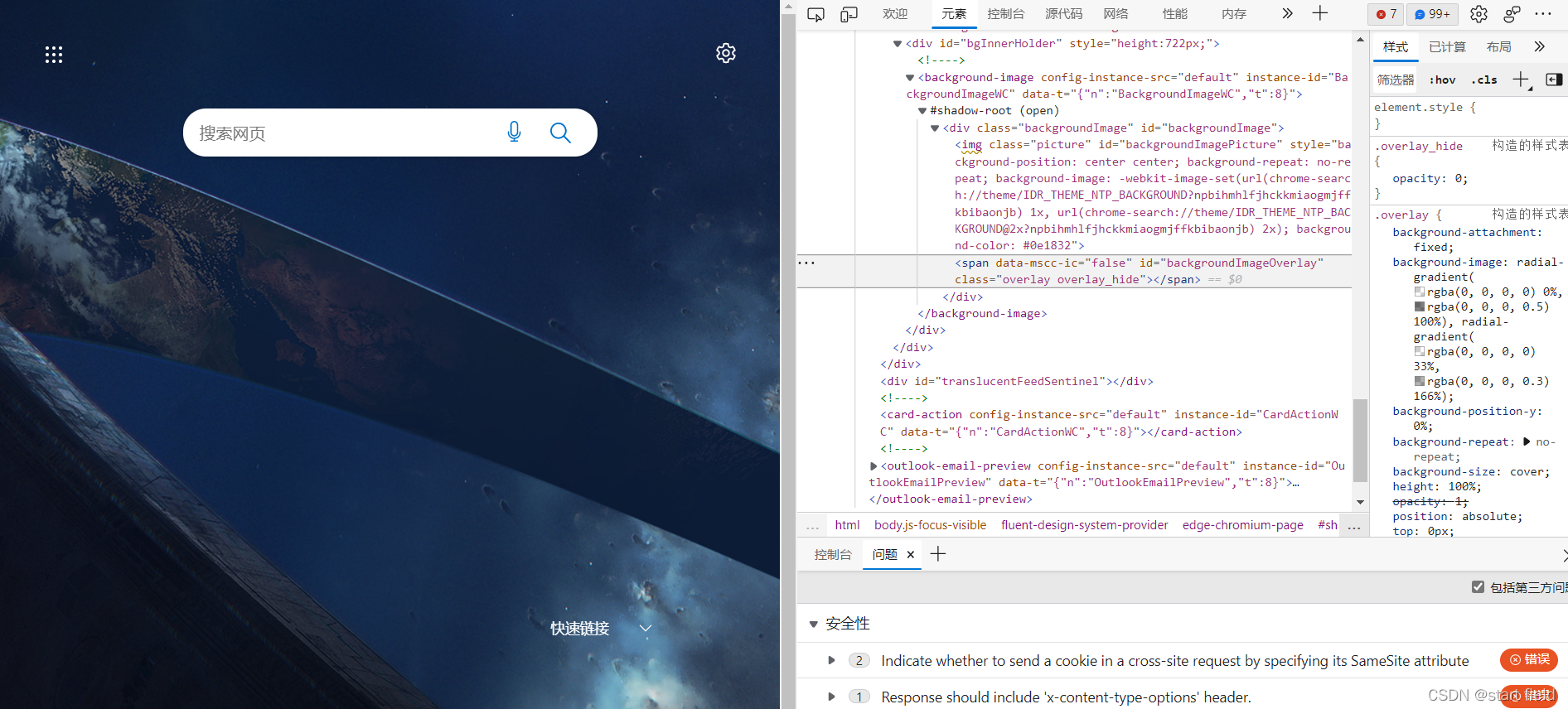

首先打开浏览器,按右键点击检查或者直接同时按fn和f12就打开了开发者工具

然后选择网络,在选择一个请求的头部,往下翻找到User-Agent然后复制封装到一个字典中。

headers = {

"user-agent": "Mozilla / 5.0(Windows NT 10.0;Win64;x64) AppleWebKit / 537.36(KHTML, likeGecko) Chrome / 97.0.4692.71Safari / 537.36Edg / 97.0.1072.55"

}

在发起请求时放进去

page_text = requests.get(url=url,headers=headers)

接下来处理如果url中要携带参数怎么办。

同样也是把参数封装到一个字典中,不过get请求是赋值到params,post请求是赋值到data。

response = requests.get(url=url,params=param,headers=headers)response = requests.post(url=url,data=data,headers=headers)

?最后,怎么获取json格式的数据

json()返回的是对象(obj),只有确认响应内容是json类型的,才可以使用json()方法。

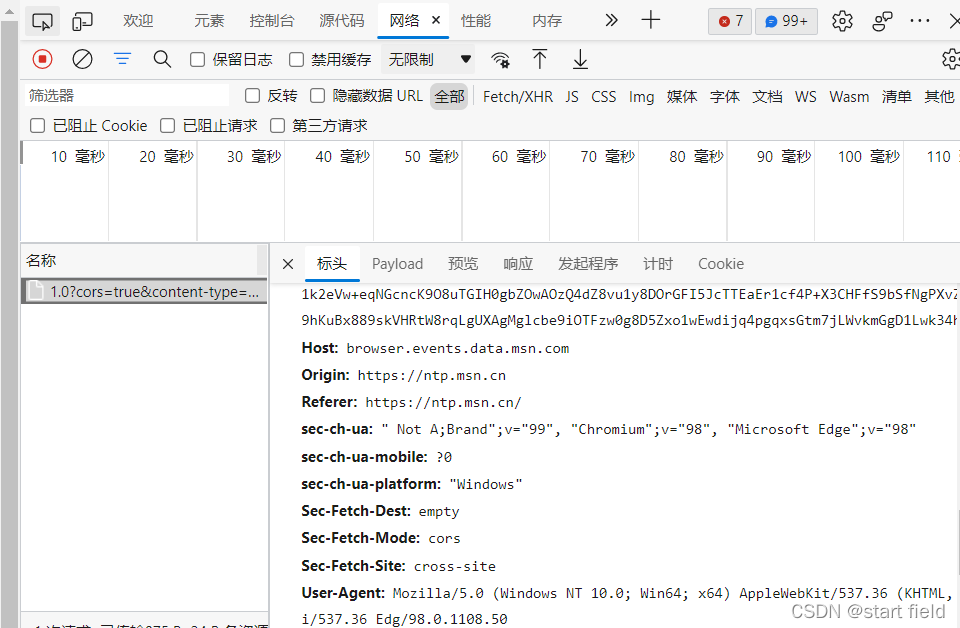

那怎么知道响应内容是不是json类型呢?还是打开开发者工具,选择网络,选择请求的头部找到content-type,就能知道是哪种类型的。

![]()

下面是爬取百度翻译的代码

# -- coding:UTF-8 --

import json

import requests

if __name__ == "__main__":

url = 'https://fanyi.baidu.com/sug'

word = input('enter a word:')

data = {

'kw':word

}

headers = {

"user-agent": "Mozilla / 5.0(Windows NT 10.0;Win64;x64) AppleWebKit / 537.36(KHTML, likeGecko) Chrome / 97.0.4692.71Safari / 537.36Edg / 97.0.1072.55"

}

response = requests.post(url=url,data=data,headers=headers)

dic_obj = response.json()

filename = word+'.json'

with open (filename,'w',encoding='utf-8') as fp:

json.dump(dic_obj,fp=fp,ensure_ascii=False)

print('over')使用json.dump时要导入json库,dump()的作用是将python对象编码成Json字符串。

ensure_ascii:此参数仅采用布尔值。如果未将其设置为true,默认输出ASCLL值,如果把ensure_ascii赋值成False,就可以输出中文。