Docker 网络及资源控制

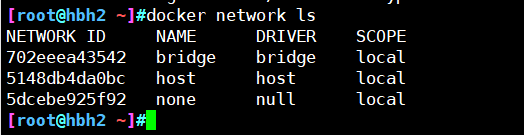

安装Docker时,它会自动创建三个网络,bridge(创建容器默认连接到此网络)、 none 、host

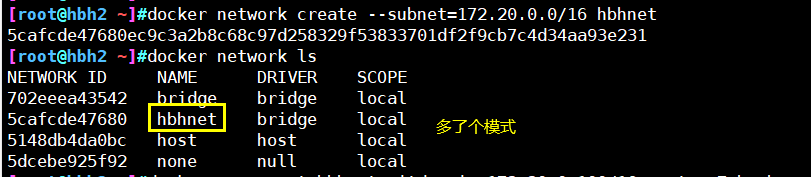

docker network ls #查看docker网络列表

Docker网络实现原理

Docker使用Linux桥接,在宿主机虚拟一个Docker容器网桥(docker0),Docker启动一个容器时会根据Docker网桥的网段分配给容器一个IP地址,称为Container-IP,同时Docker网桥是每个容器的默认网关。因为在同一宿主机内的容器都接入同一个网桥,这样容器之间就能够通过容器的Container-IP 直接通信。

Docker网桥是宿主机虚拟出来的,并不是真实存在的网络设备,外部网络是无法寻址到的,这也意味着外部网络无法直接通过Container-IP 访问到容器。如果容器希望外部访问能够访问到,可以通过映射容器端口到宿主主机(端口映射),即 docker run创建容器时候通过 -p 或 -P 参数来启用,访问容器的时候就通过[宿主机IP]:[容器端口]访问容器

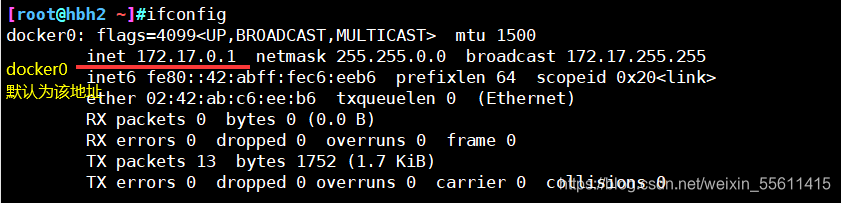

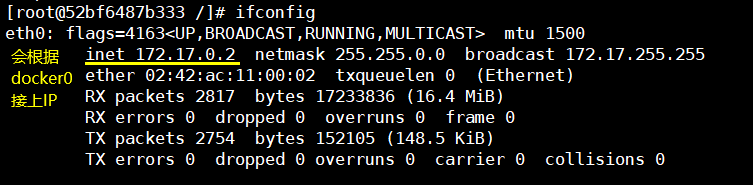

安装docker之后,linux会多了一个docker0的网卡,这是docker虚拟出来的一个网卡,默认为172.17.0.1,在创建其他系统容器时,会根据该网段取IP,用docker0做网关,而外部网络会基于DNAT与内容容器进行通信,若容器没有IP(none模式下),容器之间则通过lo回环网卡进行通信

Docker网络模式

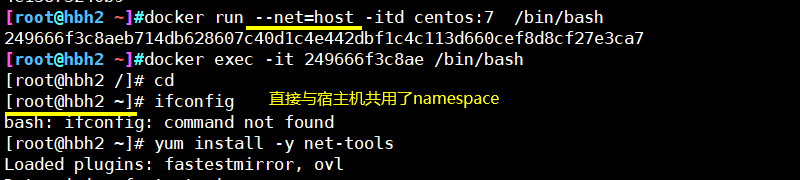

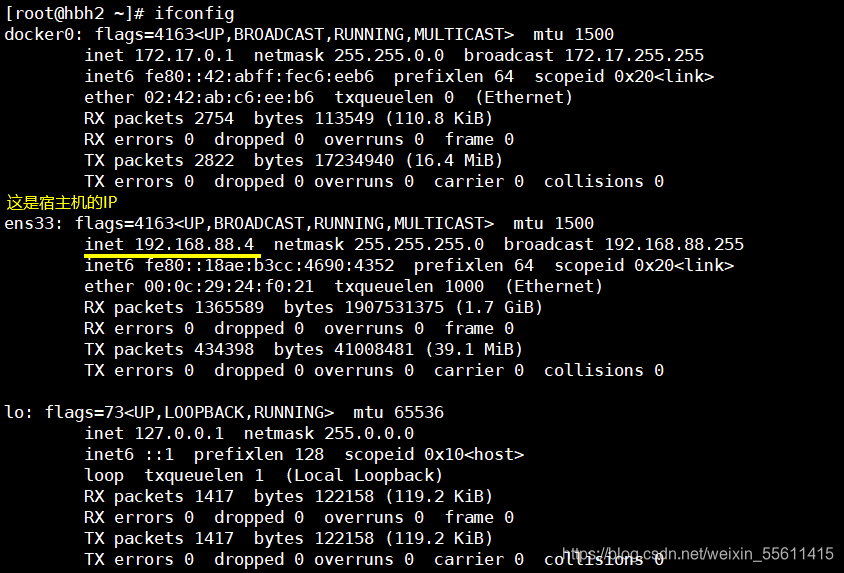

Host:容器将不会虚拟出自己的网卡,配置自己的IP等,而是使用宿主机的IP和端口,使用 --net=host 指定

Container:创建的容器不会创建自己的网卡,配置自己的IP,而是和一个指定的容器共享IP、端口范围,使用 --net=container:NAME_or_ID 指定

None:该模式关闭了容器的网络功能,使用 --net=none 指定

Bridge:默认为该模式,此模式会为每一个容器分配、设置IP等,并将容器连接到一个docker0虚拟网桥,通过docker0网桥以及iptables nat 表配置与宿主机通信

自定义网络

Bridge模式

bridge模式是docker的默认网络模式,不写–net参数,就是bridge模式。

相当于Vmware中的 nat 模式,容器使用独立network Namespace,并连接到docker0虚拟网卡。通过docker0网桥以及iptables nat表配置与宿主机通信,此模式会为每一个容器分配Network Namespace、设置IP等,并将一个主机上的 Docker容器连接到一个虚拟网桥上。

工作模式

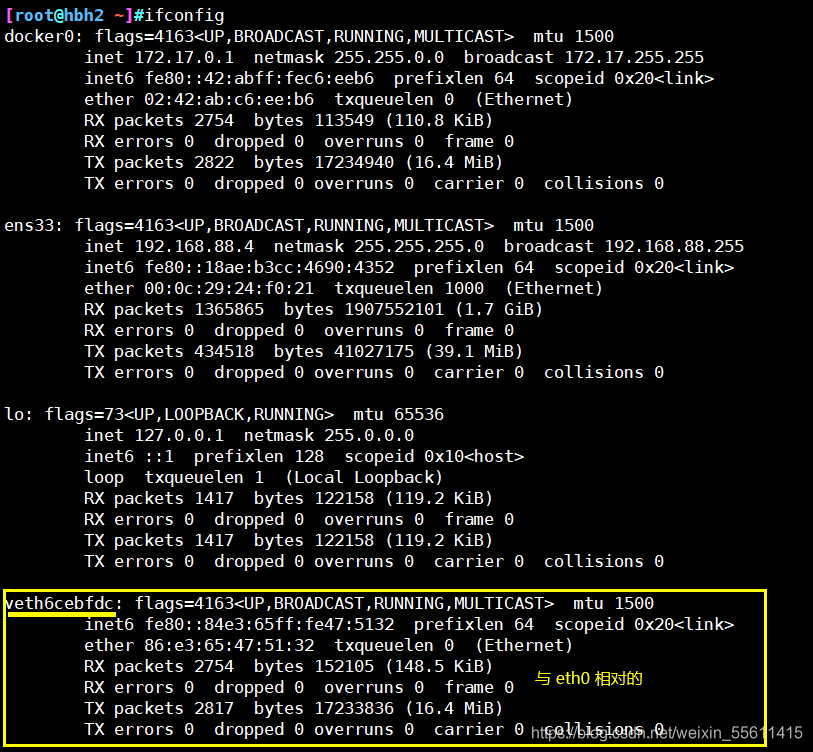

- 当Docker进程启动时,会在主机上创建一个名为docker0的虚拟网桥,此主机上启动的Docker容器会连接到这个虚拟网桥上

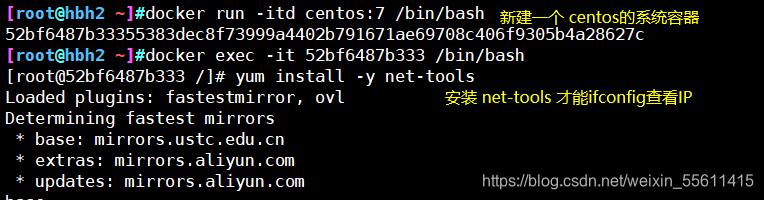

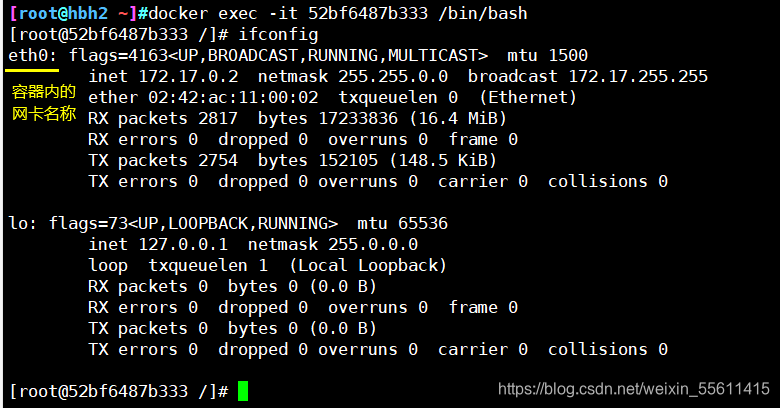

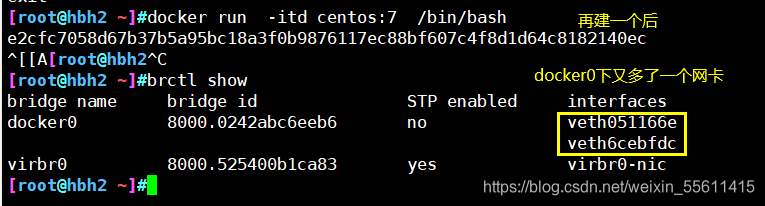

- 从docker0子网中分配一个IP给容器使用,并设置docker0的IP地址为容器的默认网关。在主机上创建一对虚拟网卡veth pair设备。veth设备总是成对出现的,它们组成了一个数据的通道,数据从一个设备进入,就会从另一个设备出来

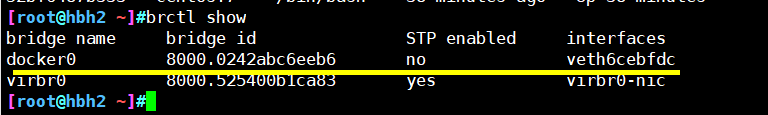

- Docker将veth pair 设备的一端放在新创建的容器中,并命名为eth0(容器的网卡),另一端放在主机中,以veth*这样类似的名字命名,并将这个网络设备加入到docker0网桥中。可以通过 brctl show (查看网桥信息)命令查看。

- 使用 docker run -p 时,docker实际是在iptables做了DNAT规则,实现端口转发功能。可以使用iptables -t nat -vnL 查看

查看网桥信息 现在就只有一个bridge模式的容器

Host模式

相当于Vmware中的桥接模式,与宿主机在同一个网络中,但没有独立IP地址。

Docker使用了Linux的Namespaces技术来进行资源隔离,如PID Namespace隔离进程,Mount Namespace隔离文件系统,Network Namespace隔离网络等。 一个Network Namespace提供了一份独立的网络环境,包括网卡、路由、iptable规则等都与其他的Network Namespace隔离。

一个Docker容器一般会分配一个独立的Network Namespace。

但如果启动容器的时候使用host模式,那么这个容器将不会获得一个独立的Network Namespace,而是和宿主机共用一个Network Namespace。容器将不会虚拟出自己的网卡、配置自己的IP等,而是使用宿主机的IP和端口

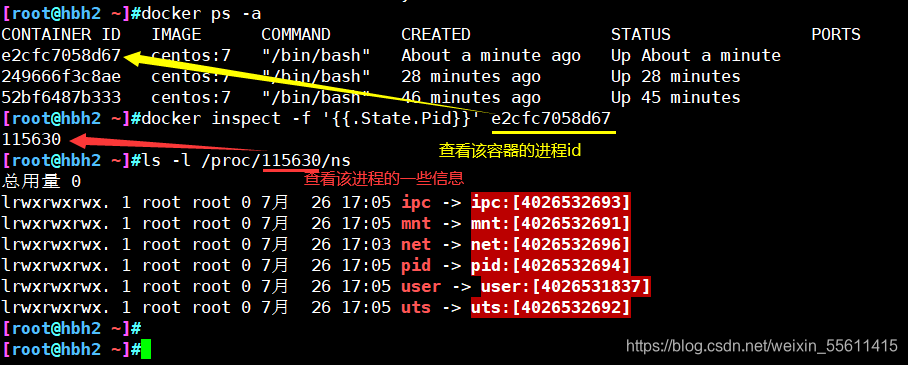

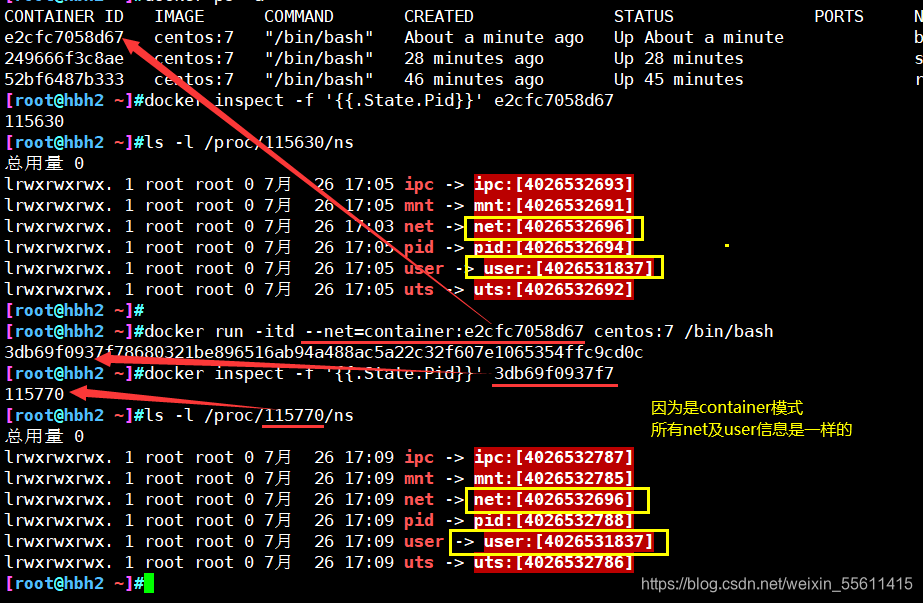

container模式

这个模式指定新创建的容器和已经存在的一个容器共享一个Network Namespace,而不是和宿主机共享。新创建的容器不会创建自己的网卡,配置自己的IP,而是和一个指定的容器共享IP、端口范围等。同样,两个容器除了网络方面,其他的如文件系统、进程列表等还是隔离的。两个容器的进程可以通过lo网卡设备通信

none模式

使用none模式,Docker容器拥有自己的Network Namespace,但是,并不为Docker容器进行任何网络配置

也就是说,这个Docker容器没有网卡、IP、路由等信息。这种网络模式下容器只有lo回环网络,没有其他网卡。这种类型的网络没有办法联网,封闭的网络能很好的保证容器的安全性

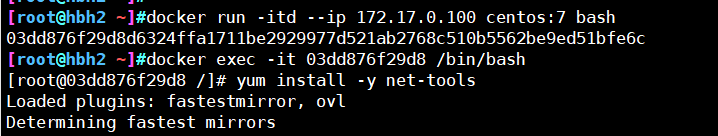

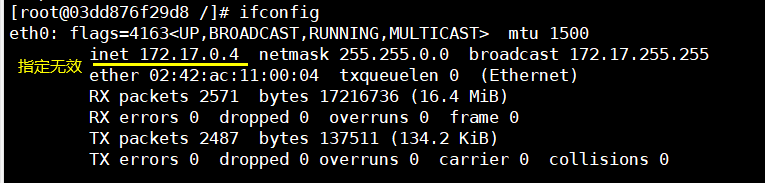

自定义网络

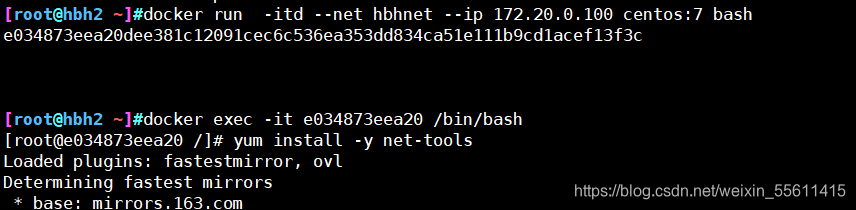

要想为容器自定义一个IP,是无法用 --ip参数 为其指定的。必须先创建一个新的网络模式,指定好网段,才能在创建容器时,指定IP

docker network create --subnet=网段/掩码 自定义模式名

资源控制

CPU 资源控制

cgroups,是一个非常强大的linux内核工具,他不仅可以限制被 namespace 隔离起来的资源,还可以为资源设置权重、计算使用量、操控进程启停等等。 所以 cgroups( Control groups) 实现了对资源的配额和度量

cgroups四大功能:

- 资源限制:可以对任务使用的资源总额进行限制

- 优先级分配:通过分配的cpu时间片数量以及磁盘IO带宽大小,实际上相当于控制了任务运行优先级

- 资源统计:可以统计系统的资源使用量,如cpu时长,内存用量等

- 任务控制:cgroup可以对任务执行挂起、恢复等操作

设置CPU使用率上限

Linux 通过 CFS(Completely Fair Scheduler,完全公平调度器)来调度各个进程对 CPU 的使用

cpu.cfs_period_us:cpu分配的周期(微秒,所以文件名中用 us 表示),默认为100000。

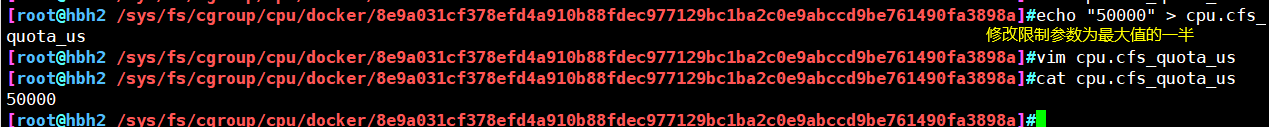

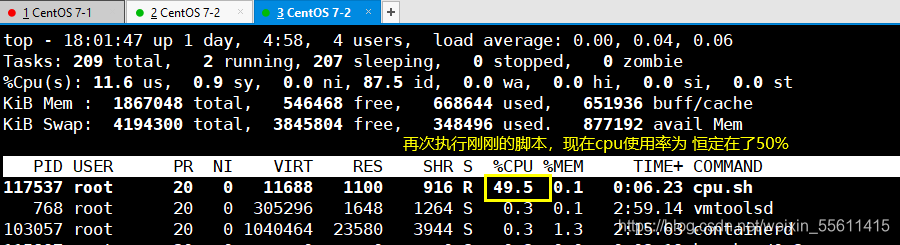

cpu.cfs_quota_us:表示该control group限制占用的时间(微秒),默认为-1,表示不限制。 如果设为50000,表示占用50000/100000=50%的CPU

CFS 周期的有效范围是 1ms~1s,对应的 --cpu-period 的数值范围是 1000~100000。

而容器的 CPU 配额必须不小于 1ms,即 --cpu-quota 的值必须 >= 1000

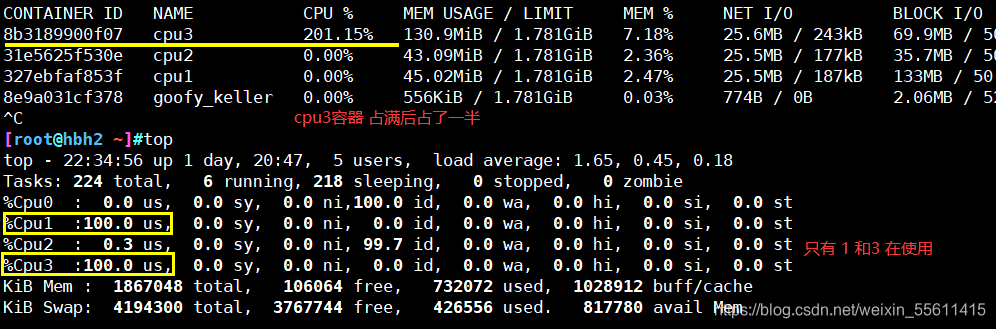

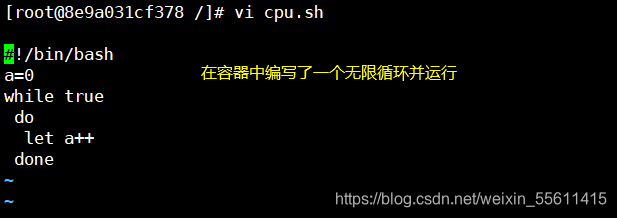

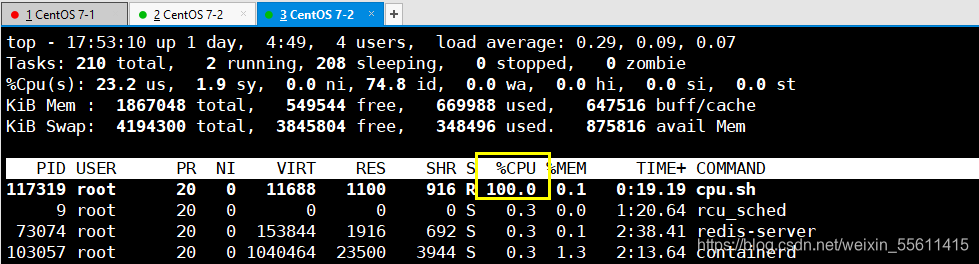

cpu顿时占满了,这会对其他应用造成阻塞,非常不好

修改容器目录下的cpu.cfs_quota_us,

或在创建容器时,直接 --cpu-quota 设置限额

docker run -itd --cpu-quota 50000 centos:7 /bin/bash

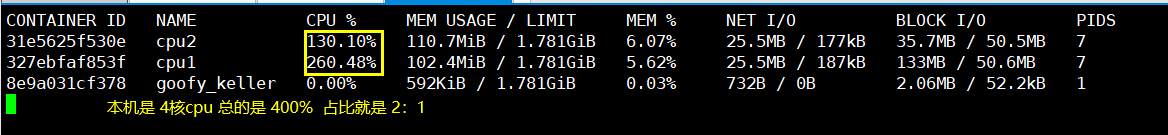

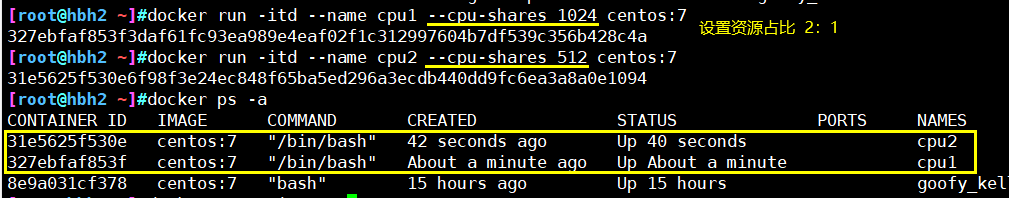

设置CPU资源占比

Docker 通过–cpu-shares 指定 CPU 份额,默认值为1024,值为1024的倍数。

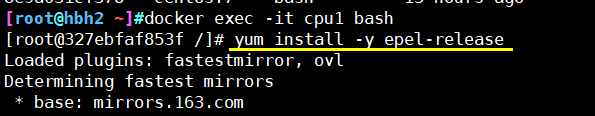

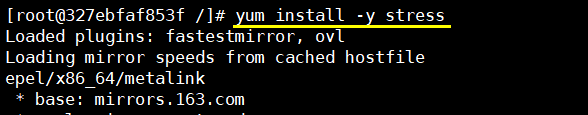

进行压力测试的所需安装的部件

yum install -y epel-release

yum install stress -y

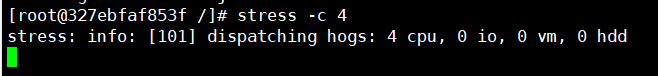

产生四个进程,每个进程都反复不停的计算随机数的平方根

stress -c 4

动态查看容器运行状态

docker stats

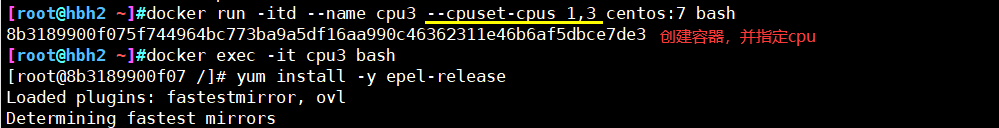

设置容器绑定指定的CPU

- -cpuset-cpus 指定容器运行时,使用的cpu