虚拟机资源分配

主机名 内存 硬盘 网卡

ct 8G 300+300 VM:192.168.184.10

NAT:192.168.220.10

c1 8G 300+300 VM:192.168.184.20

NAT:192.168.220.20

C2 8G 300+300 VM:192.168.184.30

NAT:192.168.220.30 基础环境配置

三台机都修改NAT网卡配置

ct控制节点

vi /etc/sysconfig/network-scripts/ifcfg-ens37

BOOTPROTO=static

ONBOOT=yes

IPADDR=192.168.184.10

NETMASK=255.255.255.0

GATEWAY=192.168.184.1

IPV4_ROUTE_METRIC=90

vi /etc/sysconfig/network-scripts/ifcfg-ens33

BOOTPROTO=static

ONBOOT=yes

IPADDR=192.168.220.10

NETMASK=255.255.255.0

#GATEWAY=192.168.220.1

systemctl restart network

vi /etc/resolv.conf

nameserver 114.114.114.114

systemctl stop firewalld

systemctl disable firewalld

setenforce 0

#永久关闭

vi /etc/sysconfig/selinux

SELINUX=disabled

#设置主机名(以控制节点为例)

hostnamectl set-hostname ct

su -

安装基础环境依赖包

yum -y install net-tools bash-completion vim gcc gcc-c++ make pcre pcre-devel expat-devel cmake bzip2 lrzsz

#EXPAT C语言发开库

yum -y install centos-release-openstack-train python-openstackclient openstack-selinux openstack-utils

#OpenStack 的 train 版本仓库源安装 包,同时安装 OpenStack 客户端和 openstack-selinux 安装包

三台机都做免交互、时间同步和周期性计划任务

vi /etc/hosts

192.168.220.10 ct

192.168.220.20 c1

192.168.220.30 c2

ssh-keygen -t rsa

ssh-copy-id ct

ssh-copy-id c1

ssh-copy-id c2

yum install chrony -y

#时间同步:ct ->同步阿里云时钟服务器,c1、c2 -> 同步ct

#先配置控制节点ct

vi /etc/chrony.conf

server 0.centos.pool.ntp.org iburst #注释掉

server 1.centos.pool.ntp.org iburst #注释掉

server 2.centos.pool.ntp.org iburst #注释掉

server 3.centos.pool.ntp.org iburst #注释掉

server ntp6.aliyun.com iburst #配置阿里云时钟服务器源

allow 192.168.220.0/24 #允许192.168.220.0/24网段的主机来同步时钟服务

#chronyc sources 命令查询时间同步信息

#控制节点c1、c2时间同步配置

vi /etc/chrony.conf

server 0.centos.pool.ntp.org iburst #注释掉

server 1.centos.pool.ntp.org iburst #注释掉

server 2.centos.pool.ntp.org iburst #注释掉

server 3.centos.pool.ntp.org iburst #注释掉

server ct iburst #配置阿里云时钟服务器源

systemctl enable chronyd.service #永久开启时间同步服务器

systemctl restart chronyd.service #重启时间同步服务器

#配置计划任务

crontab -e

*/2 * * * * /usr/bin/chronyc sources >>/var/log/chronyc.log

crontab -l

系统环境配置

安装、配置MariaDB

#配置服务(控制节点):

yum -y install mariadb mariadb-server python2-PyMySQL

#python2-PyMySQL包用于openstack的控制端连接mysql所需要的模块,如果不安装,则无法连接数据库;此包只安装在控制端

yum -y install libibverbs

#添加MySQL子配置文件,增加如下内容

vim /etc/my.cnf.d/openstack.cnf

[mysqld]

bind-address = 192.168.220.10 #控制节点局域网地址

default-storage-engine = innodb #默认存储引擎

innodb_file_per_table = on #每张表独立表空间文件

max_connections = 4096 #最大连接数

collation-server = utf8_general_ci #默认字符集

character-set-server = utf8

#开机自启动、开启服务

systemctl enable mariadb

systemctl start mariadb

#执行MariaDB 安全配置脚本

[root@ct ~]# mysql_secure_installation

Enter current password for root (enter for none): #回车

OK, successfully used password, moving on...

Set root password? [Y/n] Y

Remove anonymous users? [Y/n] Y

... Success!

Disallow root login remotely? [Y/n] N #是否不允许root用户远程登陆

... skipping.

Remove test database and access to it? [Y/n] Y #是否删除test测试库

Reload privilege tables now? [Y/n] Y

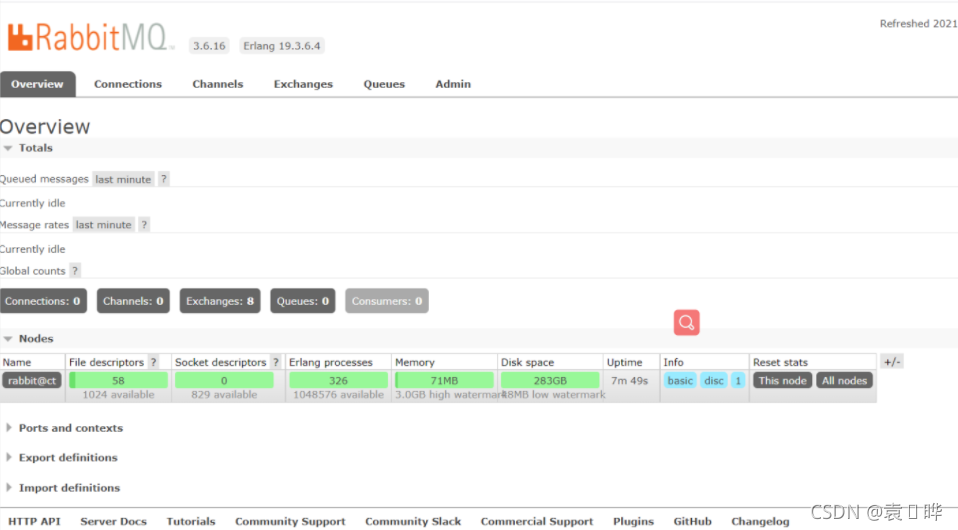

安装RabbitMQ

#所有创建虚拟机的指令,控制端都会发送到rabbitmq,node节点监听rabbitmq

yum -y install rabbitmq-server

#配置服务,启动RabbitMQ服务,并设置其开机启动

systemctl enable rabbitmq-server.service

systemctl start rabbitmq-server.service

#创建消息队列用户,用于controler和 计算节点连接rabbitmq的认证(关联)

rabbitmqctl add_user openstack RABBIT_PASS

#配置openstack用户的操作权限(正则,配置读写权限)

rabbitmqctl set_permissions openstack ".*" ".*" ".*"

#可查看25672和5672 两个端口(5672是Rabbitmq默认端口,25672是Rabbit的测试工具CLI的端口)

#查看rabbitmq插件列表

rabbitmq-plugins list

#开启rabbitmq的web管理界面的插件,端口为15672

rabbitmq-plugins enable rabbitmq_management

#检查端口(25672 5672 15672)

ss -natp | grep 5672

#可访问192.168.184.10:15672

默认账号密码均为guest

?安装memcached

安装memcached是用于存储session信息;服务身份验证机制(keystone)使用Memcached来缓存令牌;在登录openstack的dashboard时,会产生一些session信息,这些session信息会存放到memcached缓存中;session保持会话信息

令牌有效期是半小时

#安装Memcached

yum install -y memcached python-memcached

#python-*模块在OpenStack中起到连接数据库的作用

#修改Memcached配置文件

cat /etc/sysconfig/memcached

PORT="11211"

USER="memcached"

MAXCONN="1024"

CACHESIZE="64"

OPTIONS="-l 127.0.0.1,::1,ct"

systemctl enable memcached

systemctl start memcached

netstat -natp | grep 11211

#安装etcd

yum -y install etcd

#修改etcd配置文件

[root@ct ~]# cd /etc/etcd/

[root@ct etcd]# ls

etcd.conf

[root@ct etcd]# vim etcd.conf

#数据目录位置

#监听其他etcd member的url(2380端口,集群之间通讯,域名为无效值)

#对外提供服务的地址(2379端口,集群内部的通讯端口)

#集群中节点标识(名称)

#该节点成员的URL地址,2380端口:用于集群之间通讯。

ETCD_DATA_DIR="/var/lib/etcd/default.etcd"

ETCD_LISTEN_PEER_URLS="http://192.168.220.10:2380"

ETCD_LISTEN_CLIENT_URLS="http://192.168.220.10:2379"

ETCD_NAME="ct"

ETCD_INITIAL_ADVERTISE_PEER_URLS="http://192.168.220.10:2380"

ETCD_ADVERTISE_CLIENT_URLS="http://192.168.220.10:2379"

ETCD_INITIAL_CLUSTER="ct=http://192.168.220.10:2380"

ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster-01" #集群唯一标识

ETCD_INITIAL_CLUSTER_STATE="new" #初始集群状态,new为静态,若为existing,则表示此ETCD服务将尝试加入已有的集群,若为DNS,则表示此集群将作为被加入的对象

#开机自启动、开启服务,检测端口

systemctl enable etcd.service

systemctl start etcd.service

netstat -antp |grep 2379

netstat -antp |grep 2380