阻塞和非阻塞IO 是Linux 驱动开发里面很常见的两种设备访问模式,在编写驱动的时候一定要考虑到阻塞和非阻塞。本章我们就来学习一下阻塞和非阻塞IO,以及如何在驱动程序中处理阻塞与非阻塞,如何在驱动程序使用等待队列和poll 机制。

阻塞和非阻塞IO

阻塞和非阻塞简介

这里的“IO”并不是我们学习STM32 或者其他单片机的时候所说的“GPIO”(也就是引脚)。这里的IO 指的是Input/Output,也就是输入/输出,是应用程序对驱动设备的输入/输出操作。当应用程序对设备驱动进行操作的时候,如果不能获取到设备资源,那么阻塞式IO 就会将应用程序对应的线程挂起,直到设备资源可以获取为止。对于非阻塞IO,应用程序对应的线程不会挂起,它要么一直轮询等待,直到设备资源可以使用,要么就直接放弃。阻塞式IO 如图52.1.1.1所示:

图52.1.1.1 中应用程序调用read 函数从设备中读取数据,当设备不可用或数据未准备好的时候就会进入到休眠态。等设备可用的时候就会从休眠态唤醒,然后从设备中读取数据返回给应用程序。非阻塞IO 如图52.1.2 所示:

从图52.1.1.2 可以看出,应用程序使用非阻塞访问方式从设备读取数据,当设备不可用或数据未准备好的时候会立即向内核返回一个错误码,表示数据读取失败。应用程序会再次重新读取数据,这样一直往复循环,直到数据读取成功。

应用程序可以使用如下所示示例代码来实现阻塞访问:

1 int fd;

2 int data = 0;

3

4 fd = open("/dev/xxx_dev", O_RDWR); /* 阻塞方式打开*/

5 ret = read(fd, &data, sizeof(data)); /* 读取数据*/

从示例代码52.1.1.1 可以看出,对于设备驱动文件的默认读取方式就是阻塞式的,所以我们前面所有的例程测试APP 都是采用阻塞IO。

如果应用程序要采用非阻塞的方式来访问驱动设备文件,可以使用如下所示代码:

1 int fd;

2 int data = 0;

3

4 fd = open("/dev/xxx_dev", O_RDWR | O_NONBLOCK); /* 非阻塞方式打开*/

5 ret = read(fd, &data, sizeof(data)); /* 读取数据*/

第4 行使用open 函数打开“/dev/xxx_dev”设备文件的时候添加了参数“O_NONBLOCK”,表示以非阻塞方式打开设备,这样从设备中读取数据的时候就是非阻塞方式的了。

等待队列

1、等待队列头

阻塞访问最大的好处就是当设备文件不可操作的时候进程可以进入休眠态,这样可以将CPU 资源让出来。但是,当设备文件可以操作的时候就必须唤醒进程,一般在中断函数里面完成唤醒工作。Linux 内核提供了等待队列(wait queue)来实现阻塞进程的唤醒工作,如果我们要在驱动中使用等待队列,必须创建并初始化一个等待队列头,等待队列头使用结构体

wait_queue_head_t 表示,wait_queue_head_t 结构体定义在文件include/linux/wait.h 中,结构体内容如下所示:

39 struct __wait_queue_head {

40 spinlock_t lock;

41 struct list_head task_list;

42 };

43 typedef struct __wait_queue_head wait_queue_head_t;

定义好等待队列头以后需要初始化,使用init_waitqueue_head 函数初始化等待队列头,函数原型如下:

void init_waitqueue_head(wait_queue_head_t *q)

参数q 就是要初始化的等待队列头。

也可以使用宏DECLARE_WAIT_QUEUE_HEAD 来一次性完成等待队列头的定义的初始化。

2、等待队列项

等待队列头就是一个等待队列的头部,每个访问设备的进程都是一个队列项,当设备不可用的时候就要将这些进程对应的等待队列项添加到等待队列里面。结构体wait_queue_t 表示等待队列项,结构体内容如下:

struct __wait_queue {

unsigned int flags;

void *private;

wait_queue_func_t func;

struct list_head task_list;

};

typedef struct __wait_queue wait_queue_t;

使用宏DECLARE_WAITQUEUE 定义并初始化一个等待队列项,宏的内容如下:

DECLARE_WAITQUEUE(name, tsk)

name 就是等待队列项的名字,tsk 表示这个等待队列项属于哪个任务(进程),一般设置为current ,在Linux 内核中current 相当于一个全局变量,表示当前进程。因此宏DECLARE_WAITQUEUE 就是给当前正在运行的进程创建并初始化了一个等待队列项。

3、将队列项添加/移除等待队列头

当设备不可访问的时候就需要将进程对应的等待队列项添加到前面创建的等待队列头中,只有添加到等待队列头中以后进程才能进入休眠态。当设备可以访问以后再将进程对应的等待队列项从等待队列头中移除即可,等待队列项添加API 函数如下:

void add_wait_queue(wait_queue_head_t *q,

wait_queue_t *wait)

函数参数和返回值含义如下:

q:等待队列项要加入的等待队列头。

wait:要加入的等待队列项。

返回值:无。

等待队列项移除API 函数如下:

void remove_wait_queue(wait_queue_head_t *q,

wait_queue_t *wait)

函数参数和返回值含义如下:

q:要删除的等待队列项所处的等待队列头。

wait:要删除的等待队列项。

返回值:无。

4、等待唤醒

当设备可以使用的时候就要唤醒进入休眠态的进程,唤醒可以使用如下两个函数:

void wake_up(wait_queue_head_t *q)

void wake_up_interruptible(wait_queue_head_t *q)

参数q 就是要唤醒的等待队列头,这两个函数会将这个等待队列头中的所有进程都唤醒。

wake_up 函数可以唤醒处于TASK_INTERRUPTIBLE 和TASK_UNINTERRUPTIBLE 状态的进程,而wake_up_interruptible 函数只能唤醒处于TASK_INTERRUPTIBLE 状态的进程。

5、等待事件

除了主动唤醒以外,也可以设置等待队列等待某个事件,当这个事件满足以后就自动唤醒等待队列中的进程,和等待事件有关的API 函数如表52.1.2.1 所示:

| 函数 | 描述 |

|---|---|

| wait_event(wq, condition) | 等待以wq 为等待队列头的等待队列被唤醒,前提是condition 条件必须满足(为真),否则一直阻塞。此函数会将进程设置为TASK_UNINTERRUPTIBLE 状态 |

| wait_event_timeout(wq, condition, timeout) | 功能和wait_event 类似,但是此函数可以添加超时时间,以jiffies 为单位。此函数有返回值,如果返回0 的话表示超时时间到,而且condition为假。为1 的话表示condition 为真,也就是条件满足了。 |

| wait_event_interruptible(wq, condition) | 与wait_event 函数类似,但是此函数将进程设置为TASK_INTERRUPTIBLE,就是可以被信号打断。 |

| wait_event_interruptible_timeout(wq, condition, timeout) | 与wait_event_timeout 函数类似,此函数也将进程设置为TASK_INTERRUPTIBLE,可以被信号打断。 |

轮询

如果用户应用程序以非阻塞的方式访问设备,设备驱动程序就要提供非阻塞的处理方式,也就是轮询。poll、epoll 和select 可以用于处理轮询,应用程序通过select、epoll 或poll 函数来查询设备是否可以操作,如果可以操作的话就从设备读取或者向设备写入数据。当应用程序调用select、epoll 或poll 函数的时候设备驱动程序中的poll 函数就会执行,因此需要在设备驱动程序中编写poll 函数。我们先来看一下应用程序中使用的select、poll 和epoll 这三个函数。

1、select 函数

select 函数原型如下:

int select(int nfds,

fd_set *readfds,

fd_set *writefds,

fd_set *exceptfds,

struct timeval *timeout)

函数参数和返回值含义如下:

nfds:所要监视的这三类文件描述集合中,最大文件描述符加1。

readfds、writefds 和exceptfds:这三个指针指向描述符集合,这三个参数指明了关心哪些描述符、需要满足哪些条件等等,这三个参数都是fd_set 类型的,fd_set 类型变量的每一个位都代表了一个文件描述符。readfds 用于监视指定描述符集的读变化,也就是监视这些文件是否可以读取,只要这些集合里面有一个文件可以读取那么seclect 就会返回一个大于0 的值表示文件可以读取。如果没有文件可以读取,那么就会根据timeout 参数来判断是否超时。可以将readfs设置为NULL,表示不关心任何文件的读变化。writefds 和readfs 类似,只是writefs 用于监视这些文件是否可以进行写操作。exceptfds 用于监视这些文件的异常。

比如我们现在要从一个设备文件中读取数据,那么就可以定义一个fd_set 变量,这个变量要传递给参数readfds。当我们定义好一个fd_set 变量以后可以使用如下所示几个宏进行操作:

void FD_ZERO(fd_set *set)

void FD_SET(int fd, fd_set *set)

void FD_CLR(int fd, fd_set *set)

int FD_ISSET(int fd, fd_set *set)

FD_ZERO 用于将fd_set 变量的所有位都清零,FD_SET 用于将fd_set 变量的某个位置1,也就是向fd_set 添加一个文件描述符,参数fd 就是要加入的文件描述符。FD_CLR 用于将fd_set变量的某个位清零,也就是将一个文件描述符从fd_set 中删除,参数fd 就是要删除的文件描述

符。FD_ISSET 用于测试一个文件是否属于某个集合,参数fd 就是要判断的文件描述符。

timeout:超时时间,当我们调用select 函数等待某些文件描述符可以设置超时时间,超时时间使用结构体timeval 表示,结构体定义如下所示:

struct timeval {

long tv_sec; /* 秒*/

long tv_usec; /* 微妙*/

};

当timeout 为NULL 的时候就表示无限期的等待。

返回值:0,表示的话就表示超时发生,但是没有任何文件描述符可以进行操作;-1,发生错误;其他值,可以进行操作的文件描述符个数。

使用select 函数对某个设备驱动文件进行读非阻塞访问的操作示例如下所示:

1 void main(void)

2 {

3 int ret, fd; /* 要监视的文件描述符*/

4 fd_set readfds; /* 读操作文件描述符集*/

5 struct timeval timeout; /* 超时结构体*/

6

7 fd = open("dev_xxx", O_RDWR | O_NONBLOCK); /* 非阻塞式访问*/

8

9 FD_ZERO(&readfds); /* 清除readfds */

10 FD_SET(fd, &readfds); /* 将fd添加到readfds里面*/

11

12 /* 构造超时时间*/

13 timeout.tv_sec = 0;

14 timeout.tv_usec = 500000; /* 500ms */

15

16 ret = select(fd + 1, &readfds, NULL, NULL, &timeout);

17 switch (ret) {

18 case 0: /* 超时*/

19 printf("timeout!\r\n");

20 break;

21 case -1: /* 错误*/

22 printf("error!\r\n");

23 break;

24 default: /* 可以读取数据*/

25 if(FD_ISSET(fd, &readfds)) { /* 判断是否为fd文件描述符*/

26 /* 使用read函数读取数据*/

27 }

28 break;

29 }

30 }

2、poll 函数

在单个线程中,select 函数能够监视的文件描述符数量有最大的限制,一般为1024,可以修改内核将监视的文件描述符数量改大,但是这样会降低效率!这个时候就可以使用poll 函数,poll 函数本质上和select 没有太大的差别,但是poll 函数没有最大文件描述符限制,Linux 应用程序中poll 函数原型如下所示:

int poll(struct pollfd *fds,

nfds_t nfds,

int timeout)

函数参数和返回值含义如下:

fds:要监视的文件描述符集合以及要监视的事件,为一个数组,数组元素都是结构体pollfd类型的,pollfd 结构体如下所示:

struct pollfd {

int fd; /* 文件描述符*/

short events; /* 请求的事件*/

short revents; /* 返回的事件*/

};

fd 是要监视的文件描述符,如果fd 无效的话那么events 监视事件也就无效,并且revents返回0。events 是要监视的事件,可监视的事件类型如下所示:

POLLIN 有数据可以读取。

POLLPRI 有紧急的数据需要读取。

POLLOUT 可以写数据。

POLLERR 指定的文件描述符发生错误。

POLLHUP 指定的文件描述符挂起。

POLLNVAL 无效的请求。

POLLRDNORM 等同于POLLIN

revents 是返回参数,也就是返回的事件,由Linux 内核设置具体的返回事件。

nfds:poll 函数要监视的文件描述符数量。

timeout:超时时间,单位为ms。

返回值:返回revents 域中不为0 的pollfd 结构体个数,也就是发生事件或错误的文件描述符数量;0,超时;-1,发生错误,并且设置errno 为错误类型。

使用poll 函数对某个设备驱动文件进行读非阻塞访问的操作示例如下所示:

1 void main(void)

2 {

3 int ret;

4 int fd; /* 要监视的文件描述符*/

5 struct pollfd fds;

6

7 fd = open(filename, O_RDWR | O_NONBLOCK); /* 非阻塞式访问*/

8

9 /* 构造结构体*/

10 fds.fd = fd;

11 fds.events = POLLIN; /* 监视数据是否可以读取*/

12

13 ret = poll(&fds, 1, 500); /* 轮询文件是否可操作,超时500ms */

14 if (ret) { /* 数据有效*/

15 ......

16 /* 读取数据*/

17 ......

18 } else if (ret == 0) { /* 超时*/

19 ......

20 } else if (ret < 0) { /* 错误*/

21 ......

22 }

23 }

3、epoll 函数

传统的selcet 和poll 函数都会随着所监听的fd 数量的增加,出现效率低下的问题,而且poll 函数每次必须遍历所有的描述符来检查就绪的描述符,这个过程很浪费时间。为此,epoll应运而生,epoll 就是为处理大并发而准备的,一般常常在网络编程中使用epoll 函数。应用程序需要先使用epoll_create 函数创建一个epoll 句柄,epoll_create 函数原型如下:

int epoll_create(int size)

函数参数和返回值含义如下:

size:从Linux2.6.8 开始此参数已经没有意义了,随便填写一个大于0 的值就可以。

返回值:epoll 句柄,如果为-1 的话表示创建失败。

epoll 句柄创建成功以后使用epoll_ctl 函数向其中添加要监视的文件描述符以及监视的事件,epoll_ctl 函数原型如下所示:

int epoll_ctl(int epfd,

int op,

int fd,

struct epoll_event *event)

函数参数和返回值含义如下:

epfd:要操作的epoll 句柄,也就是使用epoll_create 函数创建的epoll 句柄。

op:表示要对epfd(epoll 句柄)进行的操作,可以设置为:

EPOLL_CTL_ADD 向epfd 添加文件参数fd 表示的描述符。

EPOLL_CTL_MOD 修改参数fd 的event 事件。

EPOLL_CTL_DEL 从epfd 中删除fd 描述符。

fd:要监视的文件描述符。

event:要监视的事件类型,为epoll_event 结构体类型指针,epoll_event 结构体类型如下所示:

struct epoll_event {

uint32_t events; /* epoll 事件*/

epoll_data_t data; /* 用户数据*/

};

结构体epoll_event 的events 成员变量表示要监视的事件,可选的事件如下所示:

EPOLLIN 有数据可以读取。

EPOLLOUT 可以写数据。

EPOLLPRI 有紧急的数据需要读取。

EPOLLERR 指定的文件描述符发生错误。

EPOLLHUP 指定的文件描述符挂起。

EPOLLET 设置epoll 为边沿触发,默认触发模式为水平触发。

EPOLLONESHOT 一次性的监视,当监视完成以后还需要再次监视某个fd,那么就需要将

fd 重新添加到epoll 里面。

上面这些事件可以进行“或”操作,也就是说可以设置监视多个事件。

返回值:0,成功;-1,失败,并且设置errno 的值为相应的错误码。

一切都设置好以后应用程序就可以通过epoll_wait 函数来等待事件的发生,类似select 函数。epoll_wait 函数原型如下所示:

int epoll_wait(int epfd,

struct epoll_event *events,

int maxevents,

int timeout)

函数参数和返回值含义如下:

epfd:要等待的epoll。

events:指向epoll_event 结构体的数组,当有事件发生的时候Linux 内核会填写events,调用者可以根据events 判断发生了哪些事件。

maxevents:events 数组大小,必须大于0。

timeout:超时时间,单位为ms。

返回值:0,超时;-1,错误;其他值,准备就绪的文件描述符数量。

epoll 更多的是用在大规模的并发服务器上,因为在这种场合下select 和poll 并不适合。当设计到的文件描述符(fd)比较少的时候就适合用selcet 和poll,本章我们就使用sellect 和poll 这两个函数。

Linux 驱动下的poll 操作函数

当应用程序调用select 或poll 函数来对驱动程序进行非阻塞访问的时候,驱动程序file_operations 操作集中的poll 函数就会执行。所以驱动程序的编写者需要提供对应的poll 函数,poll 函数原型如下所示:

unsigned int (*poll) (struct file *filp, struct poll_table_struct *wait)

函数参数和返回值含义如下:

filp:要打开的设备文件(文件描述符)。

wait:结构体poll_table_struct 类型指针,由应用程序传递进来的。一般将此参数传递给poll_wait 函数。

返回值:向应用程序返回设备或者资源状态,可以返回的资源状态如下:

POLLIN 有数据可以读取。

POLLPRI 有紧急的数据需要读取。

POLLOUT 可以写数据。

POLLERR 指定的文件描述符发生错误。

POLLHUP 指定的文件描述符挂起。

POLLNVAL 无效的请求。

POLLRDNORM 等同于POLLIN,普通数据可读

我们需要在驱动程序的poll 函数中调用poll_wait 函数,poll_wait 函数不会引起阻塞,只是将应用程序添加到poll_table 中,poll_wait 函数原型如下:

void poll_wait(struct file * filp, wait_queue_head_t * wait_address, poll_table *p)

参数wait_address 是要添加到poll_table 中的等待队列头,参数p 就是poll_table,就是file_operations 中poll 函数的wait 参数。

阻塞IO 实验

在上一章Linux 中断实验中,我们直接在应用程序中通过read 函数不断的读取按键状态,当按键有效的时候就打印出按键值。这种方法有个缺点,那就是imx6uirqApp 这个测试应用程序拥有很高的CPU 占用率,大家可以在开发板中加载上一章的驱动程序模块imx6uirq.ko,然后以后台运行模式打开imx6uirqApp 这个测试软件,命令如下:

./imx6uirqApp /dev/imx6uirq &

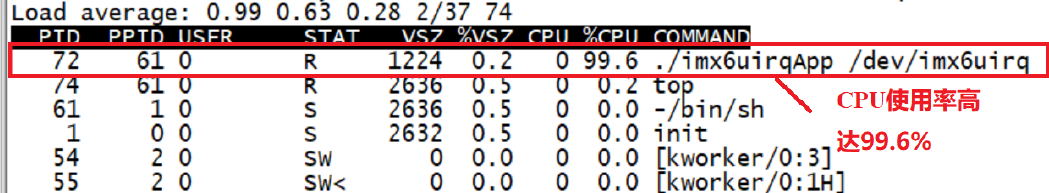

测试驱动是否正常工作,如果驱动工作正常的话输入“top”命令查看imx6uirqApp 这个应用程序的CPU 使用率,结果如图52.2.1 所示:

从图52.2.1 可以看出,imx6uirqApp 这个应用程序的CPU 使用率竟然高达99.6%,这仅仅是一个读取按键值的应用程序,这么高的CPU 使用率显然是有问题的!原因就在于我们是直接在while 循环中通过read 函数读取按键值,因此imx6uirqApp 这个软件会一直运行,一直读取按键值,CPU 使用率肯定就会很高。最好的方法就是在没有有效的按键事件发生的时候,

imx6uirqApp 这个应用程序应该处于休眠状态,当有按键事件发生以后imx6uirqApp 这个应用程序才运行,打印出按键值,这样就会降低CPU 使用率,本小节我们就使用阻塞IO 来实现此功能。

硬件原理图分析

本章实验硬件原理图参考15.2 小节即可。

实验程序编写

1、驱动程序编写

本实验对应的例程路径为:开发板光盘-> 2、Linux 驱动例程-> 14_blockio。

本章实验我们在上一章的“13_irq”实验的基础上完成,主要是对其添加阻塞访问相关的代码。新建名为“14_blockio”的文件夹,然后在14_blockio 文件夹里面创建vscode 工程,工作区命名为“blockio”。将“13_irq”实验中的imx6uirq.c 复制到14_blockio 文件夹中,并重命名为blockio.c。接下来我们就修改blockio.c 这个文件,在其中添加阻塞相关的代码,完成以后的

blockio.c 内容如下所示(因为是在上一章实验的imx6uirq.c 文件的基础上修改的,为了减少篇幅,下面的代码有省略):

1 #include <linux/types.h>

2 #include <linux/kernel.h>

......

18 #include <asm/mach/map.h>

19 #include <asm/uaccess.h>

20 #include <asm/io.h>

21 /***************************************************************

22 Copyright ? ALIENTEK Co., Ltd. 1998-2029. All rights reserved.

23 文件名: block.c

24 作者: 左忠凯

25 版本: V1.0

26 描述: 阻塞IO访问

27 其他: 无

28 论坛: www.openedv.com

29 日志: 初版V1.0 2019/7/26 左忠凯创建

30 ***************************************************************/

31 #define IMX6UIRQ_CNT 1 /* 设备号个数*/

32 #define IMX6UIRQ_NAME "blockio" /* 名字*/

33 #define KEY0VALUE 0X01 /* KEY0按键值*/

34 #define INVAKEY 0XFF /* 无效的按键值*/

35 #define KEY_NUM 1 /* 按键数量*/

36

37 /* 中断IO描述结构体*/

38 struct irq_keydesc {

39 int gpio; /* gpio */

40 int irqnum; /* 中断号*/

41 unsigned char value; /* 按键对应的键值*/

42 char name[10]; /* 名字*/

43 irqreturn_t (*handler)(int, void *); /* 中断服务函数*/

44 };

45

46 /* imx6uirq设备结构体*/

47 struct imx6uirq_dev{

48 dev_t devid; /* 设备号*/

49 struct cdev cdev; /* cdev */

50 struct class *class; /* 类*/

51 struct device *device; /* 设备*/

52 int major; /* 主设备号*/

53 int minor; /* 次设备号*/

54 struct device_node *nd; /* 设备节点*/

55 atomic_t keyvalue; /* 有效的按键键值*/

56 atomic_t releasekey; /* 标记是否完成一次完成的按键*/

57 struct timer_list timer; /* 定义一个定时器*/

第32 行,修改设备文件名字为“blockio”,当驱动程序加载成功以后就会在根文件系统中出现一个名为“/dev/blockio”的文件。

第61 行,在设备结构体中添加一个等待队列头r_wait,因为在Linux 驱动中处理阻塞IO需要用到等待队列。

第107~110 行,定时器中断处理函数执行,表示有按键按下,先在107 行判断一下是否是一次有效的按键,如果是的话就通过wake_up 或者wake_up_interruptible 函数来唤醒等待队列r_wait。

第168 行,调用init_waitqueue_head 函数初始化等待队列头r_wait。

第200~206 行,采用等待事件来处理read 的阻塞访问,wait_event_interruptible 函数等待releasekey 有效,也就是有按键按下。如果按键没有按下的话进程就会进入休眠状态,因为采用了wait_event_interruptible 函数,因此进入休眠态的进程可以被信号打断。

第208~218 行,首先使用DECLARE_WAITQUEUE 宏定义一个等待队列,如果没有按键按下的话就使用add_wait_queue 函数将当前任务的等待队列添加到等待队列头r_wait 中。随后调用__set_current_state 函数设置当前进程的状态为TASK_INTERRUPTIBLE,也就是可以被信号打断。接下来调用schedule 函数进行一次任务切换,当前进程就会进入到休眠态。如果有按

键按下,那么进入休眠态的进程就会唤醒,然后接着从休眠点开始运行。在这里也就是从第213行开始运行,首先通过signal_pending 函数判断一下进程是不是由信号唤醒的,如果是由信号唤醒的话就直接返回-ERESTARTSYS 这个错误码。如果不是由信号唤醒的(也就是被按键唤醒的)那么就在217 行调用__set_current_state 函数将任务状态设置为TASK_RUNNING,然后在

218 行调用remove_wait_queue 函数将进程从等待队列中删除。

使用等待队列实现阻塞访问重点注意两点:

①、将任务或者进程加入到等待队列头,

②、在合适的点唤醒等待队列,一般都是中断处理函数里面。

2、编写测试APP

本节实验的测试APP 直接使用第51.3.3 小节所编写的imx6uirqApp.c,将imx6uirqApp.c 复制到本节实验文件夹下,并且重命名为blockioApp.c,不需要修改任何内容。

运行测试

1、编译驱动程序和测试APP

①、编译驱动程序

编写Makefile 文件,本章实验的Makefile 文件和第四十章实验基本一样,只是将obj-m 变量的值改为blockio.o,Makefile 内容如下所示:

1 KERNELDIR := /home/zuozhongkai/linux/IMX6ULL/linux/temp/linux-imx-rel_imx_4.1.15_2.1.0_ga_alientek

......

4 obj-m := blockio.o

......

11 clean:

12 $(MAKE) -C $(KERNELDIR) M=$(CURRENT_PATH) clean

第4 行,设置obj-m 变量的值为blockio.o。

输入如下命令编译出驱动模块文件:

make -j32

编译成功以后就会生成一个名为“blockio.ko”的驱动模块文件。

②、编译测试APP

输入如下命令编译测试noblockioApp.c 这个测试程序:

arm-linux-gnueabihf-gcc blockioApp.c -o blockioApp

编译成功以后就会生成blcokioApp 这个应用程序。

2、运行测试

将上一小节编译出来blockio.ko 和blockioApp 这两个文件拷贝到rootfs/lib/modules/4.1.15目录中,重启开发板,进入到目录lib/modules/4.1.15 中,输入如下命令加载blockio.ko 驱动模块:

depmod //第一次加载驱动的时候需要运行此命令

modprobe blockio.ko //加载驱动

驱动加载成功以后使用如下命令打开blockioApp 这个测试APP,并且以后台模式运行:

./blockioApp /dev/blockio &

按下开发板上的KEY0 按键,结果如图52.2.3.1 所示:

当按下KEY0 按键以后blockioApp 这个测试APP 就会打印出按键值。输入“top”命令,查看blockioAPP 这个应用APP 的CPU 使用率,如图52.2.3.2 所示:

从图52.2.3.2 可以看出,当我们在按键驱动程序里面加入阻塞访问以后,blockioApp 这个应用程序的CPU 使用率从图52.2.1 中的99.6%降低到了0.0%。大家注意,这里的0.0%并不是说blockioApp 这个应用程序不使用CPU 了,只是因为使用率太小了,CPU 使用率可能为0.00001%,但是图52.2.3.2 只能显示出小数点后一位,因此就显示成了0.0%。

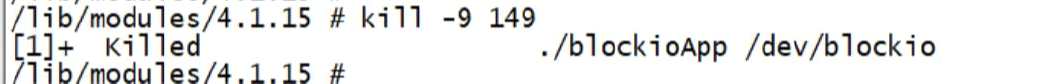

我们可以使用“kill”命令关闭后台运行的应用程序,比如我们关闭掉blockioApp 这个后台运行的应用程序。首先输出“Ctrl+C”关闭top 命令界面,进入到命令行模式。然后使用“ps”命令查看一下blockioApp 这个应用程序的PID,如图52.2.3.3 所示:

从图图52.2.3.3 可以看出,blockioApp 这个应用程序的PID 为149,使用“kill -9 PID”即可“杀死”指定PID 的进程,比如我们现在要“杀死”PID 为149 的blockioApp 应用程序,可是使用如下命令:

kill -9 149

输入上述命令以后终端显示如图52.2.3.4 所示:

从图52.2.3.4 可以看出,“./blockioApp /dev/blockio”这个应用程序已经被“杀掉”了,在此输入“ps”命令查看当前系统运行的进程,会发现blockioApp 已经不见了。这个就是使用kill命令“杀掉”指定进程的方法。

非阻塞IO 实验

硬件原理图分析

本章实验硬件原理图参考15.2 小节即可。

实验程序编写

1、驱动程序编写

本实验对应的例程路径为:开发板光盘-> 2、Linux 驱动例程-> 15_noblockio。

本章实验我们在52.2 小节中的“14_blockio”实验的基础上完成,上一小节实验我们已经在驱动中添加了阻塞IO 的代码,本小节我们继续完善驱动,加入非阻塞IO 驱动代码。新建名为“15_noblockio”的文件夹,然后在15_noblockio 文件夹里面创建vscode 工程,工作区命名为“noblockio”。将“14_blockio”实验中的blockio.c 复制到15_noblockio 文件夹中,并重命名为noblockio.c。接下来我们就修改noblockio.c 这个文件,在其中添加非阻塞相关的代码,完成

以后的noblockio.c 内容如下所示(因为是在上一小节实验的blockio.c 文件的基础上修改的,为了减少篇幅,下面的代码有省略):

1 #include <linux/types.h>

2 #include <linux/kernel.h>

......

18 #include <linux/wait.h>

19 #include <linux/poll.h>

20 #include <asm/mach/map.h>

21 #include <asm/uaccess.h>

22 #include <asm/io.h>

23 /***************************************************************

24 Copyright ? ALIENTEK Co., Ltd. 1998-2029. All rights reserved.

25 文件名: noblock.c

26 作者: 左忠凯

27 版本: V1.0

28 描述: 非阻塞IO访问

29 其他: 无

30 论坛: www.openedv.com

31 日志: 初版V1.0 2019/7/26 左忠凯创建

32 ***************************************************************/

31 #define IMX6UIRQ_CNT 1 /* 设备号个数*/

32 #define IMX6UIRQ_NAME "noblockio" /* 名字*/

......

187 /*

188 * @description : 从设备读取数据

189 * @param - filp : 要打开的设备文件(文件描述符)

190 * @param - buf : 返回给用户空间的数据缓冲区

191 * @param - cnt : 要读取的数据长度

192 * @param - offt : 相对于文件首地址的偏移

193 * @return : 读取的字节数,如果为负值,表示读取失败

194 */

195 static ssize_t imx6uirq_read(struct file *filp, char __user *buf,

size_t cnt, loff_t *offt)

第32 行,修改设备文件名字为“noblockio”,当驱动程序加载成功以后就会在根文件系统中出现一个名为“/dev/noblockio”的文件。

第202~204 行,判断是否为非阻塞式读取访问,如果是的话就判断按键是否有效,也就是判断一下有没有按键按下,如果没有的话就返回-EAGAIN。

第241~ 252 行,imx6uirq_poll 函数就是file_operations 驱动操作集中的poll 函数,当应用程序调用select 或者poll 函数的时候imx6uirq_poll 函数就会执行。第246 行调用poll_wait 函数将等待队列头添加到poll_table 中,第

248~250 行判断按键是否有效,如果按键有效的话就向应用程序返回POLLIN 这个事件,表示有数据可以读取。

第259 行,设置file_operations 的poll 成员变量为imx6uirq_poll。

2、编写测试APP

新建名为noblockioApp.c 测试APP 文件,然后在其中输入如下所示内容:

1 #include "stdio.h"

2 #include "unistd.h"

3 #include "sys/types.h"

4 #include "sys/stat.h"

5 #include "fcntl.h"

6 #include "stdlib.h"

7 #include "string.h"

8 #include "poll.h"

9 #include "sys/select.h"

10 #include "sys/time.h"

11 #include "linux/ioctl.h"

12 /***************************************************************

13 Copyright ? ALIENTEK Co., Ltd. 1998-2029. All rights reserved.

14 文件名: noblockApp.c

15 作者: 左忠凯

16 版本: V1.0

17 描述: 非阻塞访问测试APP

18 其他: 无

19 使用方法:./blockApp /dev/blockio 打开测试App

20 论坛: www.openedv.com

21 日志: 初版V1.0 2019/9/8 左忠凯创建

22 ***************************************************************/

23

24 /*

25 * @description : main主程序

26 * @param - argc : argv数组元素个数

27 * @param - argv : 具体参数

28 * @return : 0 成功;其他失败

29 */

30 int main(int argc, char *argv[])

31 {

32 int fd;

33 int ret = 0;

第52~73 行,这段代码使用poll 函数来实现非阻塞访问,在while 循环中使用poll 函数不断的轮询,检查驱动程序是否有数据可以读取,如果可以读取的话就调用read 函数读取按键数据。

第75~101 行,这段代码使用select 函数来实现非阻塞访问。

运行测试

1、编译驱动程序和测试APP

①、编译驱动程序

编写Makefile 文件,本章实验的Makefile 文件和第四十章实验基本一样,只是将obj-m 变量的值改为noblockio.o,Makefile 内容如下所示:

1 KERNELDIR := /home/zuozhongkai/linux/IMX6ULL/linux/temp/linux-imx-rel_imx_4.1.15_2.1.0_ga_alientek

......

4 obj-m := noblockio.o

......

11 clean:

12 $(MAKE) -C $(KERNELDIR) M=$(CURRENT_PATH) clean

第4 行,设置obj-m 变量的值为noblockio.o。

输入如下命令编译出驱动模块文件:

make -j32

编译成功以后就会生成一个名为“noblockio.ko”的驱动模块文件。

②、编译测试APP

输入如下命令编译测试noblockioApp.c 这个测试程序:

arm-linux-gnueabihf-gcc noblockioApp.c -o noblockioApp

编译成功以后就会生成noblcokioApp 这个应用程序。

2、运行测试

将上一小节编译出来noblockio.ko 和noblockioApp 这两个文件拷贝到

rootfs/lib/modules/4.1.15 目录中,重启开发板,进入到目录lib/modules/4.1.15 中,输入如下命令

加载blockio.ko 驱动模块:

depmod //第一次加载驱动的时候需要运行此命令

modprobe noblockio.ko //加载驱动

驱动加载成功以后使用如下命令打开noblockioApp 这个测试APP,并且以后台模式运行:

./noblockioApp /dev/noblockio &

按下开发板上的KEY0 按键,结果如图52.3.3.1 所示:

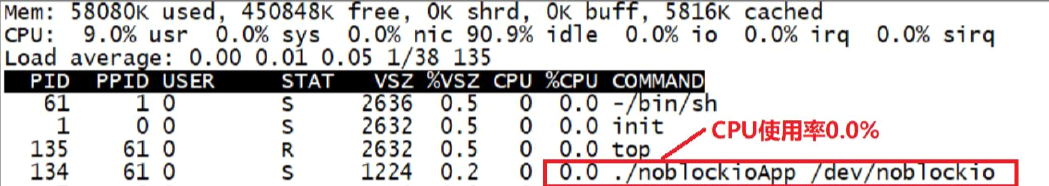

当按下KEY0 按键以后noblockioApp 这个测试APP 就会打印出按键值。输入“top”命令,查看noblockioAPP 这个应用APP 的CPU 使用率,如图52.3.3.2 所示:

从图52.3.3.2 可以看出,采用非阻塞方式读处理以后,noblockioApp 的CPU 占用率也低至0.0%,和图52.2.3.2 中的blockioApp 一样,这里的0.0%并不是说noblockioApp 这个应用程序不使用CPU 了,只是因为使用率太小了,而图中只能显示出小数点后一位,因此就显示成了0.0%。

如果要“杀掉”处于后台运行模式的noblockioApp 这个应用程序,可以参考52.2.3 小节讲解的方法。